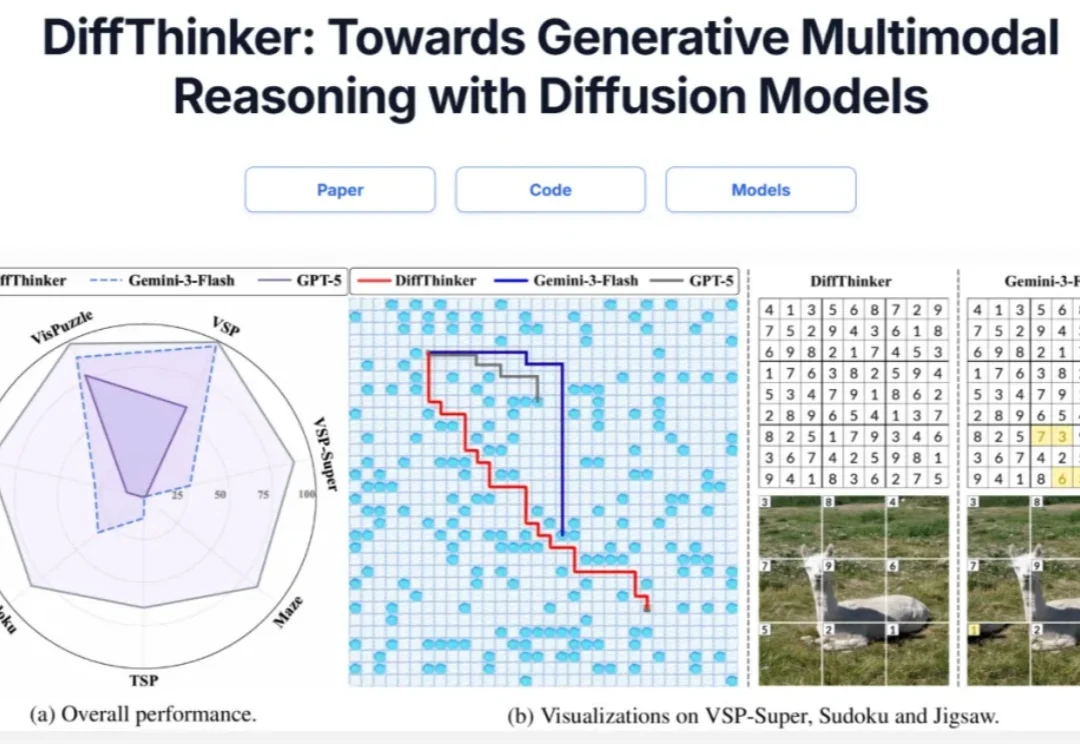

多模态推理新范式!DiffThinker:用扩散模型「画」出推理和答案

多模态推理新范式!DiffThinker:用扩散模型「画」出推理和答案在多模态大模型(MLLMs)领域,思维链(CoT)一直被视为提升推理能力的核心技术。然而,面对复杂的长程、视觉中心任务,这种基于文本生成的推理方式正面临瓶颈:文本难以精确追踪视觉信息的变化。形象地说,模型不知道自己想到哪一步了,对应图像是什么状态。

在多模态大模型(MLLMs)领域,思维链(CoT)一直被视为提升推理能力的核心技术。然而,面对复杂的长程、视觉中心任务,这种基于文本生成的推理方式正面临瓶颈:文本难以精确追踪视觉信息的变化。形象地说,模型不知道自己想到哪一步了,对应图像是什么状态。

刚刚,全球大模型第一股,终于在港交所敲钟!被称为中国版OpenAI的智谱正式挂牌上市(股票代码2513)。不仅拿下全球首家AGI基座模型上市公司头衔,首日开盘涨超3%,报120港元/股,市值突破528亿港元。

2023年启动大模型研发以来,腾讯第一次把大语言模型变成一把手工程,负责人是个27岁的年轻人;

FaithLens 模型在忠实性幻觉检测任务上,达到了当前最优效果。

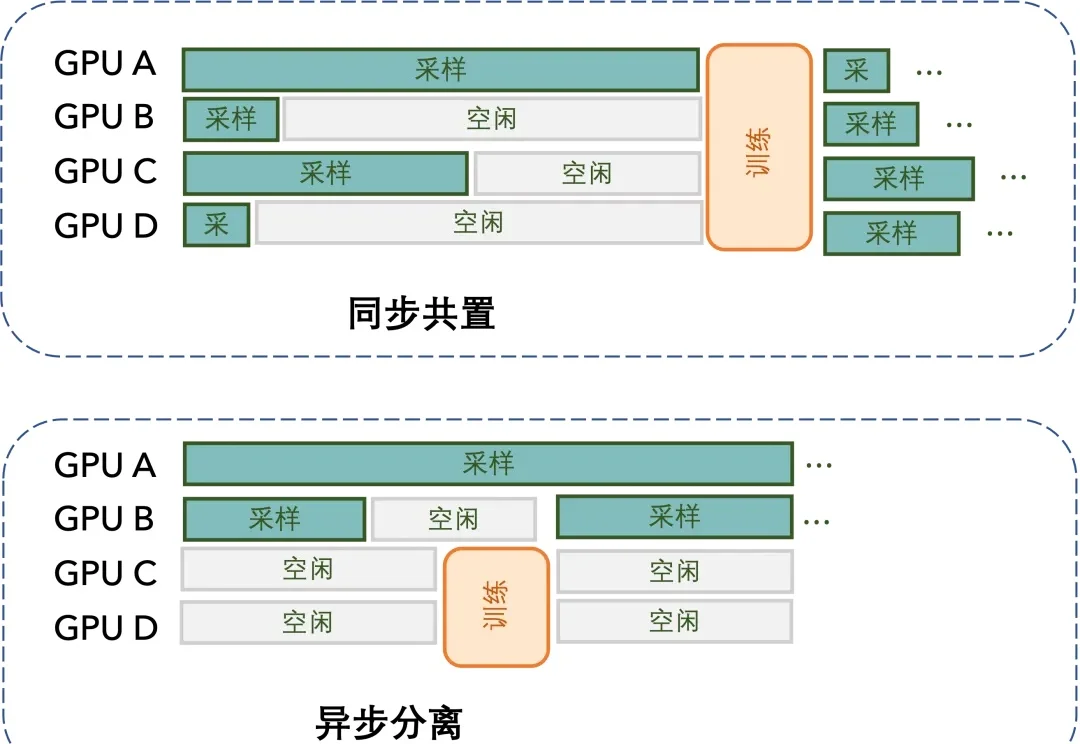

当大模型竞争转向后训练,继续为闲置显卡烧钱无异于「慢性自杀」。如今,按Token计费的Serverless模式,彻底终结了算力租赁的暴利时代,让算法工程师真正拥有了定义物理世界的权利。

央企第一家AI独角兽,诞生了。

Andrej Karpathy 大神力荐的 Vibe Coding,正在成为开发者的新宠。这种「只需聊一聊,AI 可以把功能写出来」的体验,极大提升了简单任务的开放效率。

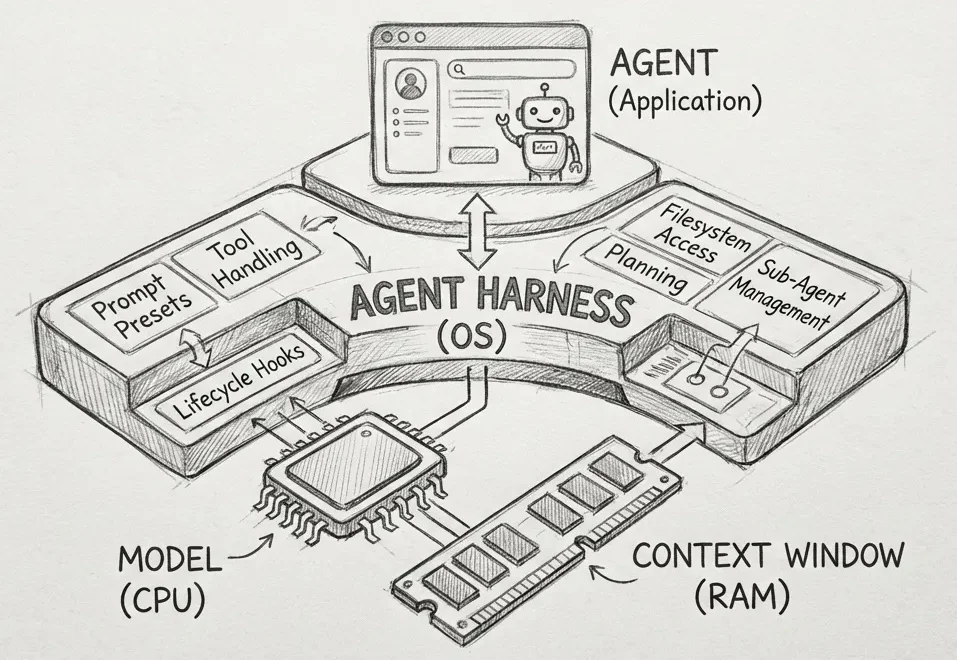

这篇文章的思路来自 Philipp Schmid,由 minghao 推荐 https://www.philschmid.de/agent-harness-2026

当 OpenAI 前 CTO Mira Murati 创立的 Thinking Machines Lab (TML) 用 Tinker 创新性的将大模型训练抽象成 forward backward,optimizer step 等⼀系列基本原语,分离了算法设计等部分与分布式训练基础设施关联,

这两年一直在关注 AI,Claude Code 给我带来的震撼,和当初 Nano Banana 在画图领域的革命,几乎是一个级别。