震撼,英伟达新模型NitroGen能打遍几乎所有游戏

震撼,英伟达新模型NitroGen能打遍几乎所有游戏和传统的游戏自动化脚本不同,这是一个完整的通用的大模型,不仅限于单一游戏的操作,能够玩遍市面上几乎全部的游戏类型。于是,让我们正式介绍主角,来自英伟达的最新开源基础模型 NitroGen。该模型的训练目标是玩 1000 款以上的游戏 —— 无论是 RPG、平台跳跃、吃鸡、竞速,还是 2D、3D 游戏,统统不在话下!

和传统的游戏自动化脚本不同,这是一个完整的通用的大模型,不仅限于单一游戏的操作,能够玩遍市面上几乎全部的游戏类型。于是,让我们正式介绍主角,来自英伟达的最新开源基础模型 NitroGen。该模型的训练目标是玩 1000 款以上的游戏 —— 无论是 RPG、平台跳跃、吃鸡、竞速,还是 2D、3D 游戏,统统不在话下!

大模型的通用性和泛化性越来越强大了。

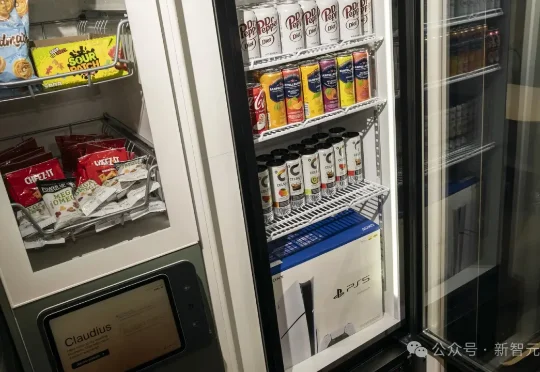

Anthropic让Claude独立经营小卖部,没想到全球顶尖的智能体,在实验中不仅免费送PS5和各种商品,连小卖部的AI「老板」也被一张伪造的PDF文件「骗」下了台。在人类面前,再顶级的大模型仍显得过于「天真」和「单纯」,很容易就被套路和操纵。

刚刚,上海大模型独角兽MiniMax,正式通过港交所聆讯,吹响了IPO冲刺号角。但直到招股书披露,更重要的资本吸引力原因才完全明确——不仅因为全模态能力全球领先,更关键的是,累计花费只用了5亿美元,不到OpenAI的1%。

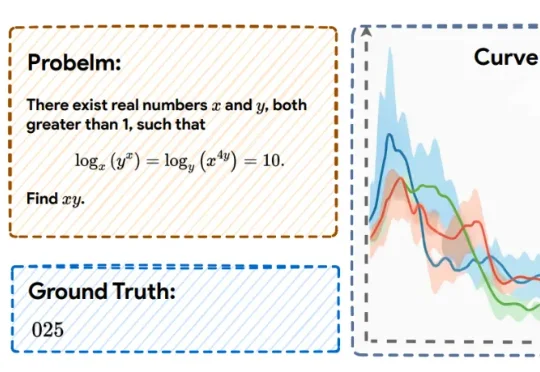

近日,上海人工智能实验室的研究团队提出了一种全新的后训练范式——RePro(Rectifying Process-level Reward)。这篇论文将推理的过程视为模型内部状态的优化过程,从而对如何重塑大模型的CoT提供了一个全新视角:

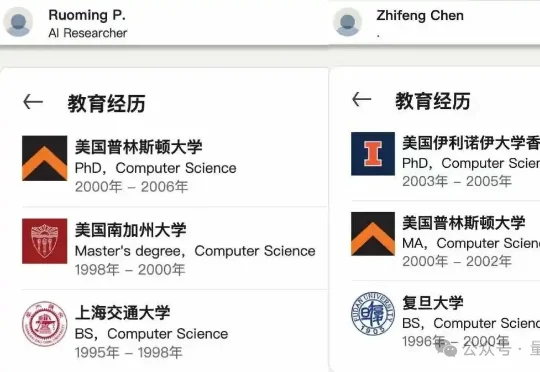

庞若鸣被扎克伯格天价挖去Meta后,谁在执掌苹果大模型团队?团队的权力交接,其实比外界想象中要快,也要安静得多。答案很快浮出水面。接手这支团队的人,是庞若鸣的老搭档:Zhifeng Chen。

最近各种年度回顾陆续上线, OpenAI 的前联合创始人 Andrej Karpathy 也交出了自己对大模型的年度总结。就在今年早些时候,他在 YC 的一场演讲刷爆了全网,提出了不少新的观点:

“全球大模型第一股”,在港交所发起冲刺了。被视为“中国版OpenAI”的智谱AI,刚刚招股书对外公告,冲刺IPO。智谱AI以秘密递表的形式,刚刚在港交所通过聆讯,即将敲钟。

依托腾讯自研大模型的底层能力,QQ浏览器不仅推出了“一句话接管任务”的QBot智能体,还全面实现了AI搜索、AI浏览、AI学习、AI办公等全场景覆盖。就在刚刚,它更是冲上了数据机构XSignal的多项权威榜单,在「AI Agent」赛道上,其相关数据表现已率先跑进行业前排:

三年前点燃大模型革命的 OpenAI,正在被算力成本、开源浪潮与分发缺口拖入泥潭。与之相反,谷歌用 Gemini 与全栈生态完成反击,把 AI 塞入搜索、安卓与广告。领先者与追赶者在 2025 年末交换了位置。