大模型刷数学题竟有害?CMU评估20+模型指出训练陷阱

大模型刷数学题竟有害?CMU评估20+模型指出训练陷阱学好数理化,走遍天下都不怕! 这一点这在大语言模型身上也不例外。

学好数理化,走遍天下都不怕! 这一点这在大语言模型身上也不例外。

香港大学NLP团队联合字节跳动Seed、复旦大学发布名为Polaris的强化学习训练配方:通过Scaling RL,Polaris让4B模型的数学推理能力(AIME25上取得79.4,AIME24上取得81.2)超越了一众商业大模型,如Seed-1.5-thinking、Claude-4-Opus和o3-mini-high(25/01/31)。

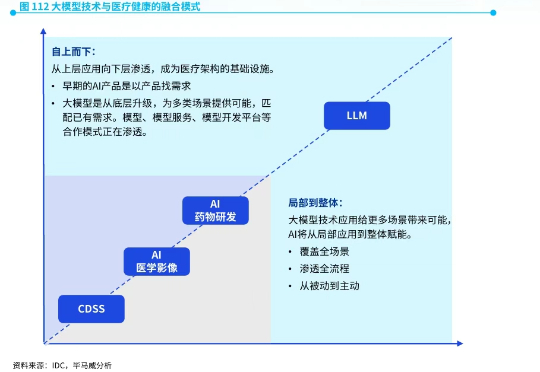

近日,全球四大会计师事务所之一毕马威中国发布了《首届健康科技50》报告。

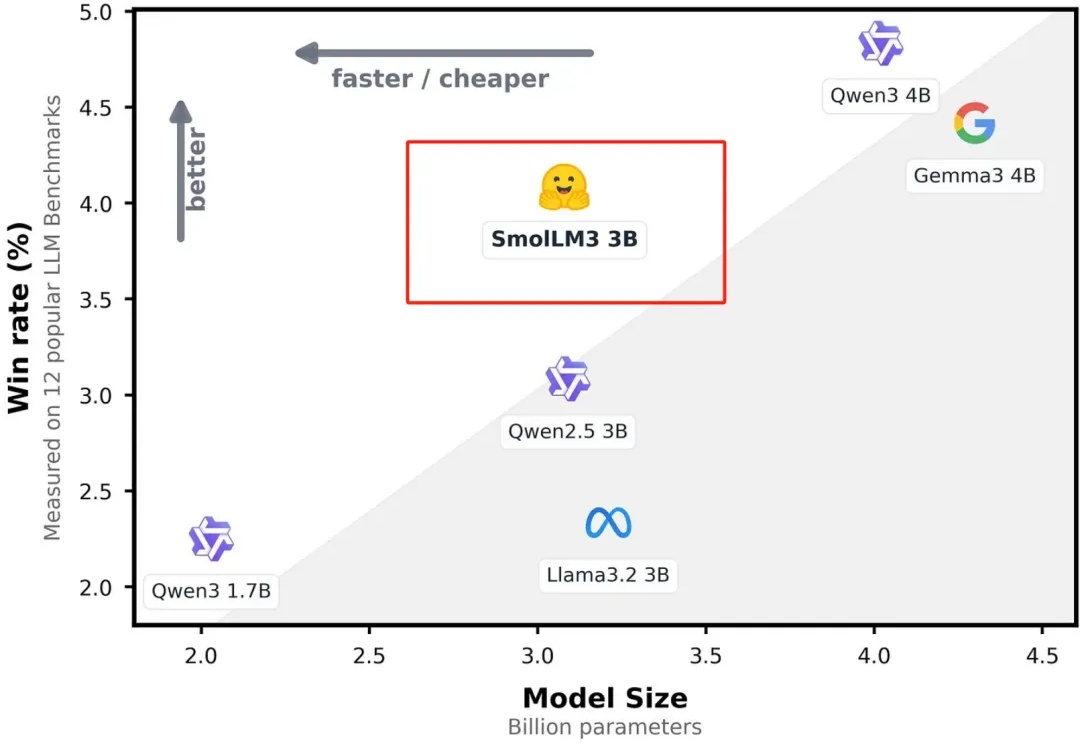

今天凌晨,全球著名大模型开放平台Hugging Face开源了,顶级小参数模型SmolLM3。

当ChatGPT横空出世时,它以空前的方式将AI 议题推至公众视野的核心。然而,同时迸发的诸多讨论却固着于恐惧、忧虑与批判情绪。

7月8日消息,谷歌智能体业务主管奥马尔·沙姆斯(Omar Shams)近日做客播客节目《Manifold》,接受了密歇根州立大学计算数学教授、大模型应用开发商Superfocus.ai创始人Steve Hsu的专访。沙姆斯曾创办AI初创公司Mutable,后被谷歌收购。

小扎就连苹果也没有放过。刚刚,苹果基础模型团队负责人Ruoming Pang被曝加入Meta,竟因苹果内部一直探索OpenAI等模型,团队士气下滑。他的离开,让苹果AI的未来更加扑朔迷离。

牛津哲学家认为,AI难以取代那些人类存在本身即具有意义且依赖深层社会关系的职业,尤其以牧师(精神信仰传播)、政客(立场制造与协商)和娼妓(权力与亲密互动)为代表。

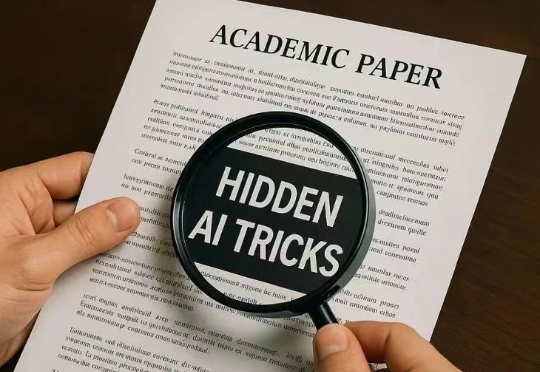

顶尖高校的论文,竟玩起了AI隐形魔法。外媒重磅揭秘,全球14所名校的17篇论文中,竟偷偷用肉眼不可见的字体,塞进了「只需夸,不许黑」的AI提示,试图忽悠大模型审稿给高分。

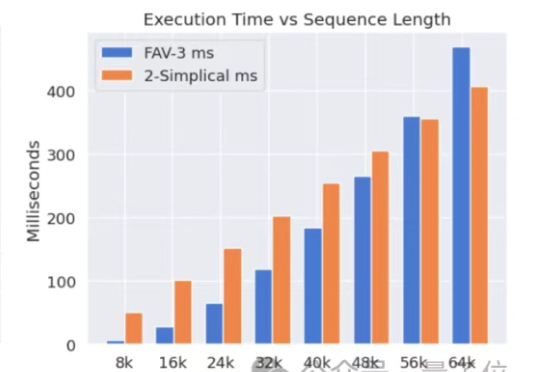

Meta挖走OpenAI大批员工后,又用OpenAI的技术搞出新突破。新架构名为2-Simplicial Transformer,重点是通过修改标准注意力,让Transformer能更高效地利用训练数据,以突破当前大模型发展的数据瓶颈。