揭开大模型“伪遗忘”,港理工等团队:结构不变就是没忘

揭开大模型“伪遗忘”,港理工等团队:结构不变就是没忘近年来,大语言模型(LLMs)的能力突飞猛进,但随之而来的隐私风险也逐渐浮出水面。

近年来,大语言模型(LLMs)的能力突飞猛进,但随之而来的隐私风险也逐渐浮出水面。

文章探讨AI时代深度思考的困境:大语言模型使人类思维系统萎缩,即时生成内容取代有机思考过程,削弱直觉与思辨力。作者以自身创作瓶颈为例,指出依赖AI导致认知基础流失,廉价知识无法替代深层理解,强调原始思考过程的价值,认为未经修饰的人类思考仍有独特意义。

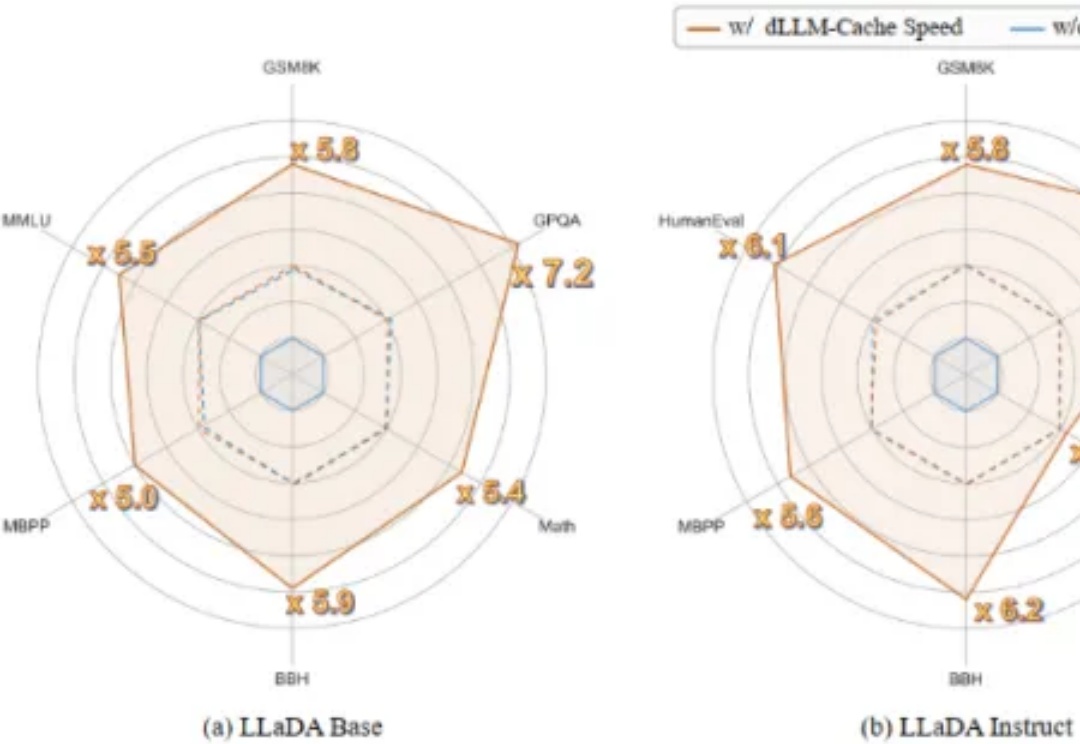

近日,NVIDIA 联合香港大学、MIT 等机构重磅推出 Fast-dLLM,以无需训练的即插即用加速方案,实现了推理速度的突破!通过创新的技术组合,在不依赖重新训练模型的前提下,该工作为扩散模型的推理加速带来了突破性进展。本文将结合具体技术细节与实验数据,解析其核心优势。

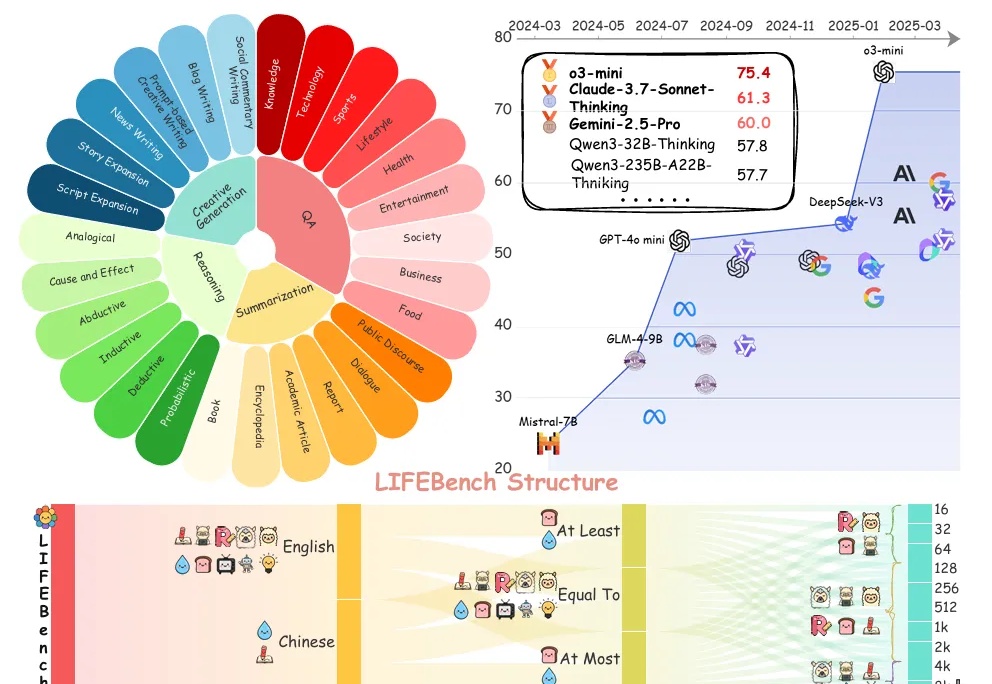

你是否曾对大语言模型(LLMs)下达过明确的“长度指令”?

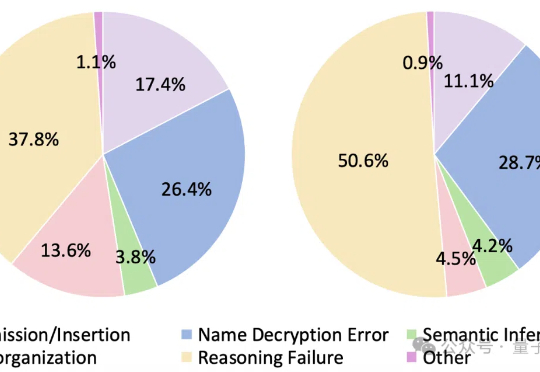

大语言模型遇上加密数据,即使是最新Qwen3也直冒冷汗!

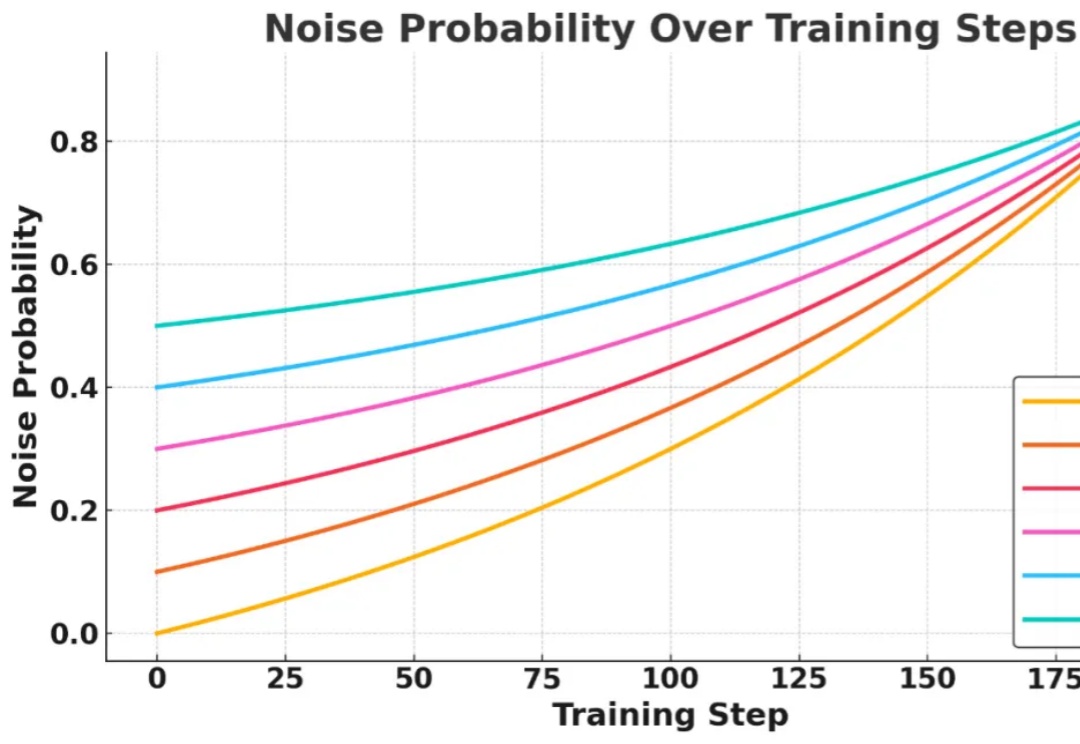

信息检索能力对提升大语言模型 (LLMs) 的推理表现至关重要,近期研究尝试引入强化学习 (RL) 框架激活 LLMs 主动搜集信息的能力,但现有方法在训练过程中面临两大核心挑战:

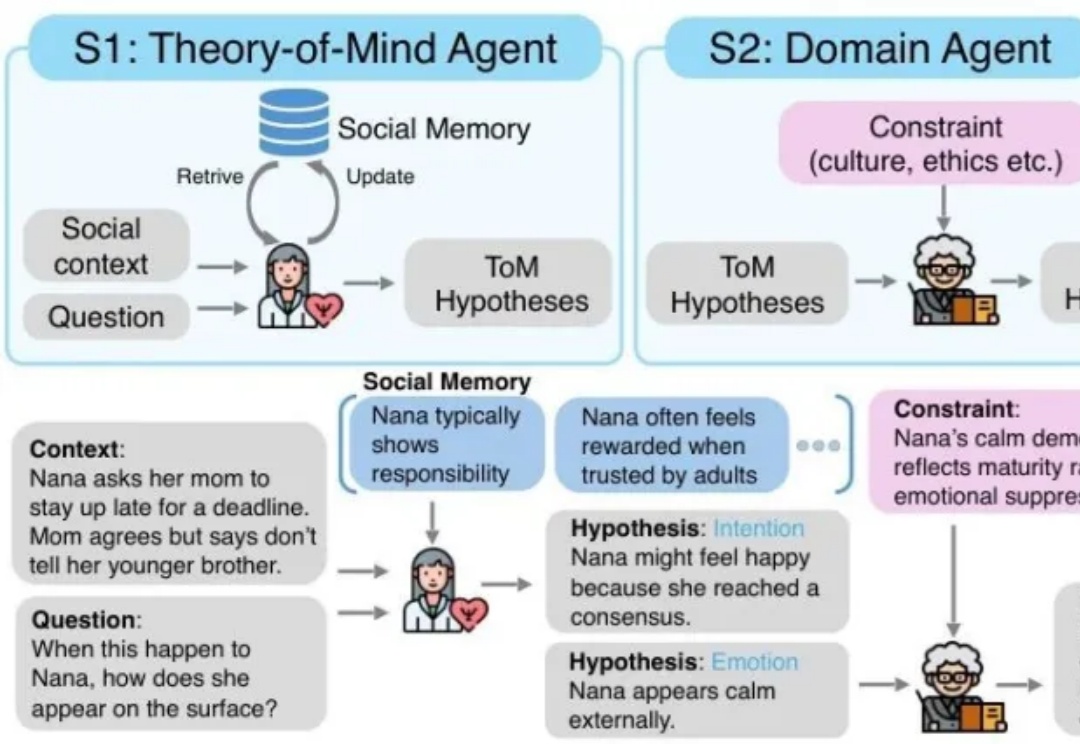

MetaMind是一个多智能体框架,专门解决大语言模型在社交认知方面的根本缺陷。传统的 LLM 常常难以应对现实世界中人际沟通中固有的模糊性和间接性,无法理解未说出口的意图、隐含的情绪或文化敏感线索。MetaMind首次使LLMs在关键心理理论(ToM)任务上达到人类水平表现。

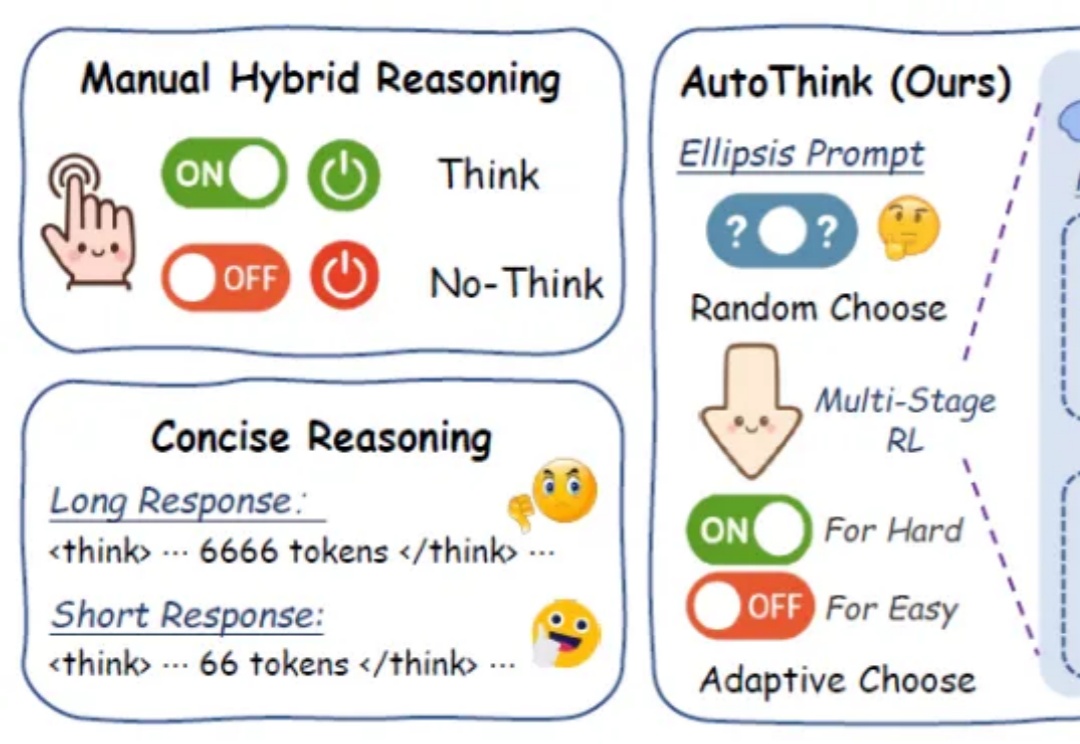

在日益强调“思维能力”的大语言模型时代,如何让模型在“难”的问题上展开推理,而不是无差别地“想个不停”,成为当前智能推理研究的重要课题。

我们采用了AI暴露度指标构建的方法,随机抽取了2018年1月到2024年5月的125万条招聘大数据进行分析,并最终计算出每个职业的AI大语言模型暴露度。

首个用于加速扩散式大语言模型(diffusion-based Large Language Models, 简称 dLLMs)推理过程的免训练方法。