从LLM大模型到SLM小模型再到TinyML,这个领域有望增长31倍并催生新的商业模式

从LLM大模型到SLM小模型再到TinyML,这个领域有望增长31倍并催生新的商业模式生成式人工智能GenAI是否存在泡沫?这个问题日益成为业界热议的焦点。目前,全球对AI基础设施的投资已到了癫狂的成千上万亿美元的规模,然而大模型如何实现盈利却始终没有一个明确的答案。

生成式人工智能GenAI是否存在泡沫?这个问题日益成为业界热议的焦点。目前,全球对AI基础设施的投资已到了癫狂的成千上万亿美元的规模,然而大模型如何实现盈利却始终没有一个明确的答案。

商汤科技联合创始人、执行董事徐冰出席香港金融科技周活动,并与前福布斯记者Olivia Kinghorst做现场对谈。在近20分钟的对话中,双方讨论了AI云平台市场趋势、投资判断、超级应用、竞争格局等话题。

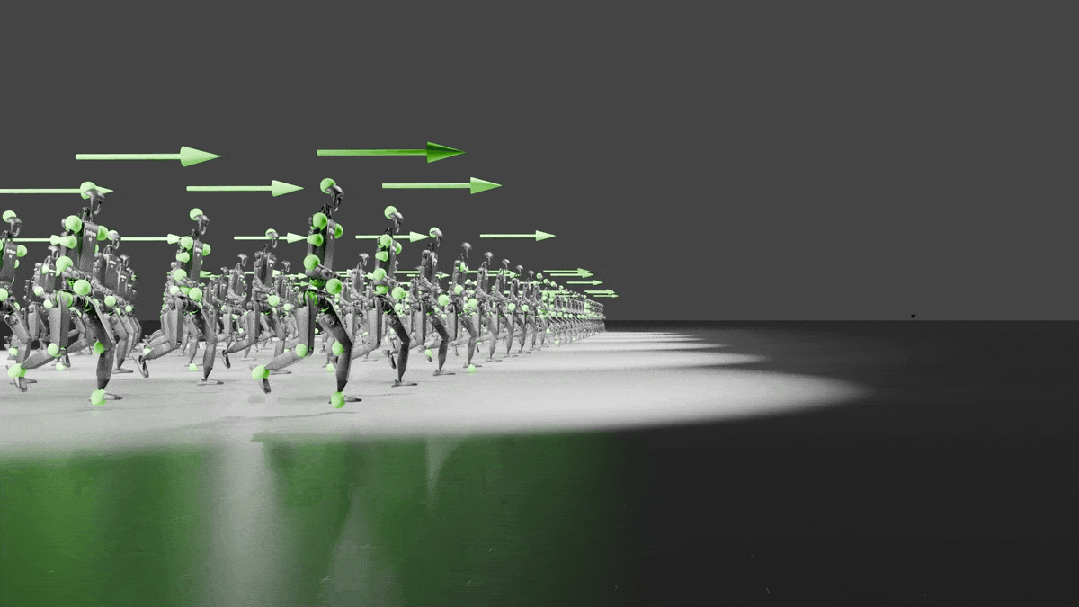

来自英伟达、CMU、UC伯克利等的全华人团队提出一个全新的人形机器人通用的全身控制器HOVER,仅用一个1.5M参数模型就可以控制人形机器人的身体。人形机器人的运动和操作之前只是外表看起来类人,现在有了HOVER,连底层运动逻辑都可以类人了!

大模型固然性能强大,但限制也颇多。如果想在端侧塞进 405B 这种级别的大模型,那真是小庙供不起大菩萨。近段时间,小模型正在逐渐赢得人们更多关注。这一趋势不仅出现在语言模型领域,也出现在了机器人领域。

Zamba2-7B是一款小型语言模型,在保持输出质量的同时,通过创新架构实现了比同类模型更快的推理速度和更低的内存占用,在图像描述等任务上表现出色,能在各种边缘设备和消费级GPU上高效运行。

Mistral 7B诞生一周年之际,法国AI初创公司Mistral再次连发两个轻量级模型Ministral 3B和Ministral 8B,性能赶超Llama 3 8B。

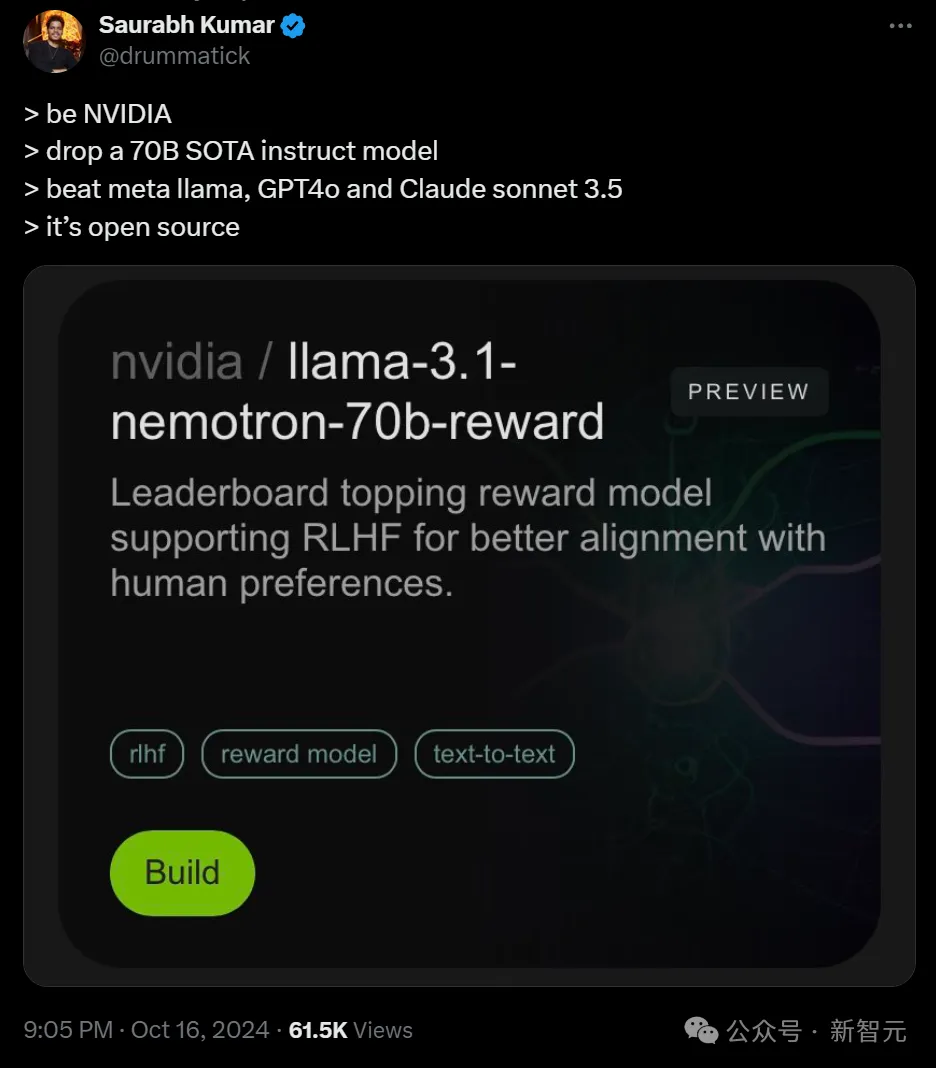

英伟达开源了超强模型Nemotron-70B,后者一经发布就超越了GPT-4o和Claude 3.5 Sonnet,仅次于OpenAI o1!AI社区惊呼:新的开源王者又来了?业内直呼:用Llama 3.1训出小模型吊打GPT-4o,简直是神来之笔!

欧洲的OpenAI,也不Open了。

微软 10 年「老兵」选择离开。

大语言模型市场的整合与差异:大语言模型市场存在整合的趋势。一方面,人工智能发展的基础产业是资本密集型的,市场整合对于大语言模型市场的资本支撑是必要的。另一方面,为尽可能提高算法的泛化能力,单个大语言模型也需要集成多种创新功能。市场集中度的提高使得企业需要进一步考虑大语言模型的差异化。