ICLR 2026还会好吗?300篇投稿50篇含幻觉,引用example.com竟也能过审

ICLR 2026还会好吗?300篇投稿50篇含幻觉,引用example.com竟也能过审这届 ICLR 的烦心事还没有结束。

这届 ICLR 的烦心事还没有结束。

关于如何避免让大语言模型产生幻觉,一直以来的相关研究都非常多。

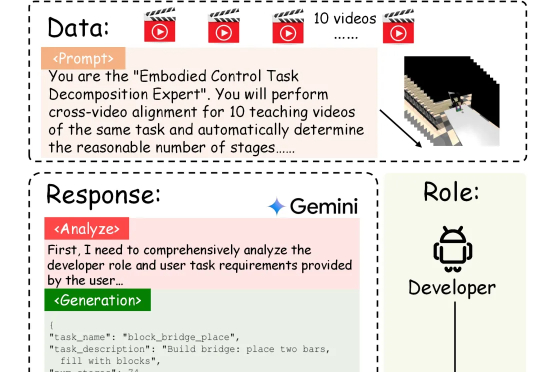

具身智能的「ChatGPT时刻」还没到,机器人的「幻觉」却先来了?在需要几十步操作的长序列任务中,现有的VLA模型经常「假装在干活」,误以为任务完成。针对这一痛点,北京大学团队提出自进化VLA框架EvoVLA。该模型利用Gemini生成「硬负样本」进行对比学习,配合几何探索与长程记忆,在复杂任务基准Discoverse-L上将成功率提升了10.2%,并将幻觉率从38.5%大幅降至14.8%。

在AI热潮里,故事比技术更值钱。一家名为Oklo的核能初创公司,靠着一个概念,市值飙到210亿美元;另一边,一个从SpaceX离职的工程师,让AI自己画电路板,几分钟搞定工程师三天的工作。一个靠叙事吸引资金,一个用技术推动生产。AI热潮下,这两家公司代表着同一时代的两种姿态——造梦,和造物。

“我活到 108 岁,试茶 80 多年了。” 2025 年 10 月,已故八年的“茶界泰斗”张天福再次“开口”,为福建张天福品牌管理有限公司代言。 张天福之子张德友称此举已获合法授权,而遗孀张晓红则痛

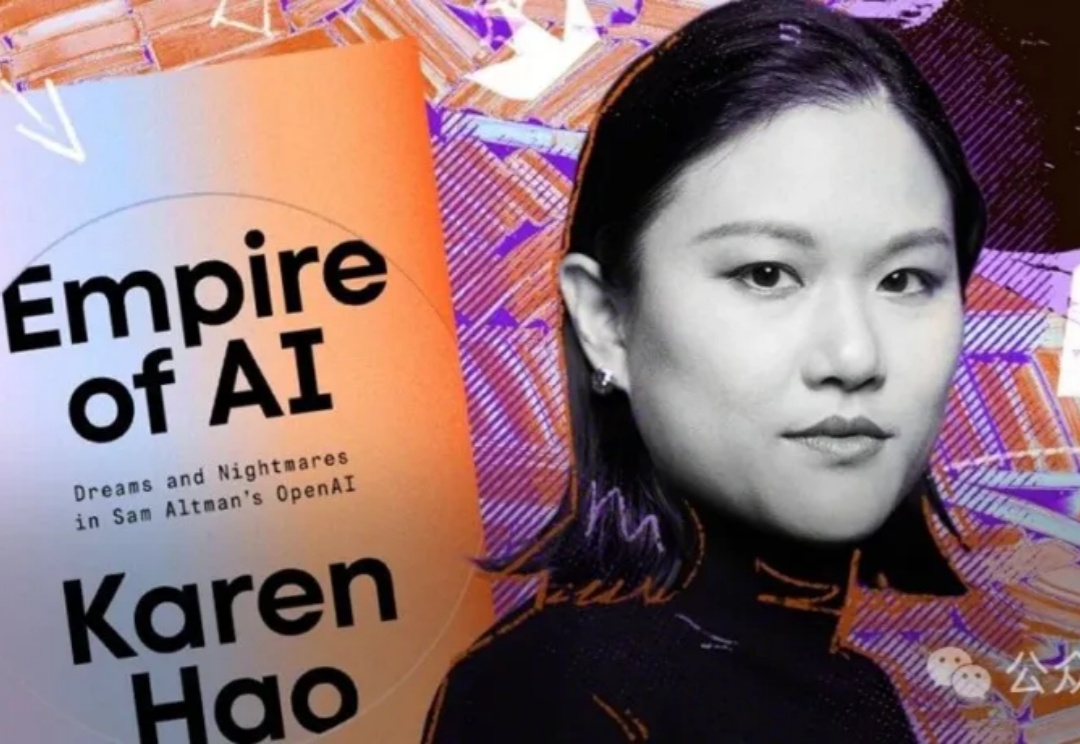

当硅谷把「AGI造福全人类」包装成信仰时,真实世界却在付出代价。Karen Hao在《Empire of AI》犀利指出,这场竞赛甚至被渲染成「中美对抗」——只要跑赢中国,就能守护自由。但事实是,美国与中国差距并未拉大,唯一真正收割的,是硅谷自己。我们是否还要为这场幻觉买单?

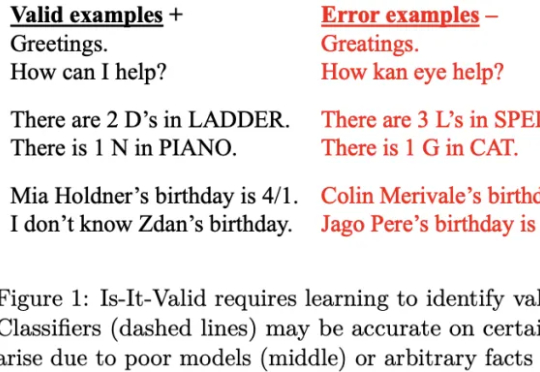

《Science》的一篇新文章指出,大模型存在一个先天难解的软肋:幻觉难以根除。AI厂商让大模型在不确定性情况下说「我不知道」,虽然有助于减少模型幻觉,但可能因此影响用户留存与活跃度,动摇商业根本。

十月,《纽约时报》发表了题为《The A.I. Prompt That Could End the World》(《那个可能终结世界的 AI 提示词》)的文章。作者 Stephen Witt 采访了多位业内人士:有 AI 先驱,图灵奖获奖者 Yoshua Bengio;以越狱测试著称的 Leonard Tang;以及专门研究模型欺骗的 Marius Hobbhahn。

时隔两月,Baichuan-M2 Plus重磅出世!成为业内首个循证增强的医疗大模型,幻觉要比DeepSeek-R1低3倍,可信度比肩资深临床专家。新模型将「循证医学」理念深度融入训练和推理,通过首创「六源循证范式」,模拟人类医生思维,有效辨别不同层级医学证据、评估其可靠性,并在回答中优先引用高等级证据。

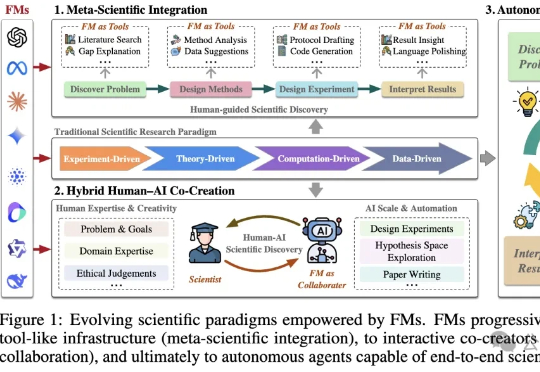

基础模型(FM)是一种在海量数据上训练的人工智能系统,具备强大的通用性和跨模态能力。港科大最新发表的论文显示:FM可能引领科学进入第五范式,但大模型的偏见、幻觉等问题仍需正视。