全新合成框架SOTA:强化学习当引擎,任务合成当燃料,蚂蚁港大联合出品

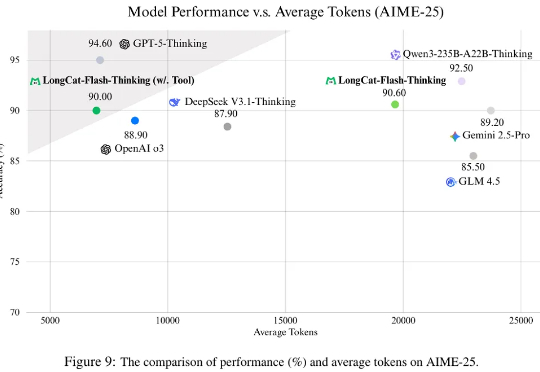

全新合成框架SOTA:强化学习当引擎,任务合成当燃料,蚂蚁港大联合出品蚂蚁通用人工智能中心自然语言组联合香港大学自然语言组(后简称“团队”)推出PromptCoT 2.0,要在大模型下半场押注任务合成。实验表明,通过“强起点、强反馈”的自博弈式训练,PromptCoT 2.0可以让30B-A3B模型在一系列数学代码推理任务上实现新的SOTA结果,达到和DeepSeek-R1-0528, OpenAI o3, Gemini 2.5 Pro等相当的表现。