240万亿巨量数据被洗出,足够训出18个GPT-4!全球23所机构联手,清洗秘籍公开

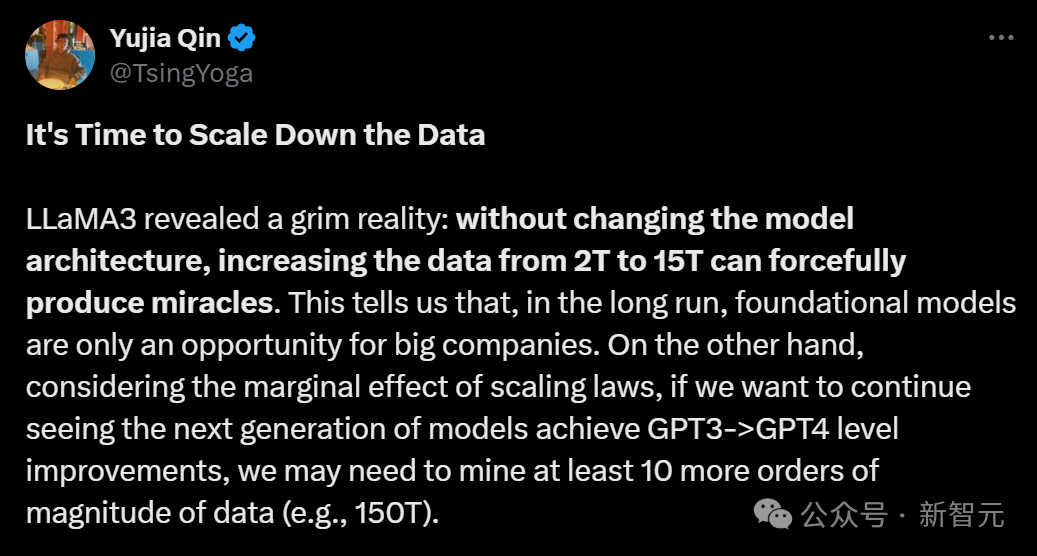

240万亿巨量数据被洗出,足够训出18个GPT-4!全球23所机构联手,清洗秘籍公开是时候把数据Scale Down了!Llama 3揭示了这个可怕的事实:数据量从2T增加到15T,就能大力出奇迹,所以要想要有GPT-3到GPT-4的提升,下一代模型至少还要150T的数据。好在,最近有团队从CommonCrawl里洗出了240T数据——现在数据已经不缺了,但你有卡吗?

是时候把数据Scale Down了!Llama 3揭示了这个可怕的事实:数据量从2T增加到15T,就能大力出奇迹,所以要想要有GPT-3到GPT-4的提升,下一代模型至少还要150T的数据。好在,最近有团队从CommonCrawl里洗出了240T数据——现在数据已经不缺了,但你有卡吗?

上周,不少人发现微软官网忽然更新了一条“GPT Builder 即将停用”的通知。宣布将从7月10日起终止对Copilot GPT的支持,并会在四天内把平台上所有已创建的GPT连同相关数据全部删除。

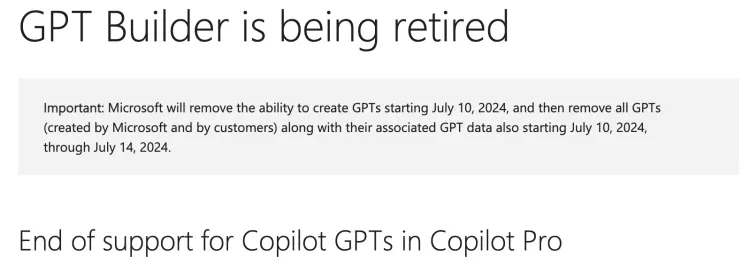

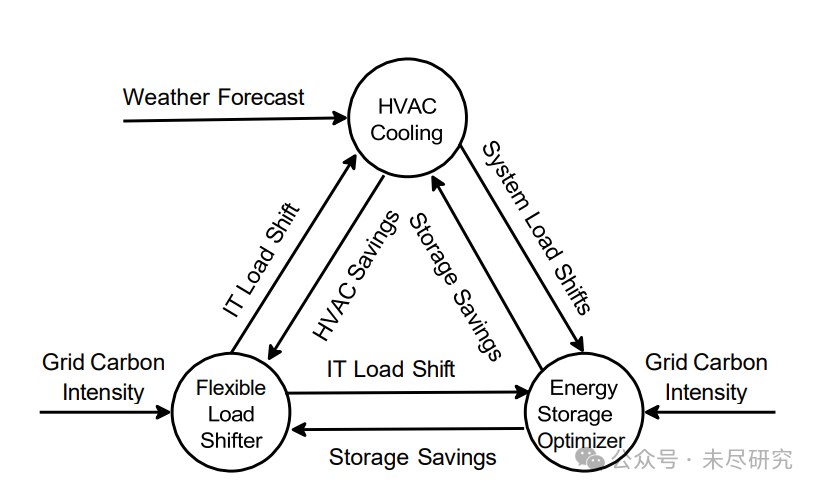

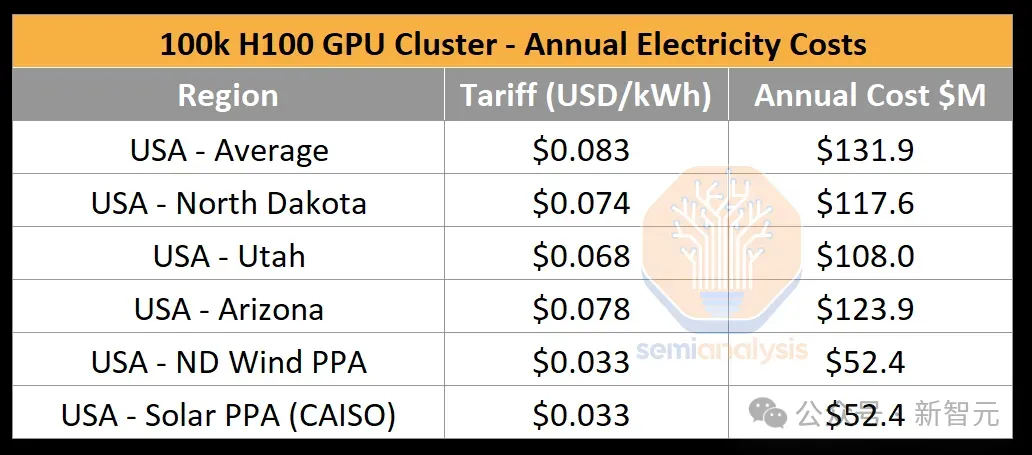

AI的终点是电力。因为数据中心最终要实现可持续发展,净零碳排放,AI的真正的终点是清洁电力。

在英伟达市值猛涨、各家科技巨头囤芯片的热潮中,我们往往会忽视GPU芯片是如何转变为数据中心算力的。最近,一篇SemiAnalysis的技术文章就深入解读了10万卡H100集群的构建过程。

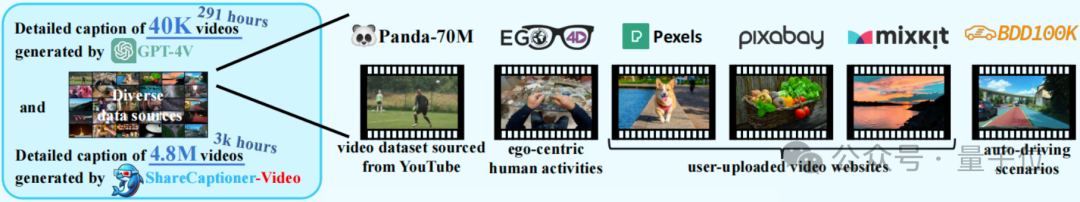

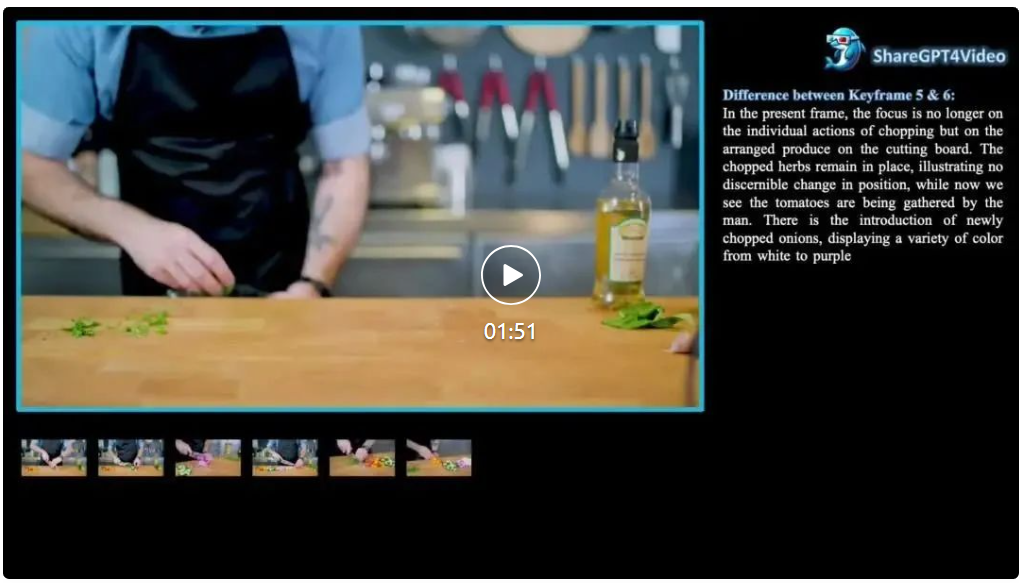

中科大、上海AI实验室等组成的ShareGPT4V团队,推出了新的视频数据集,登顶HuggingFace排行榜!

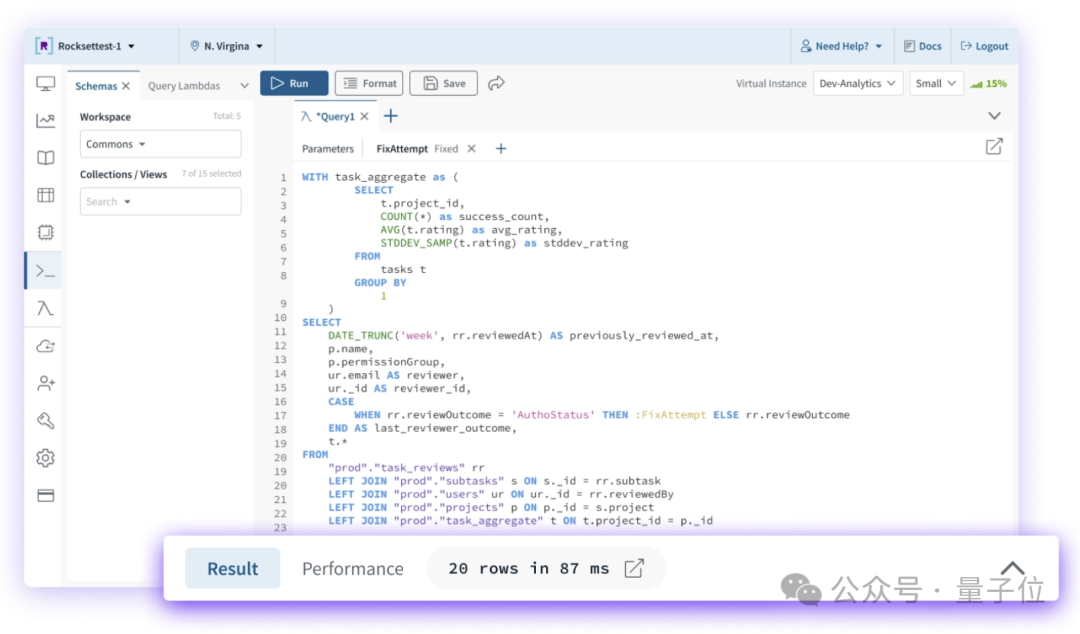

刚刚,OpenAI收购了数据库初创公司Rockset。

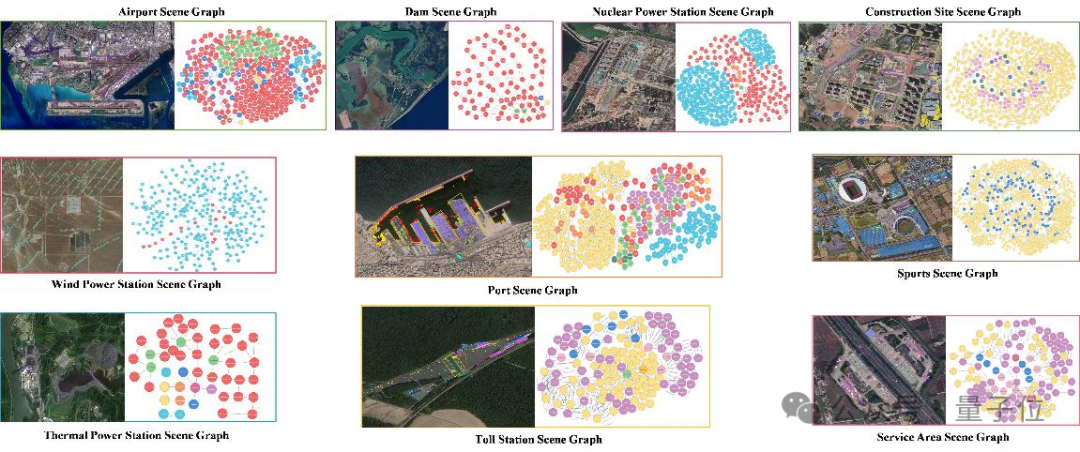

AI卫星影像知识生成模型数据集稀缺的问题,又有新解了。

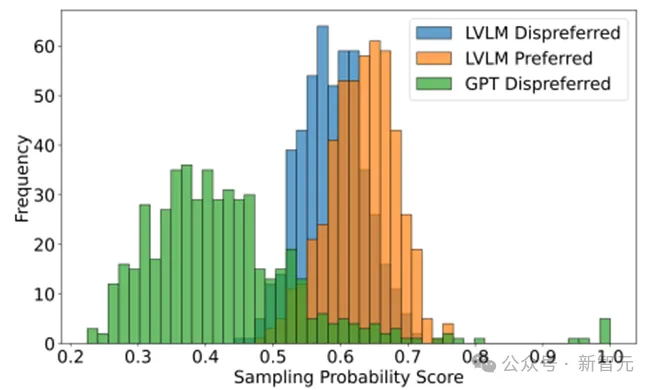

现有多模态大模型在对齐不同模态时面临幻觉和细粒度感知不足等问题,传统偏好学习方法依赖可能不适配的外源数据,存在成本和质量问题。Calibrated Self-Rewarding(CSR)框架通过自我增强学习,利用模型自身输出构造更可靠的偏好数据,结合视觉约束提高学习效率和准确性。

继Sora官宣之后,多模态大模型在视频生成方面的应用简直就像井喷一样涌现出来,LUMA、Gen-3 Alpha等视频生成模型展现了极佳质量的艺术风格和视频场景的细节雕刻能力,文生视频、图生视频的新前沿不断被扩展令大家惊喜不已,抱有期待。

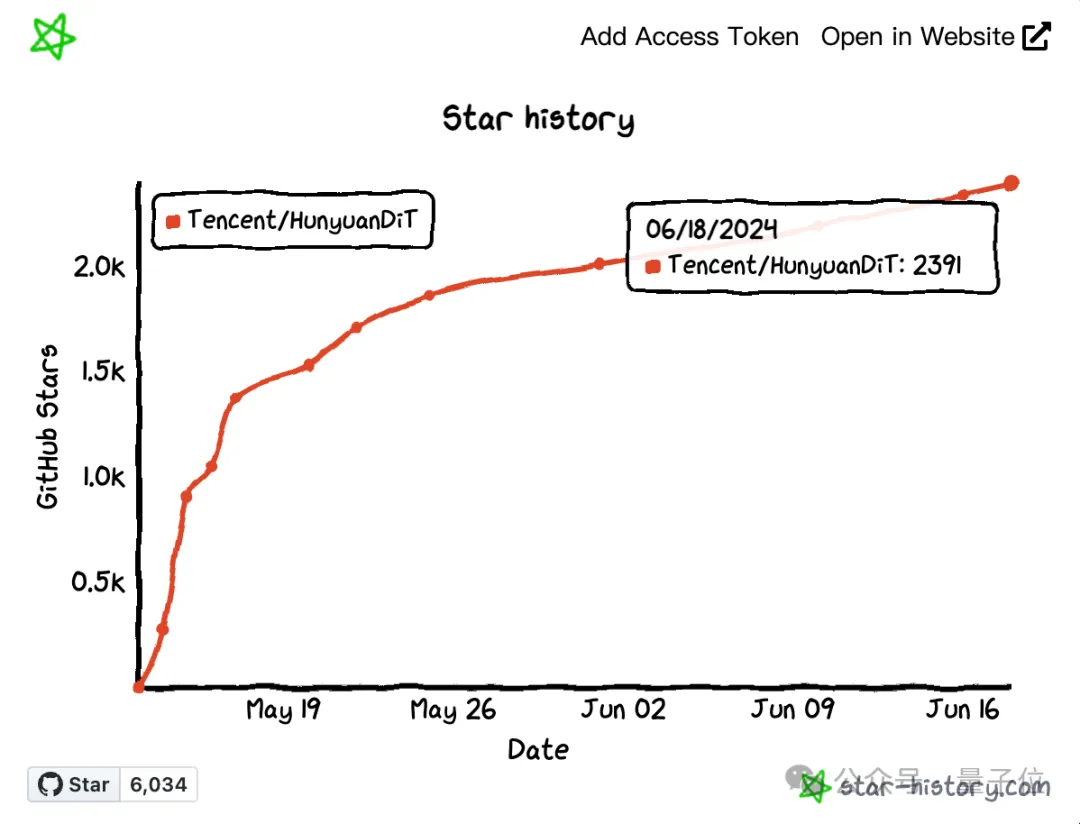

毕业季,大模型人才正在被各家大厂和创业公司重金哄抢。 刚刚,腾讯也曝光了他们与大模型相关的人才计划,并且直通2025年校招—— 将面向全球范围内大举扩招50%大模型人才,并且放话薪资算力什么的不用愁。 不出所料,各家抢人下手都既快又狠,晚一步生怕就抢不到(不是)。