谷歌发布最新「读屏」AI!PaLM 2-S自动生成数据,多项理解任务刷新SOTA

谷歌发布最新「读屏」AI!PaLM 2-S自动生成数据,多项理解任务刷新SOTA谷歌在语言和声控计算机界面的漫长道路上又迈出了重要一步。最新ScreenAI视觉语言模型,能够完成各种屏幕QA问答、总结摘要等任务。

谷歌在语言和声控计算机界面的漫长道路上又迈出了重要一步。最新ScreenAI视觉语言模型,能够完成各种屏幕QA问答、总结摘要等任务。

Mac用户,终于不用羡慕N卡玩家有专属大模型Chat with RTX了!

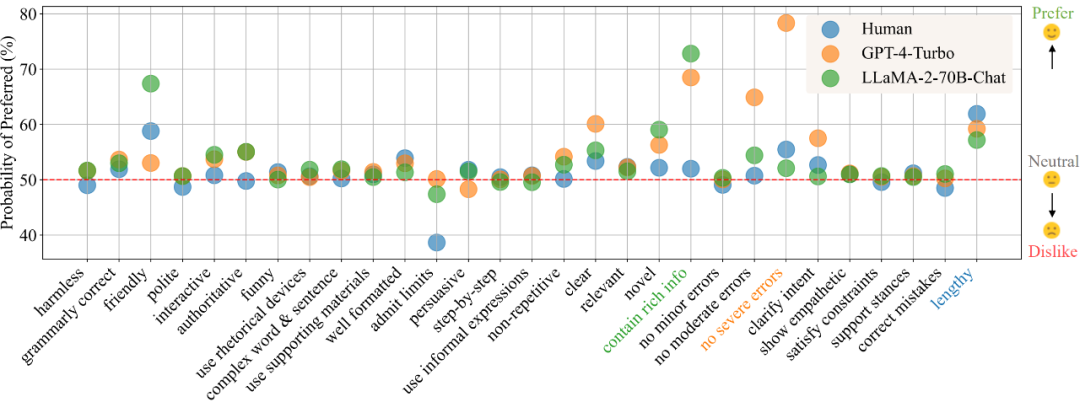

在目前的模型训练范式中,偏好数据的的获取与使用已经成为了不可或缺的一环。在训练中,偏好数据通常被用作对齐(alignment)时的训练优化目标,如基于人类或 AI 反馈的强化学习(RLHF/RLAIF)或者直接偏好优化(DPO),而在模型评估中,由于任务的复杂性且通常没有标准答案,则通常直接以人类标注者或高性能大模型(LLM-as-a-Judge)的偏好标注作为评判标准。

有人表示:「等待已久的 AI 图像创建功能终于迎来了图层!」

自曝996作息的OpenAI研究员Jason Wei表示,Sora代表着视频生成的GPT-2时刻。竞争的关键,就是算力和数据了。国内有可能成功「复刻」Sora吗?华人团队的这份37页技术报告,或许能给我们一些启发。

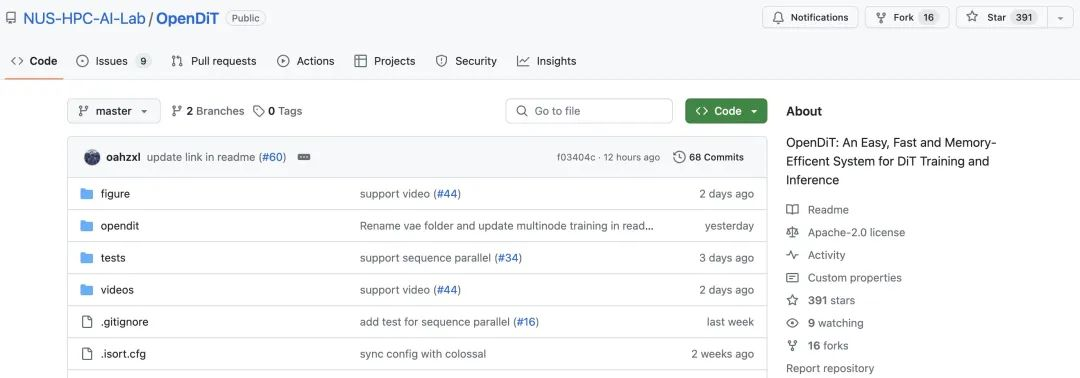

根据 OpenAI 披露的技术报告,Sora 的核心技术点之一是将视觉数据转化为 patch 的统一表征形式,并通过 Transformer 和扩散模型结合,展现了卓越的扩展(scale)特性。

Reddit和OpenAI及谷歌,竟有着如此错综复杂的关系?最近,Reddit和谷歌双双官宣了一项6000万美元的合作协议,Reddit的数据将帮助谷歌训练AI模型。巧的是,Altman正是Reddit股东之一。

近期,DiT(Diffusion Transformer)论文的作者谢赛宁在朋友圈分享了他对 Sora 的看法,其中核心资源的排序是——人才第一、数据第二、算力第三,其他都没有什么是不可替代的。

大模型的成功很大程度上要归因于 Scaling Law 的存在,这一定律量化了模型性能与训练数据规模、模型架构等设计要素之间的关系,为模型开发、资源分配和选择合适的训练数据提供了宝贵的指导。

没有微软账户就用不了 Windows?马斯克怒斥大厂收集用户数据训练 AI。