「个性化」图像生成时代来了!六大顶尖高校联手发布全新Gen4Gen框架

「个性化」图像生成时代来了!六大顶尖高校联手发布全新Gen4Gen框架过去几年里,基于文本来生成图像的扩散模型得到了飞速发展,生成能力有了显著的提升,可以很容易地生成逼真的肖像画,以及各种天马行空的奇幻画作。

过去几年里,基于文本来生成图像的扩散模型得到了飞速发展,生成能力有了显著的提升,可以很容易地生成逼真的肖像画,以及各种天马行空的奇幻画作。

去年年底以来,更多人 感受到了 AI 对生活的「入侵」 —— 我们开始在地铁、电梯间和商店看到了 AI 生成的广告图像

没有谁能一直称王,但加上前缀谁都有称王的机会。AI 文生图,还能玩出什么新花样?在这片群雄割据的红海,头部被 Midjourney、DALL·E、Stable Diffusion 等占据,其余还能让人眼前一亮的产品并不多。然而,仍有黑马杀出:Ideogram,前 Google 工程师创立,硅谷 AI 大神投资,去年 8 月面世,2 月底发布了最新的模型。

内部核心员工出走频繁,外部投资者不断丧失信心,成立于 2019 年的 AI 初创公司 Stability AI 还能推出伟大的产品吗?

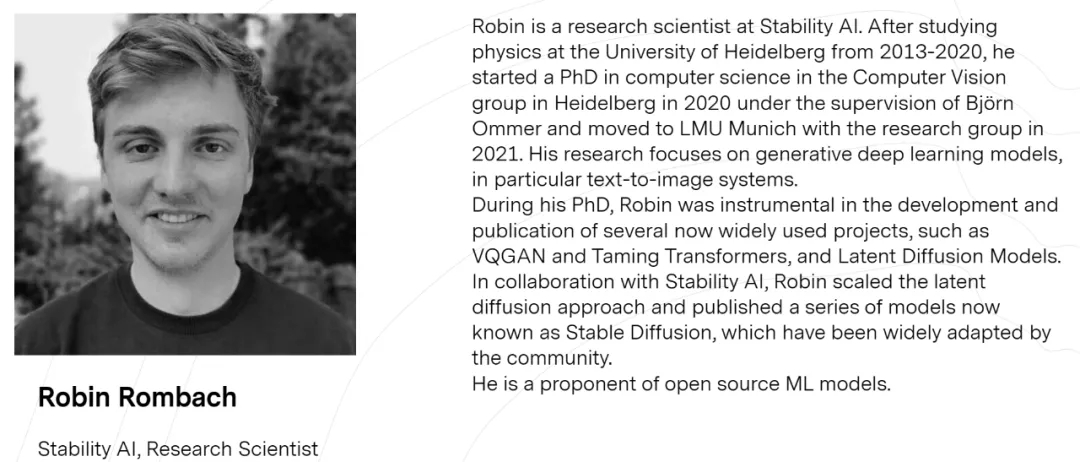

最新消息,Stable Diffusion核心研究团队已集体辞职!名单包括研究团队领导、论文一作Robin Rombach,共同一作Andreas Blattmann,以及另一位作者Dominik Lorenz。

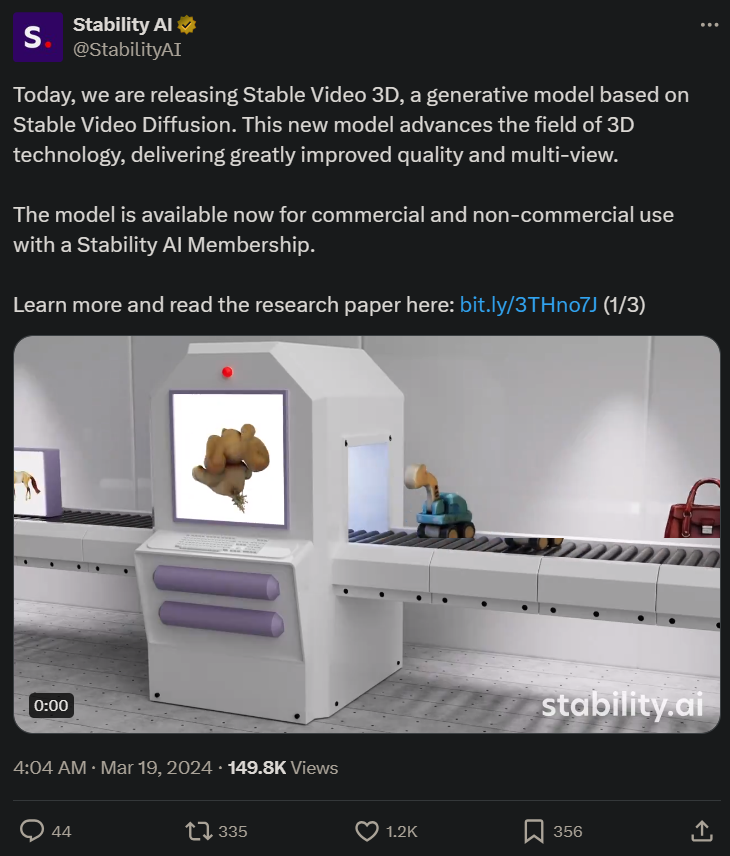

3D 生成领域迎来新的「SOTA 级选手」,支持商用和非商用。Stability AI 的大模型家族来了一位新成员。昨日,Stability AI 继推出文生图 Stable Diffusion、文生视频 Stable Video Diffusion 之后,又为社区带来了 3D 视频生成大模型「Stable Video 3D」(简称 SV3D)。

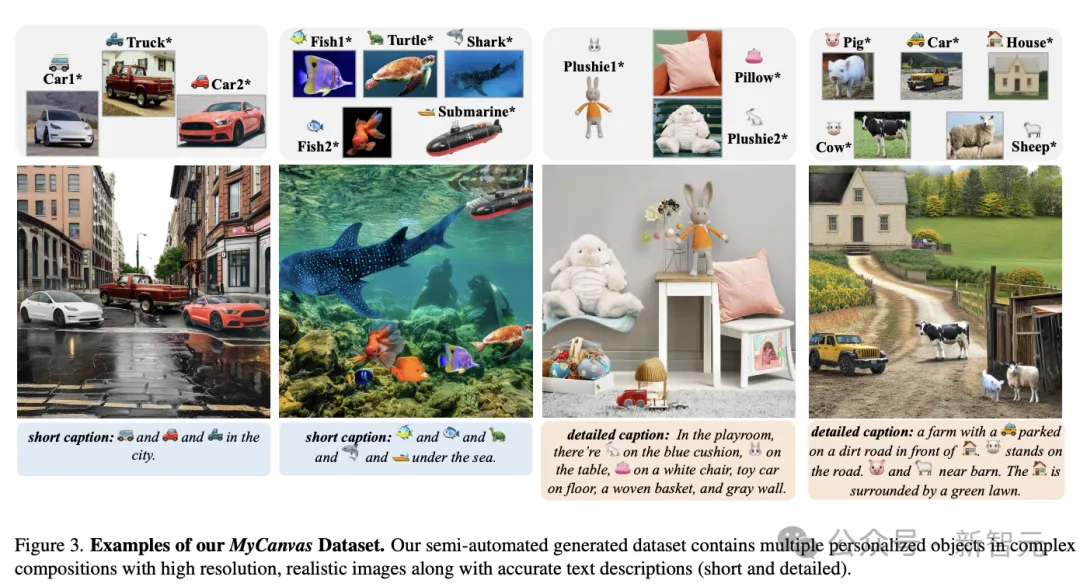

【新智元导读】利用文本生成图片(Text-to-Image, T2I)已经满足不了人们的需要了,近期研究在T2I模型的基础上引入了更多类型的条件来生成图像,本文对这些方法进行了总结综述。

本文编译自播客节目a16z。Stability AI的科学家Andreas Blattmann和Robin Rombach与a16z的合伙人Anjney Midha共同探讨从文本到视频人工智能的前沿世界。

生成式人工智能在个人电脑(PC)领域的应用成为新一轮角力之处,当前芯片厂商和 PC 品牌商都十分看好 AI PC 市场。相较于普通的 PC,AI PC 通过在电脑端运行经过压缩和优化的大模型,让用户体验到更多生成式 AI 应用,比如文生图、智能创作。

众所周知,开发顶级的文生图(T2I)模型需要大量资源,因此资源有限的个人研究者基本都不可能承担得起,这也成为了 AIGC(人工智能内容生成)社区创新的一大阻碍。同时随着时间的推移,AIGC 社区又能获得持续更新的、更高质量的数据集和更先进的算法。