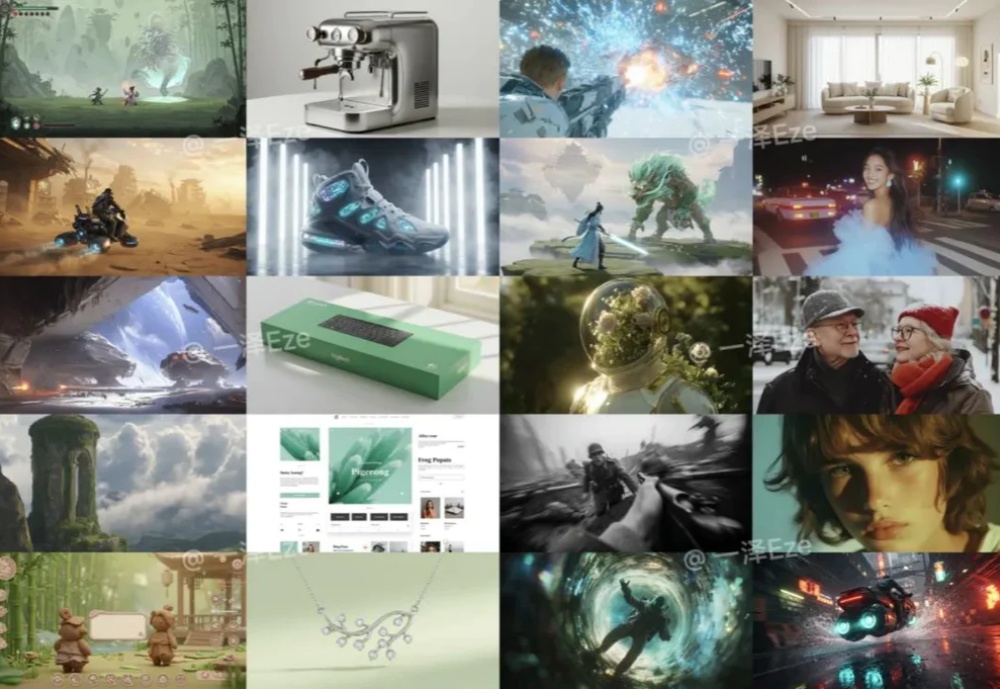

一个万能文生图提示框架,人人都能成为专业AI设计师

一个万能文生图提示框架,人人都能成为专业AI设计师最近各家文生图 AI 都在不断迭代。

最近各家文生图 AI 都在不断迭代。

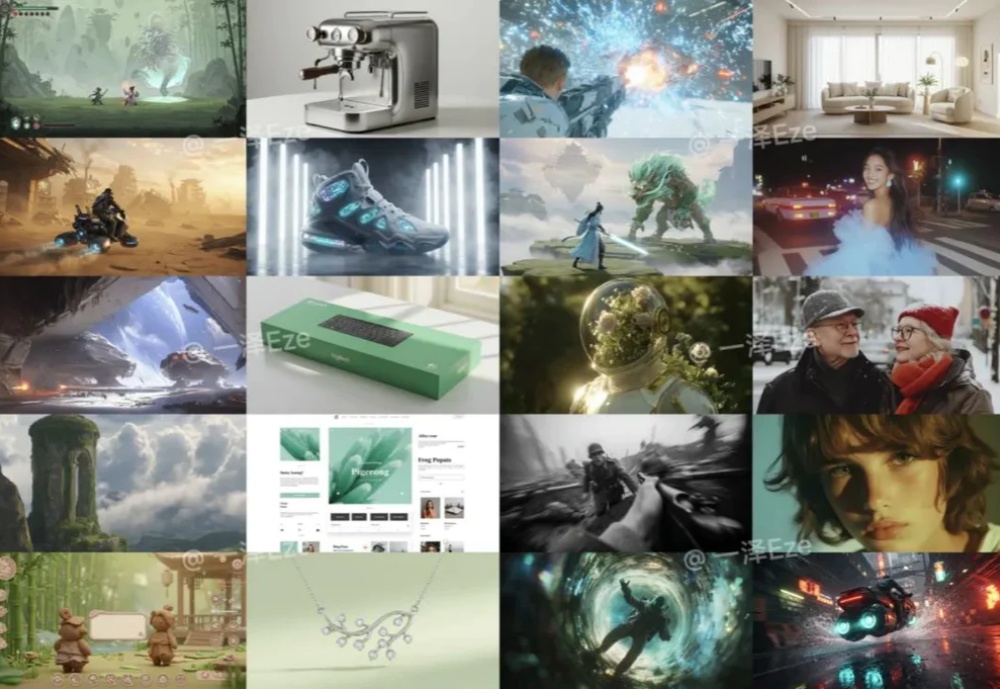

文生图 or 图生文?不必纠结了!

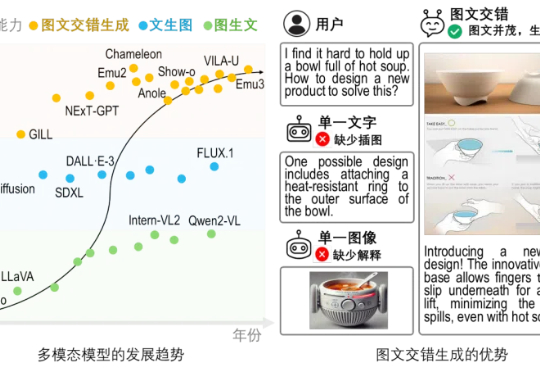

做表情包一度是很多文生图、文生视频应用的场景。Pika在去年就靠魔法猫,在国外出圈了一把。

文本到图像(Text-to-Image, T2I)生成任务近年来取得了飞速进展,其中以扩散模型(如 Stable Diffusion、DiT 等)和自回归(AR)模型为代表的方法取得了显著成果。然而,这些主流的生成模型通常依赖于超大规模的数据集和巨大的参数量,导致计算成本高昂、落地困难,难以高效地应用于实际生产环境。

文生图技术在全球范围掀起的热潮,让无数用户惊叹科技强大的同时,也开始陆续拥抱AI,沉浸于高效、趣味创作之中。特别是在许多社交媒体上,时常能看到人们通过AI创作出的创意内容。

一天前如果我跟你说, 有这样一个模型,原本只能生成文字,现在可以文生图、图生图、连续对话改图、自由修改提示语、每张图生成时间不超过10s

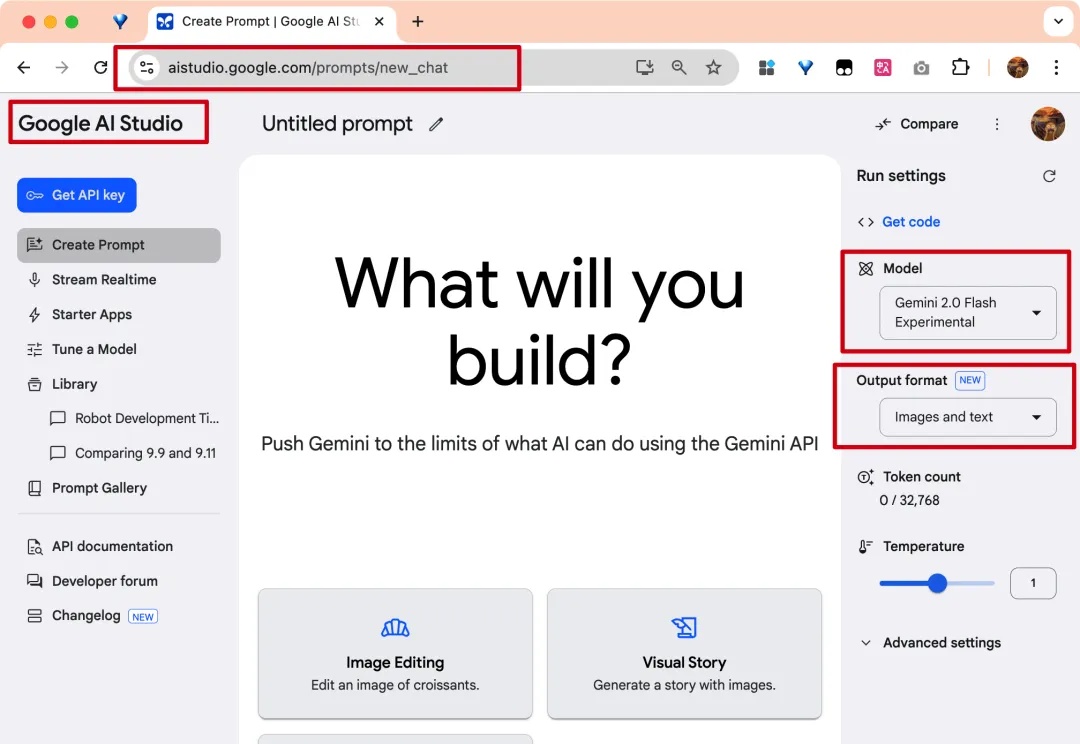

自从在一支烟花群里和朋友测试起 Google 这个新工具,一上午就没停下来 WOC 的感叹。Google 总算放出了他们去年承诺的“可连续对话改图”的 Gemini 文生图能力。

,最近,Appfigure 通过梳理 1000 款 AI 应用(移动端)总结了一份年度 AI 趋势报告,称AI市场在2024年近20亿美元的规模,重点介绍了AI助理、文生图、AI 陪伴、教育AI等版块。

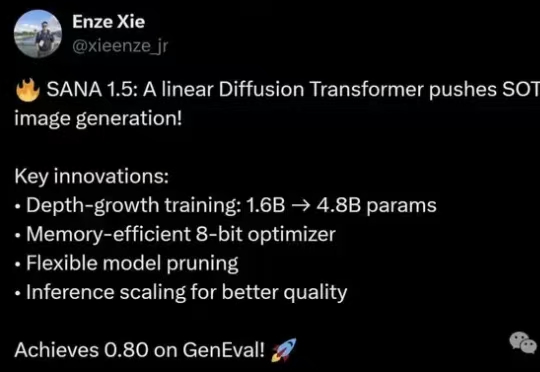

SANA 1.5是一种高效可扩展的线性扩散Transformer,针对文本生成图像任务进行了三项创新:高效的模型增长策略、深度剪枝和推理时扩展策略。这些创新不仅大幅降低了训练和推理成本,还在生成质量上达到了最先进的水平。

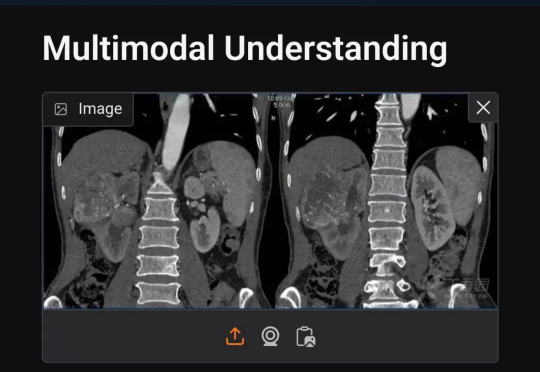

就在除夕前的晚上(2025 年 1 月 27 日),Deepseek 发布了多模态模型 Janus-Pro-7B,该模型在图像生成和多模态理解方面都超过了OpenAI的DALL-E 3(虽然也一般般),我相信能文生图功能一定很优秀了,今天搞点特殊的,测试下图像理解能力对专业的医学影像有没有应用的可行性,以下是常见的五种医学影像测试。