ROCK & ROLL!阿里给智能体造了个实战演练场 | 开源

ROCK & ROLL!阿里给智能体造了个实战演练场 | 开源智能体终于拥有了可以海量复制的“实战演练场”。阿里此次开源的新项目ROCK,解决了无法在真实环境中规模化训练的难题。有了ROCK,开发者想要训练AI执行复杂任务时可以不再“手搓”环境,直接进行标准化的一键部署。

智能体终于拥有了可以海量复制的“实战演练场”。阿里此次开源的新项目ROCK,解决了无法在真实环境中规模化训练的难题。有了ROCK,开发者想要训练AI执行复杂任务时可以不再“手搓”环境,直接进行标准化的一键部署。

科学发现的轨迹,如同交织在人类历史中的璀璨织锦,经历了一系列范式的演进。早期的探索,主要依赖于由直觉、反复试验或机缘巧合驱动的经验发现。随后,以牛顿力学为代表的理论框架,为我们洞察自然现象的基本原理提供了基石。

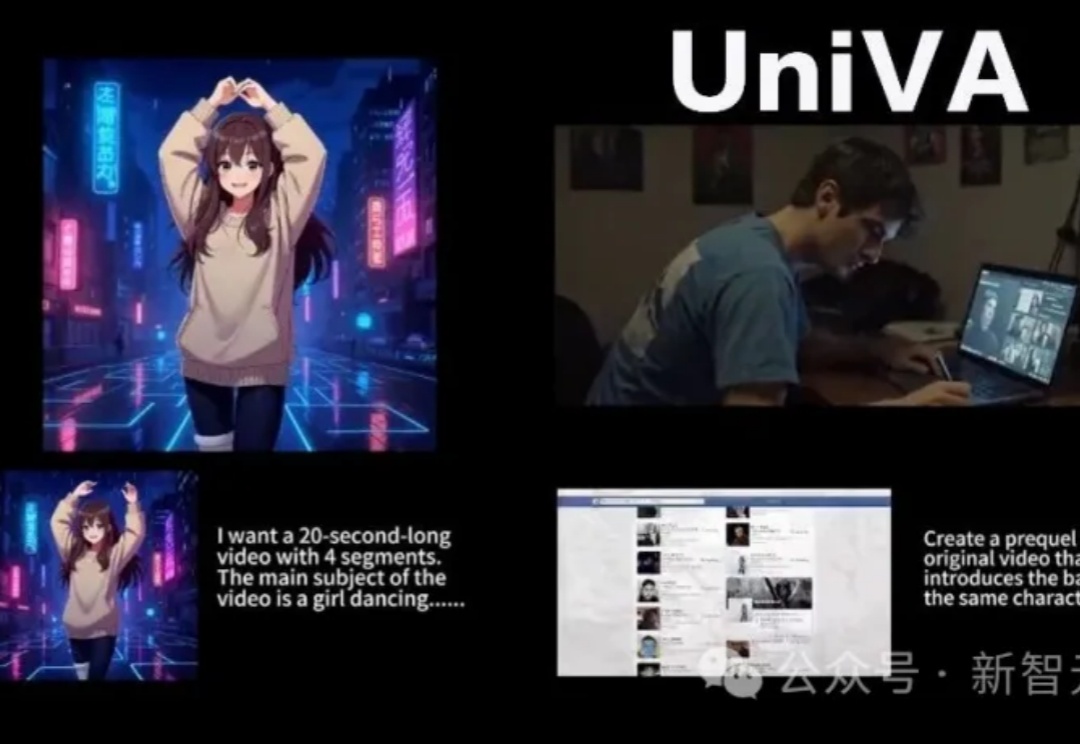

在AI视频创作过程中,创作者常因频繁切换多种工具而疲惫,导致创作热情消磨。近期,多所高校联合开源的UniVA框架,像一位「AI导演」,能整合多种视频工具,提供从脚本到成片的一站式自动化体验,改变传统「抽卡」式创作,支持多轮交互和主动纠错,还能实现风格迁移、前传创作等功能,为视频创作带来高效与便捷。

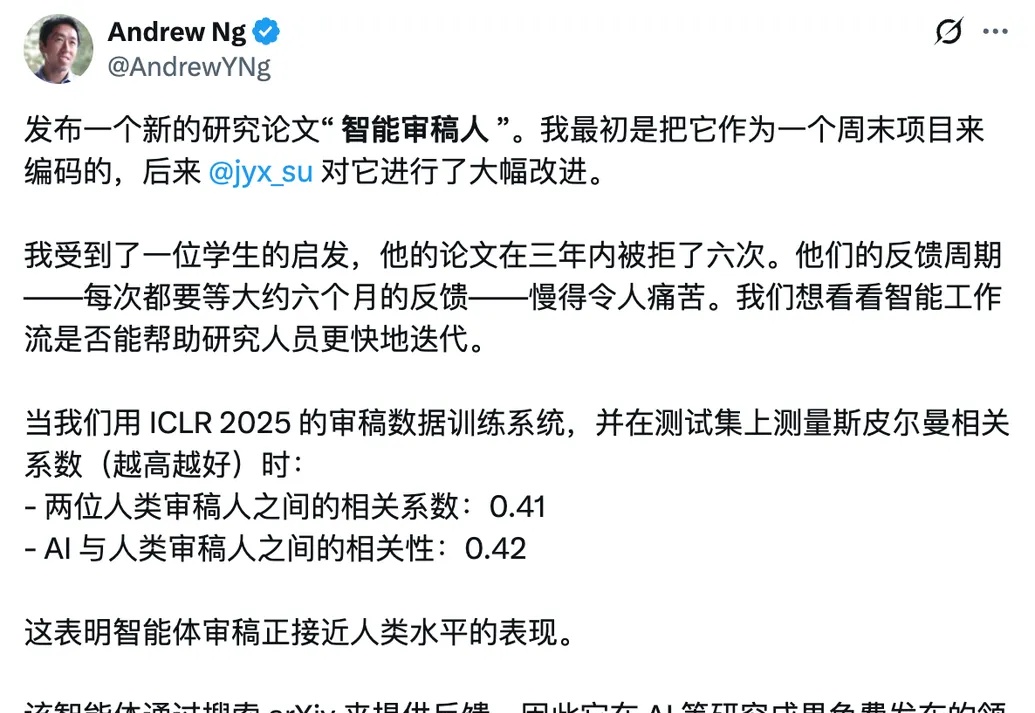

科研人不容易。3年投稿6次全被拒,每次等反馈要半年??机器学习大佬吴恩达听说这位学生的“水逆”遭遇后,亲手搓了个免费的AI论文评审智能体出来。通过在ICLR 2025审稿数据上训练系统,并在测试集中对比发现,该AI审稿系统与人类审稿的相关系数达0.42,和人与人审稿间的0.41相近甚至还高一点。

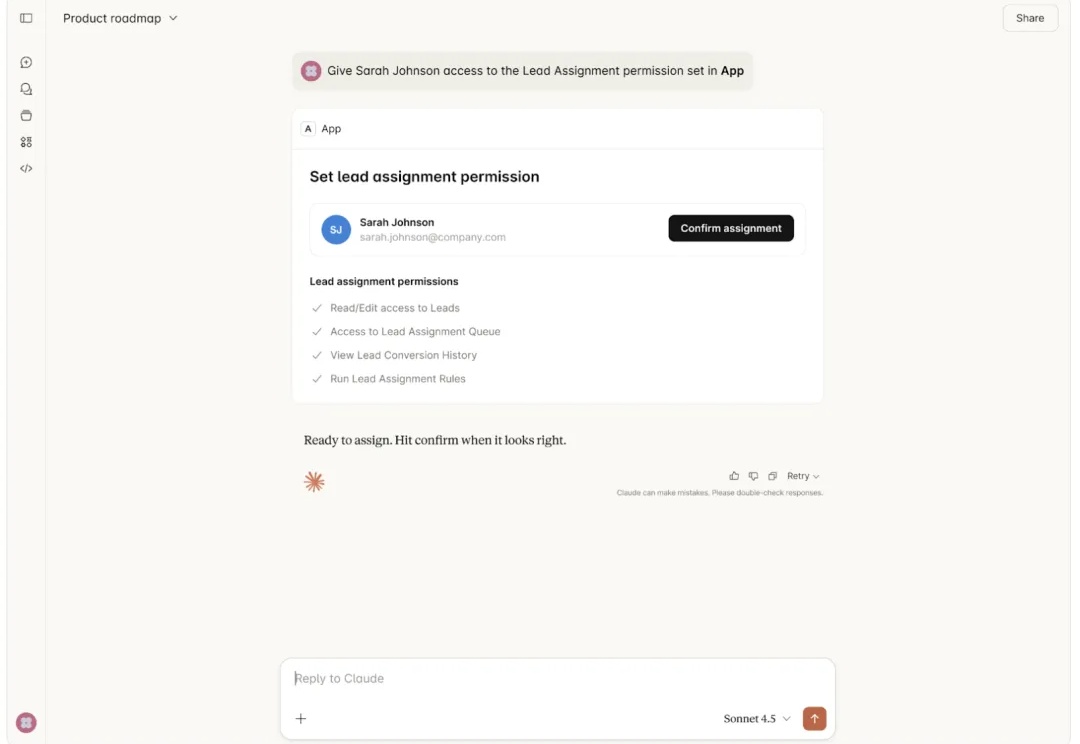

作为连接 AI 模型与广阔数字生态的「神经中枢」,MCP 协议已然成为智能体(AI Agent)不可或缺的基础设施。然而,长期以来,MCP 的交互仅限于文本和结构化数据,这种「盲人摸象」般的体验限制了更复杂应用场景的落地。

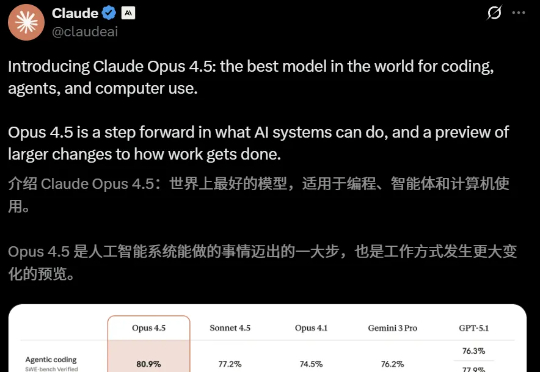

全球编码王座,一夜易主。深夜,Claude Opus 4.5重磅出世,编程实力暴击Gemini 3 Pro、GPT-5.1。才一周的时间,AI圈就完成了一次闭环式迭代。它不仅编程强,而且智能体和计算机使用(computer use)能力也是一流。

Donald King曾在全球顶级会计师事务所普华永道(PwC)为众多500强客户打造AI智能体。作为公司AI黑客松大赛的冠军,King获得的不是奖励和提拔,而是公司裁员的电话。

11 月 21 日,AI 初创公司 Genspark 正式宣布完成 2.75 亿美元 B 轮融资。上线仅五个月,Genspark 年化收入已突破 5000 万美元,跻身行业增长最快的 AI 企业之一。

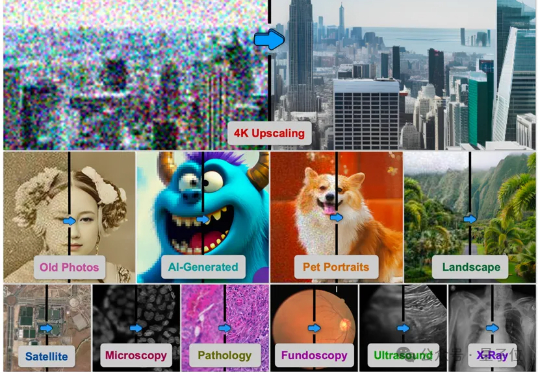

由德克萨斯A&M大学、斯坦福大学、Snap公司、CU Boulder大学、德克萨斯大学奥斯汀分校、加州理工大学、Topaz Labs以及加州大学Merced分校的研究者联合提出的基于AI智能体的方法4KAgent针对不同类型的图像以及需求对图像进行智能修复并放大到4K分辨率,带来优秀的视觉感知效果。该工作已被NeurIPS 2025接收。

您的 AI 伙伴「游戏陪玩」版已上线。