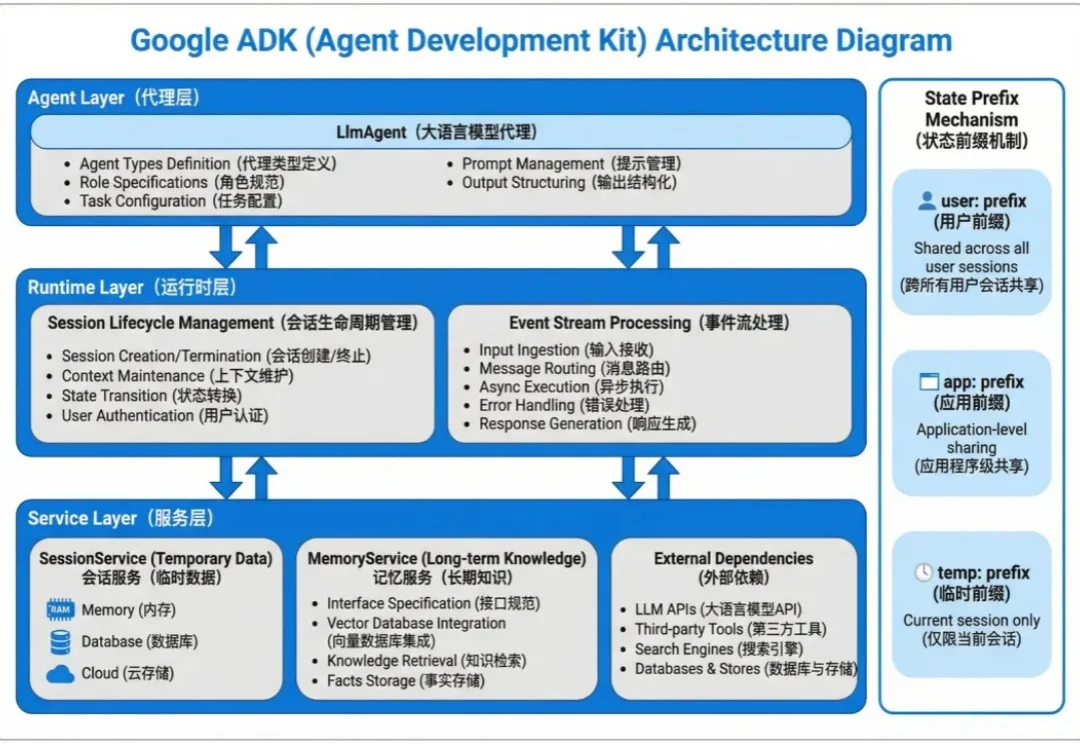

教程|别只盯着 Langchain!Google ADK 搭建 Agent,上下文管理效率翻倍

教程|别只盯着 Langchain!Google ADK 搭建 Agent,上下文管理效率翻倍Agent 的状态数据分两种:会话内的临时上下文和跨会话的长期知识。

Agent 的状态数据分两种:会话内的临时上下文和跨会话的长期知识。

随着全球 AI 智能体竞争升温,Manus 年收入突破 1 亿美元里程碑

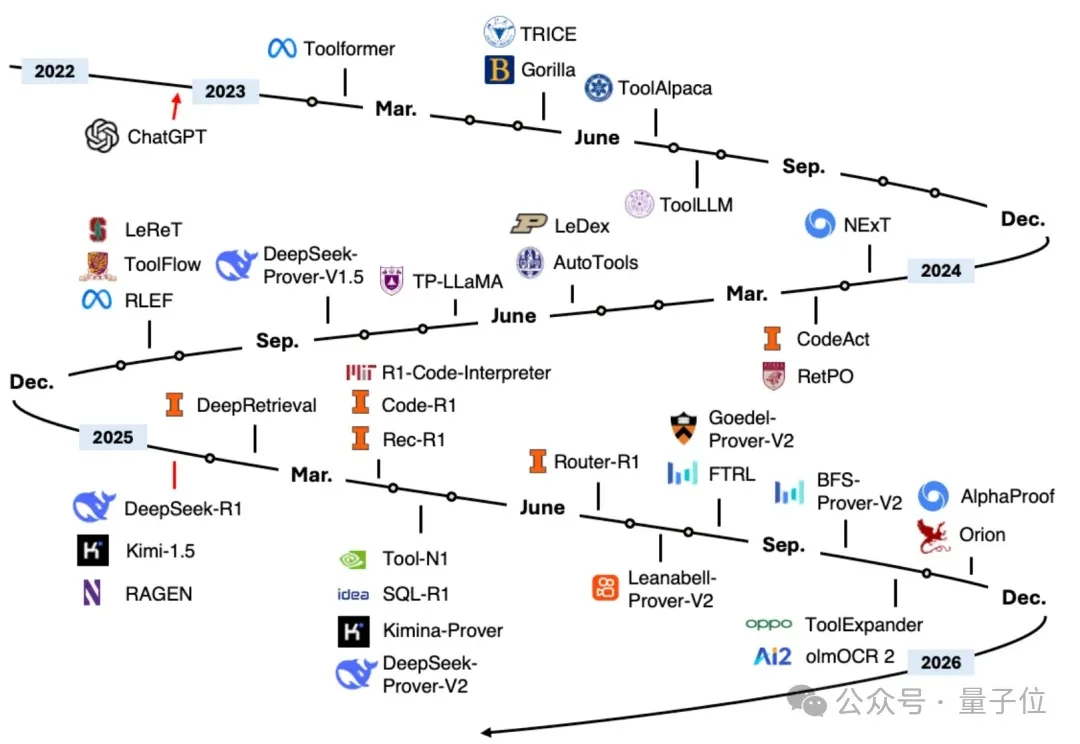

毋庸置疑!2025年title属于「Agent元年」。

在多智能体系统的想象中,我们常常看到这样一幅图景: 多个 AI 智能体分工协作、彼此配合,像一个高效团队一样攻克复杂任务,展现出超越单体智能的 “集体智慧”。

为什么Agent在演示时无所不能,到了实际场景却频频拉胯?

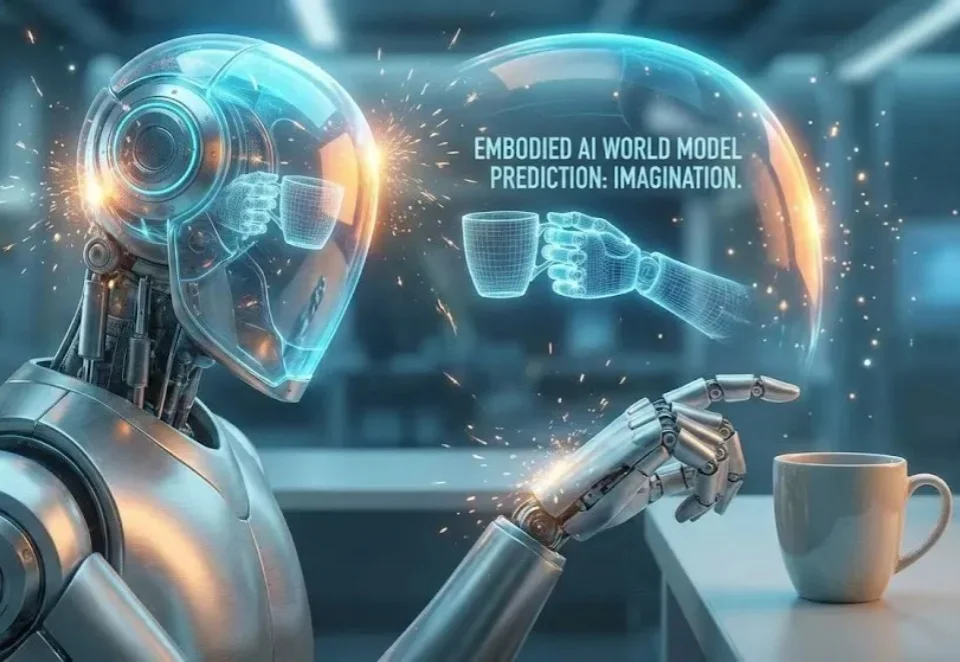

长期以来,具身智能系统主要依赖「感知 - 行动」的反应式回路,缺乏对未来的预测能力。而世界模型的引入,让智能体拥有了「想象」未来的能力。

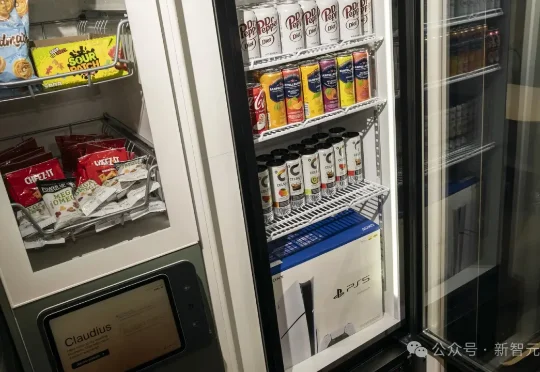

Anthropic让Claude独立经营小卖部,没想到全球顶尖的智能体,在实验中不仅免费送PS5和各种商品,连小卖部的AI「老板」也被一张伪造的PDF文件「骗」下了台。在人类面前,再顶级的大模型仍显得过于「天真」和「单纯」,很容易就被套路和操纵。

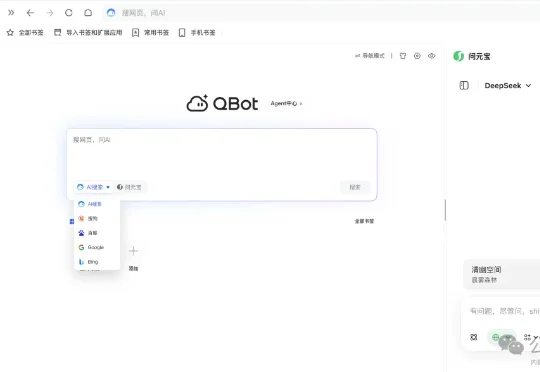

依托腾讯自研大模型的底层能力,QQ浏览器不仅推出了“一句话接管任务”的QBot智能体,还全面实现了AI搜索、AI浏览、AI学习、AI办公等全场景覆盖。就在刚刚,它更是冲上了数据机构XSignal的多项权威榜单,在「AI Agent」赛道上,其相关数据表现已率先跑进行业前排:

谷歌这波像开了「大小号双修」:前脚用Gemini把大模型战场搅翻,后脚甩出两位端侧「师兄弟」:一个走复古硬核架构回归,一个专职教AI「别光会聊,赶紧去干活」。手机里的智能体中枢,要开始卷起来了。

智东西12月19日报道,由三名00后武汉大学校友创办的大模型领域科技创企模态跃迁(MercAllure),已完成两轮累计数千万元融资,投资方包括深圳高新投、力合科创、楚天凤鸣天使基金、武汉基金、奇绩创坛等机构。