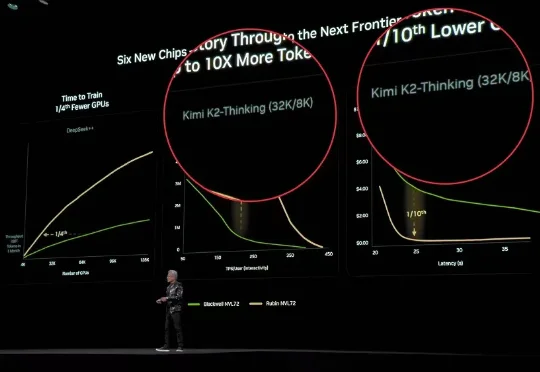

黄仁勋2026大模型座上宾:杨植麟

黄仁勋2026大模型座上宾:杨植麟谁是老黄2026年的新座上宾?

谁是老黄2026年的新座上宾?

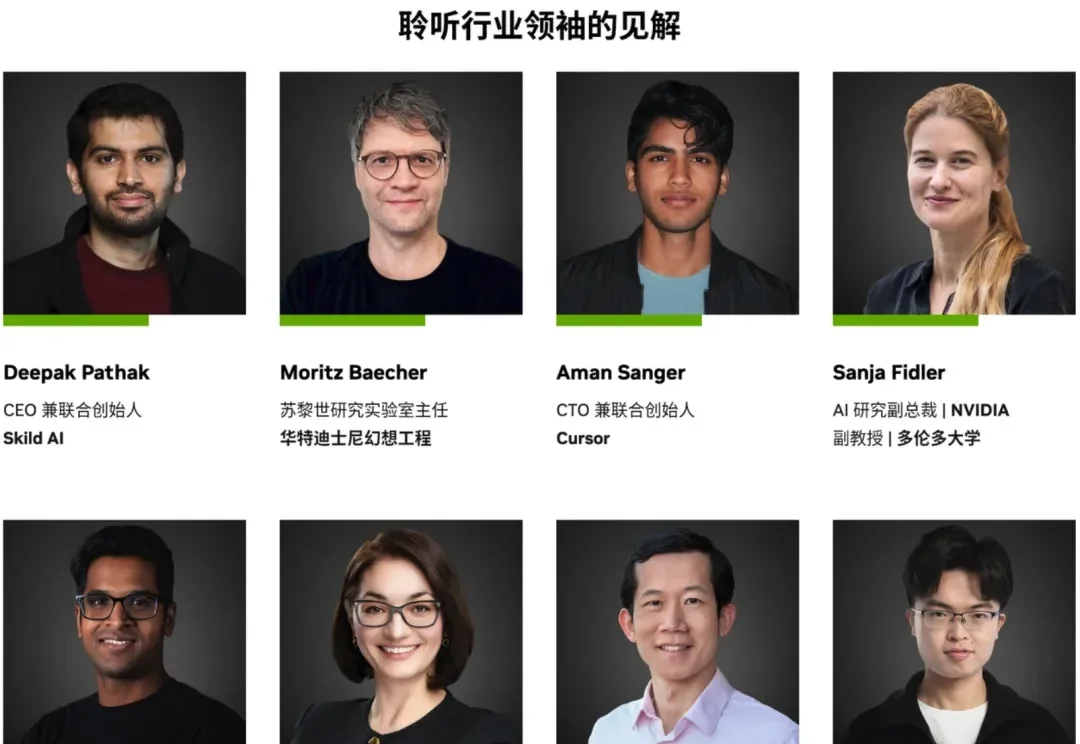

《智能涌现》获悉,近期Kimi在和投资人的沟通中表示,公司的海外收入已超过国内收入,新模型K2.5发布后,全球付费用户已有4倍增长。这一变化恰好发生在新一代模型K2.5发布后的短短几天内。

今天凌晨,月之暗面核心团队在社交媒体平台Reddit上举行了一场有问必答(AMA)活动。三位联合创始人杨植麟(CEO)、周昕宇(算法团队负责人)和吴育昕与全球网友从0点聊到3点,把许多关键问题都给聊透了,比如Kimi K2.5是否蒸馏自Claude、Kimi K3将带来的提升与改变,以及如何在快速迭代与长期基础研究之间取得平衡。

就在刚刚,月之暗面正式发布并开源了 Kimi k2.5。

今年的达沃斯,没有一个论坛不讲AI的。

今天,据外媒CNBC报道,两位知情人士透露,北京大模型独角兽月之暗面正在进行新一轮融资,这轮融资对其估值为48亿美元(约合人民币334.13亿元),而仅在20天前公布的C轮融资中其估值还是43亿美元(约合人民币299.32亿元)。

1月10日,很久没有公开露面的月之暗面创始人杨植麟,在一场定向邀请的行业论坛中,详细地分享了2025年Kimi的技术路线重点,以及对未来的思考。这次分享,有一个核心关键词,Agentic智能时代。这是通用大模型竞争的一个未来高地

融资35亿后,Kimi的新模型紧跟着就要来了?!大模型竞技场上,一个名叫Kiwi-do的神秘模型悄然出现。发现这个新模型的推特网友询问了模型的身份,结果模型自报家门,表示自己来自月之暗面Kimi,训练数据截止到2025年1月。

独家获悉,月之暗面(Kimi)近期完成 5 亿美元 C 轮融资,IDG 领投 1.5 亿美元,阿里、腾讯、王慧文等老股东超额认购,投后估值 43 亿美元。据了解,王慧文已经累计投资月之暗面 7000 万美元。

近日,张予彤意外出现在清华大学的一场交流会上。投资界从接近Kimi人士了解到,张予彤已经出任月之暗面总裁一职,“负责公司的整体战略与商业化,包括融资,也会参与一些新产品的开发。”