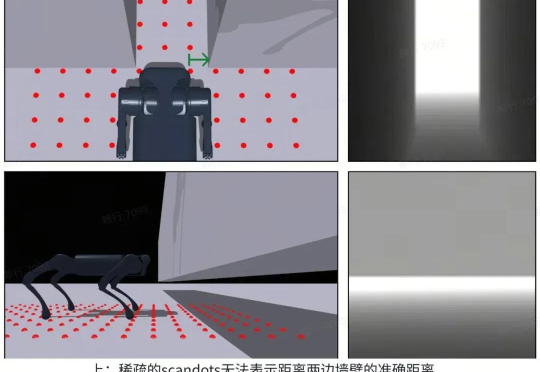

ICLR 2025 Spotlight|让机器人实现「自主进化」,蚂蚁数科、清华提出具身协同框架 BodyGen

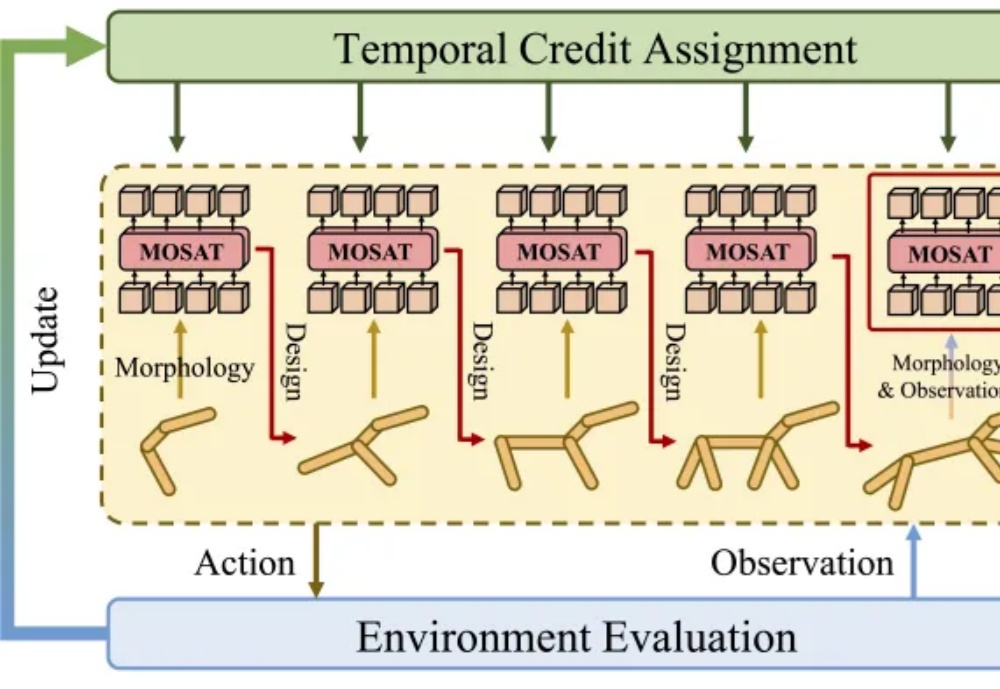

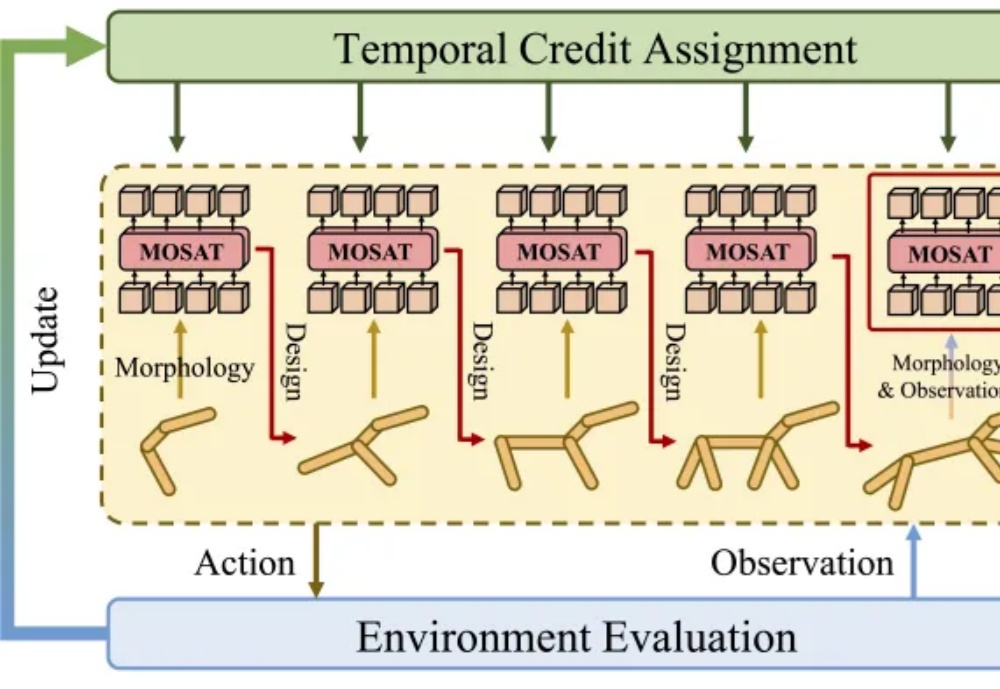

ICLR 2025 Spotlight|让机器人实现「自主进化」,蚂蚁数科、清华提出具身协同框架 BodyGen最近,全球 AI 和机器学习顶会 ICLR 2025 公布了论文录取结果:由蚂蚁数科与清华大学联合团队提出的全新具身协同框架 BodyGen 成功入选 Spotlight(聚光灯/特别关注)论文。

最近,全球 AI 和机器学习顶会 ICLR 2025 公布了论文录取结果:由蚂蚁数科与清华大学联合团队提出的全新具身协同框架 BodyGen 成功入选 Spotlight(聚光灯/特别关注)论文。

当今世界,人们都在谈论生成式人工智能。全世界都知道所有最新的GenAI概念和术语——因此,你会比以往听到更多这样的话:“这个词不等于token”。全世界都开始实施至少一个或两个GenAI用例,当然——我引用它的意思是“改变生活”。

最近, Meta首席AI科学家杨立昆接受海外播客This Is IT 的专访,探讨了深度学习的发展历程、机器学习的三种范式、莫拉维克悖论与AI发展的限制、训练AI模型的资源、AI基础设施投资等话题。

PyTorch机器学习大神Horace He宣布,正是离职加入OpenAI前CTO初创Thinking Machines。这位技术奇才,曾被OpenAI、SSI、谷歌等顶级AI实验室争相邀请,最终选择了刚刚成立的初创。他的选择,不仅是个人职业生涯的转折,更是对AI未来发展方向的一次战略性押注。

谷歌DeepMind 研究科学家 Nicholas Carlini,一位机器学习和计算机安全领域的大牛。以最贴近现实实用的角度,分享了他对大模型的看法,以及自己对大模型应用的50个案例。

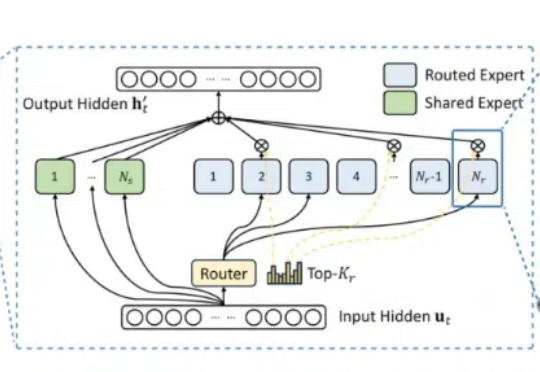

满血版DeepSeek R1部署A100,基于INT8量化,相比BF16实现50%吞吐提升! 美团搜推机器学习团队最新开源,实现对DeepSeek R1模型基本无损的INT8精度量化。

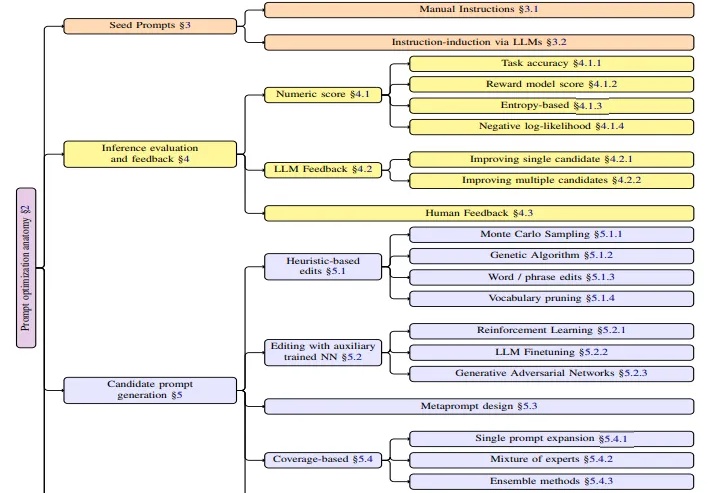

本文是对亚马逊AWS研究团队最新发表的APO(自动提示词优化)技术综述的深度解读。该研究由Kiran Ramnath、Kang Zhou等21位来自AWS的资深研究者共同完成,团队成员来自不同技术背景,涵盖了机器学习、自然语言处理、系统优化等多个专业领域。

世界模型(World Model)作为近年来机器学习和强化学习的研究热点,通过建立智能体对其所处环境的一种内部表征和模拟,能够加强智能体对于世界的理解,进而更好地进行规划和决策。

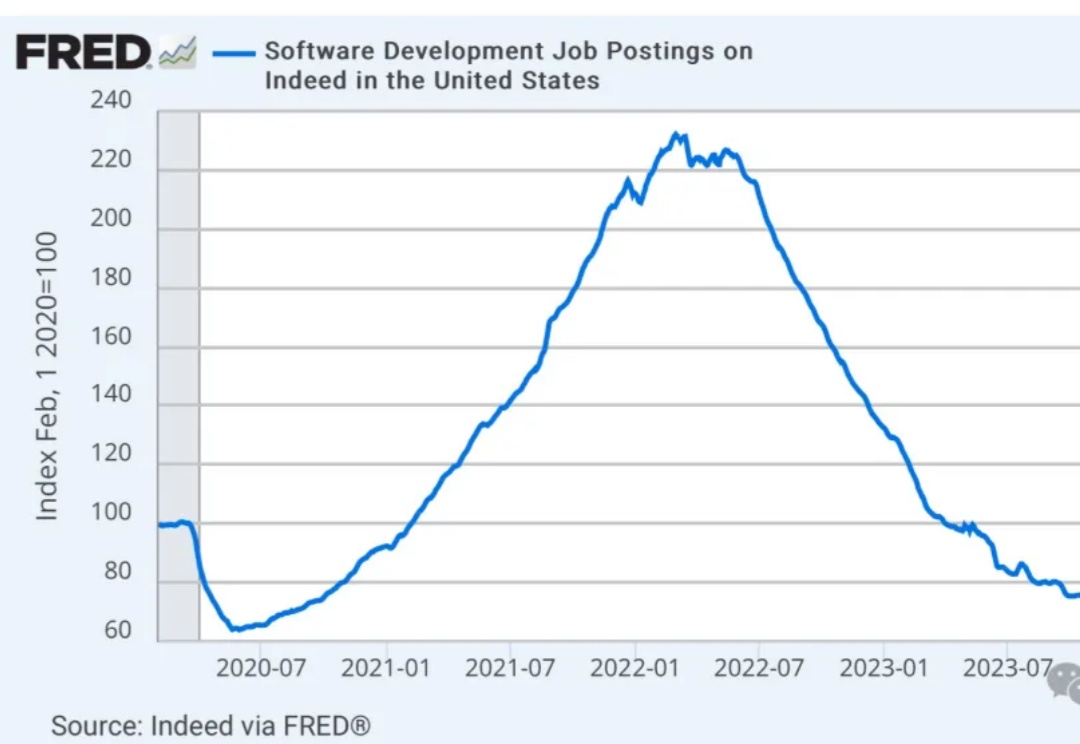

不要再学编程了!最近,一张过去5年软件开发岗位暴降的图全网爆火。AI没有创造更多IT岗位,反而引爆了科技行业大裁员,如今全美IT失业率已经涨至5.7%,至少15万人被裁。连机器学习大牛都开始劝:别学AI,课程全过时了!

近日,资深机器学习研究科学家 Cameron R. Wolfe 更新了一篇超长的博客文章,详细介绍了 LLM scaling 的当前状况,并分享了他对 AI 研究未来的看法。