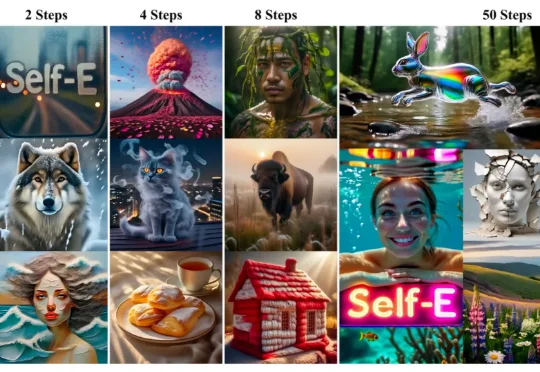

解锁任意步数文生图,港大&Adobe全新Self-E框架学会自我评估

解锁任意步数文生图,港大&Adobe全新Self-E框架学会自我评估香港大学(The University of Hong Kong)与 Adobe Research 联合发布 Self-E(Self-Evaluating Model):一种无需预训练教师蒸馏、从零开始训练的任意步数文生图框架。其目标非常直接:让同一个模型在极少步数也能生成语义清晰、结构稳定的图像,同时在 50 步等常规设置下保持顶级质量,并且随着步数增加呈现单调提升。