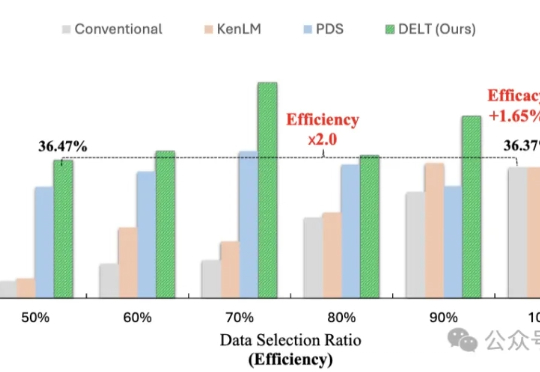

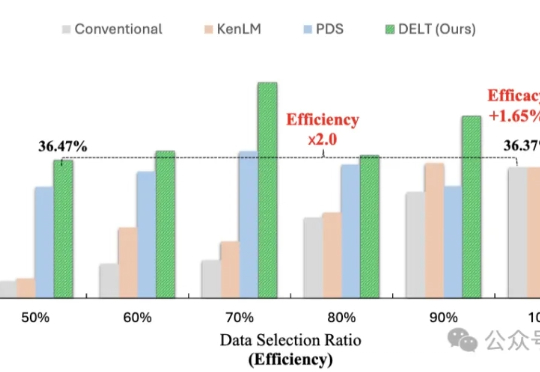

调整训练数据出场顺序,大模型就能变聪明!无需扩大模型/数据规模

调整训练数据出场顺序,大模型就能变聪明!无需扩大模型/数据规模模型训练重点在于数据的数量与质量?其实还有一个关键因素—— 数据的出场顺序。

模型训练重点在于数据的数量与质量?其实还有一个关键因素—— 数据的出场顺序。

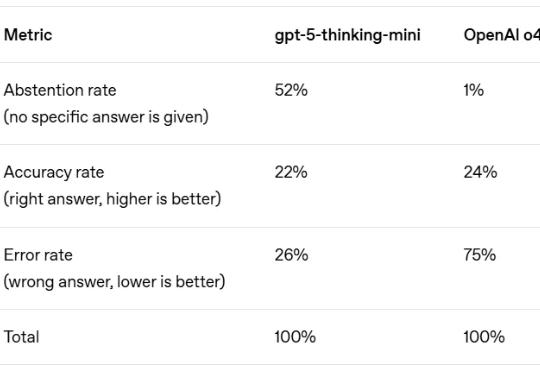

AI 最臭名昭著的 Bug 是什么?不是代码崩溃,而是「幻觉」—— 模型自信地编造事实,让你真假难辨。这个根本性挑战,是阻碍我们完全信任 AI 的关键障碍。

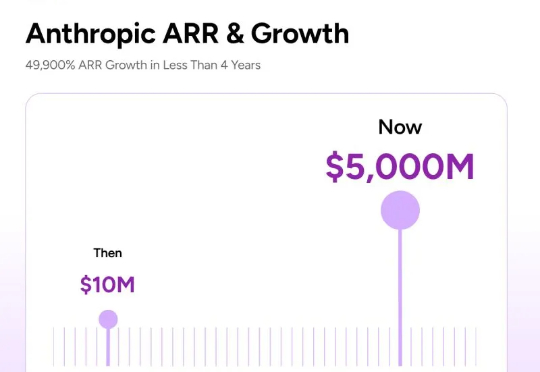

北京时间9月5日晚,美国AI独角兽Anthropic在其官网发布了一则公告。内容简洁而强硬:其旗下的Claude系列模型,将立即停止向多数股权由中国资本持有的公司提供服务。在熟悉华盛顿政治生态的人看来,这一决绝姿态的背后,与Anthropic创始人达里奥·阿莫迪(Dario Amodei)的个人经历不无关系。

以前,每当上线一个新模型,大家总要绞尽脑汁想个响亮又不撞车的名字。 不得不说,有时候名字起得太出彩,甚至能把模型本身给卷下去。别人还没搞懂它能干嘛,名字已经在朋友圈刷屏了。

《金融时报》最新消息,OpenAI 正在和博通合作,自研一颗代号 “XPU” 的 AI 推理芯片,预计会在 2026 年量产,由台积电代工。不同于英伟达 的 GPU,这款芯片不会对外销售,而是专门满足 OpenAI 内部的训练与推理需求,用来支撑即将上线的 GPT-5 等更庞大的模型。

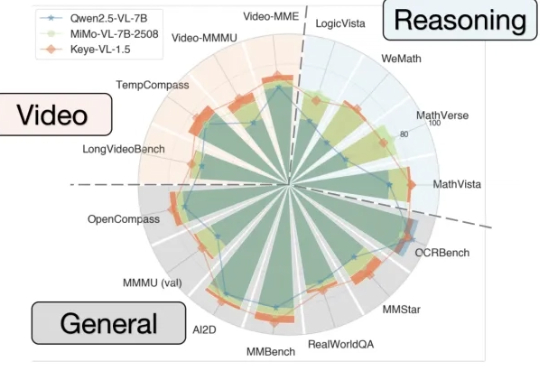

能看懂视频并进行跨模态推理的大模型Keye-VL 1.5,快手开源了。

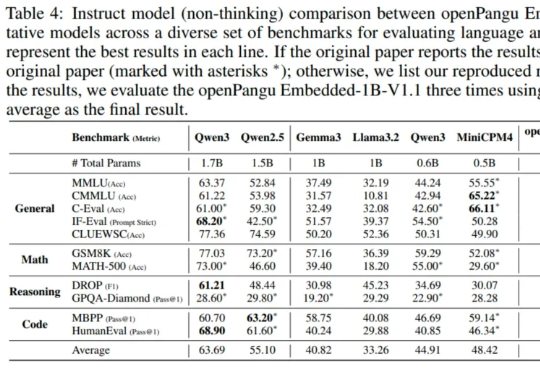

在端侧 AI 这个热门赛道,华为盘古大模型扔下了一颗 “重磅炸弹” 。

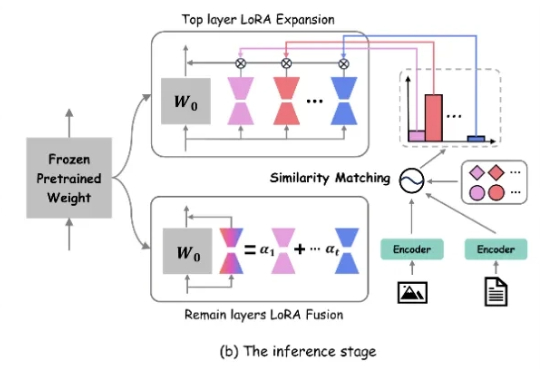

近年来,生成式 AI 和多模态大模型在各领域取得了令人瞩目的进展。然而,在现实世界应用中,动态环境下的数据分布和任务需求不断变化,大模型如何在此背景下实现持续学习成为了重要挑战

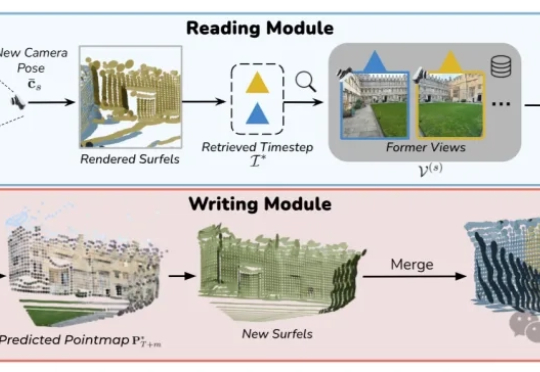

VMem用基于3D几何的记忆索引替代「只看最近几帧」的短窗上下文:检索到的参考视角刚好看过你现在要渲染的表面区域;让模型在小上下文里也能保持长时一致性;实测4.2s/帧,比常规21帧上下文的管线快~12倍。

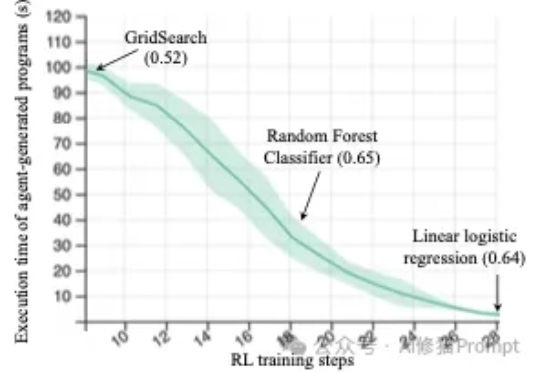

来自斯坦福的研究者们最近发布的一篇论文(https://arxiv.org/abs/2509.01684)直指RL强化学习在机器学习工程(Machine Learning Engineering)领域的两个关键问题,并克服了它们,最终仅通过Qwen2.5-3B便在MLE任务上超越了仅依赖提示(prompting)的、规模更大的静态语言模型Claude3.5。