云计算一哥首度牵手OpenAI,大模型「选择」自由,才是终极胜利

云计算一哥首度牵手OpenAI,大模型「选择」自由,才是终极胜利昨天是个热闹的日子,OpenAI 和 Anthropic 几乎在同一时间发布了自家的新款模型:前者是自 GPT-2 以来重新开源的两款模型 gpt-oss(120b 和 20b),后者是 Claude 系列最强的 Opus 4.1。

昨天是个热闹的日子,OpenAI 和 Anthropic 几乎在同一时间发布了自家的新款模型:前者是自 GPT-2 以来重新开源的两款模型 gpt-oss(120b 和 20b),后者是 Claude 系列最强的 Opus 4.1。

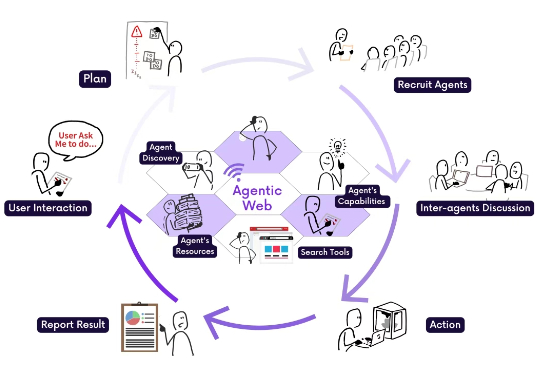

过去三十年,互联网经历了从静态网页到智能推荐的深刻演变。如今,我们正站在互联网的另一个重大转折点上。 这一转折,来自一种全新的范式设想 —— Agentic Web,一个由 AI 智能体组成的、目标导向型的互联网系统。在这个新框架中,用户不再手动浏览网页、点击按钮,而是通过自然语言向智能体发出一个目标,AI 会自主规划、搜索、调用服务、协调其他智能体,最终完成复杂任务。

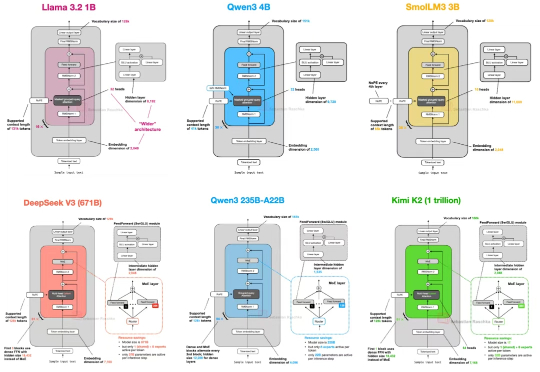

自首次提出 GPT 架构以来,转眼已经过去了七年。 如果从 2019 年的 GPT-2 出发,回顾至 2024–2025 年的 DeepSeek-V3 和 LLaMA 4,不难发现一个有趣的现象:尽管模型能力不断提升,但其整体架构在这七年中保持了高度一致。

心理健康问题影响着全球数亿人的生活,然而患者往往面临着双重负担:不仅要承受疾病本身的痛苦,还要忍受来自社会的偏见和歧视。世界卫生组织数据显示,全球有相当比例的心理健康患者因为恐惧社会歧视而延迟或拒绝治疗。

2023年,当整个AI行业都在为“最强大模型”争得头破血流时,亚马逊云科技却洞察到一个关键事实:AI的价值不在于谁的模型最强大,而在于能否为不同场景选择最适合的模型。

全网疯玩Genie3,惊叹:这才是真正的大世界!距离上一代Genie2,才刚刚过去7个多月,谷歌世界模型就像开了倍速进化

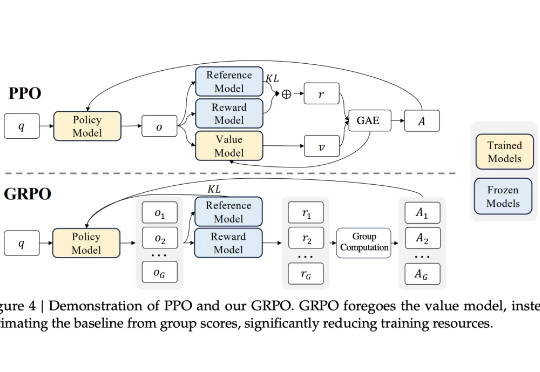

众所周知,大型语言模型的训练通常分为两个阶段。第一阶段是「预训练」,开发者利用大规模文本数据集训练模型,让它学会预测句子中的下一个词。第二阶段是「后训练」,旨在教会模型如何更好地理解和执行人类指令。

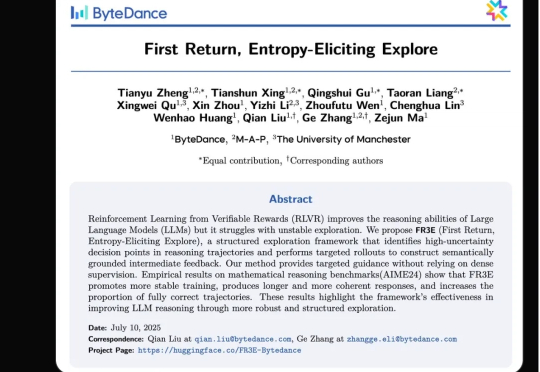

强化学习(RL)范式虽然显著提升了大语言模型(LLM)在复杂任务中的表现,但其在实际应用中仍面临传统RL框架下固有的探索难题。

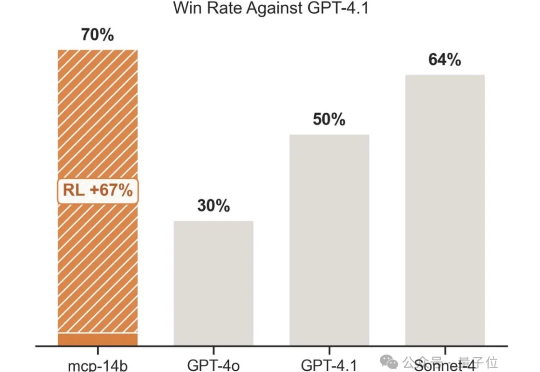

强化学习+任意一张牌,往往就是王炸。专注于LLM+RL的科技公司OpenPipe提出全新开源强化学习框架——MCP·RL。

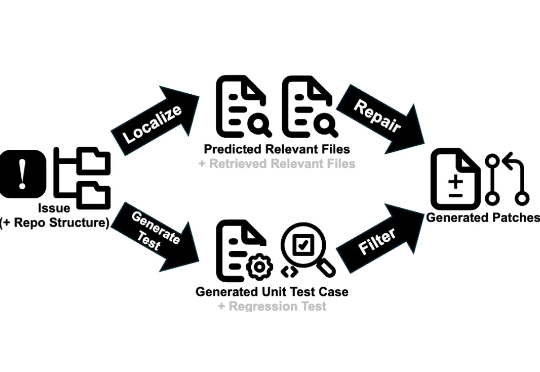

近日,一项由北京大学、字节跳动 Seed 团队及香港大学联合进行的研究,提出了一种名为「SWE-Swiss」的完整「配方」,旨在高效训练用于解决软件工程问题的 AI 模型。研究团队推出的 32B 参数模型 SWE-Swiss-32B,在权威基准 SWE-bench Verified 上取得了 60.2% 的准确率,在同尺寸级别中达到了新的 SOTA。