直击WAIC:大模型低调出展,机器人各出奇招

直击WAIC:大模型低调出展,机器人各出奇招这大概是大家玩得最开心的一届WAIC。在上海世博展览馆里,你能看到:机器狗托着AI眼镜“哒哒哒”走,机器人被绑了绳子“遛”机器狗,人们给自己绑上感应器,小心翼翼“遥操”着机器人搭积木、玩迷宫。

这大概是大家玩得最开心的一届WAIC。在上海世博展览馆里,你能看到:机器狗托着AI眼镜“哒哒哒”走,机器人被绑了绳子“遛”机器狗,人们给自己绑上感应器,小心翼翼“遥操”着机器人搭积木、玩迷宫。

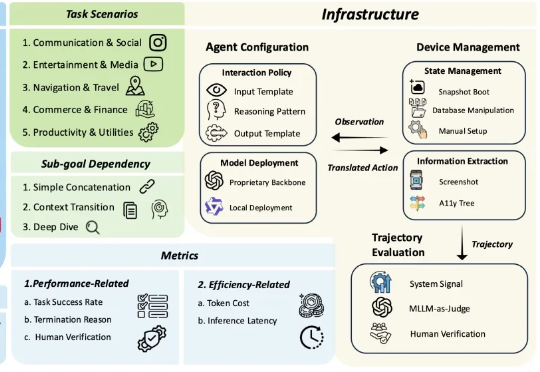

多模态大模型 (MLLM) 驱动的 OS 智能体在单屏动作落实(如 ScreenSpot)、短链操作任务(如 AndroidControl)上展现出突出的表现,标志着端侧任务自动化的初步成熟。

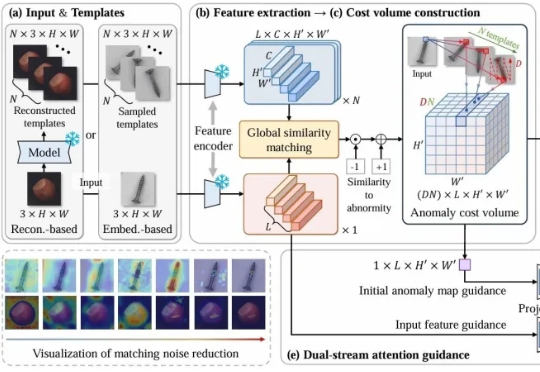

CostFilter-AD通过构建异常代价体并滤波来优化异常检测,能精准识别微小缺陷,无需缺陷样本训练。可作为通用插件提升现有检测系统,帮助工厂提前发现缺陷,提高产品质量。

当前最强大的大语言模型(LLM)虽然代码能力飞速发展,但在解决真实、复杂的机器学习工程(MLE)任务时,仍像是在进行一场“闭卷考试”。它们可以在单次尝试中生成代码,却无法模拟人类工程师那样,在反复的实验、调试、反馈和优化中寻找最优解的真实工作流。

国内 AI 创企 RockAI 提出的非 Transformer 架构 Yan 2.0 Preview。这个架构极大地降低了模型推理时的计算复杂度,因此可以在算力非常有限的设备上离线运行,比如树莓派。

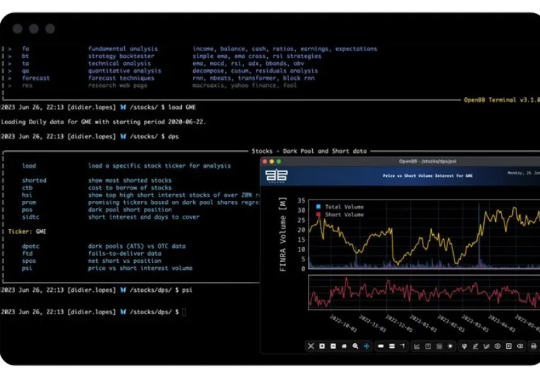

前几天逛 X 的时候,偶然间刷到一个声称“彭博终端”的替代品,不仅免费而且开源。

Surge AI 成立于 2020 年,是一家专注于数据标注的公司。自成立以来,主创团队都极为低调,社交平台上鲜有公开动态。即便如此,Surge AI 仍在短短几年内实现了业绩大爆发,并成为业内公认的“领域最大且最好的玩家”。截至 2024 年,Surge AI 的 ARR 已突破 10 亿美元,超越了行业巨头 Scale AI 的 8.7 亿美元收入,成为其最大的竞争对手。

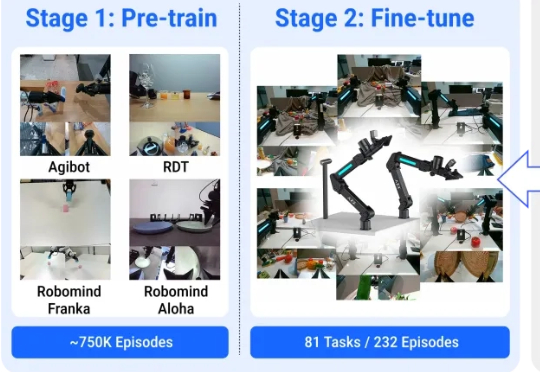

机器人能通过普通视频来学会实际物理操作了! 来看效果,对于所有没见过的物品,它能精准识别并按照指令完成动作。

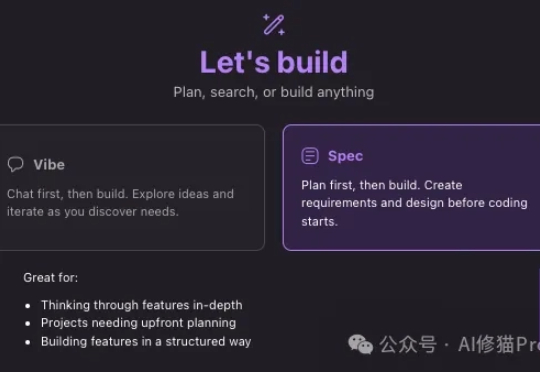

10天前Amazon发布了他们自己的开发平台,Kiro IDE,其中有一个很厉害的交互功能“Spec(Specification)”,强调的是规范的文档,说明书,以一套非常结构化的方法确保开发过程的系统性、可控性和质量,堪称现代软件工程的最佳实践。让vibe coding有一个规范的范式。

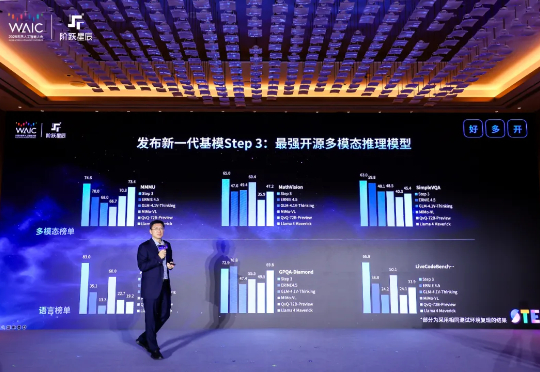

今天下午,阶跃星辰在 WAIC 2025 开幕前夕发布新一代基础大模型 Step 3,并宣布将在 7 月 31 日面向全球企业和开发者开源。MoE 架构,321B 总参,38B 激活