刚刚,阿里发布全球最强开源模型,AI 圈迎来「中国时刻」

刚刚,阿里发布全球最强开源模型,AI 圈迎来「中国时刻」就在刚刚,阿里正式发布全球最强开源推理模型——Qwen3-235B-A22B-Thinking-2507。就在刚刚,阿里正式发布全球最强开源推理模型——Qwen3-235B-A22B-Thinking-2507。

就在刚刚,阿里正式发布全球最强开源推理模型——Qwen3-235B-A22B-Thinking-2507。就在刚刚,阿里正式发布全球最强开源推理模型——Qwen3-235B-A22B-Thinking-2507。

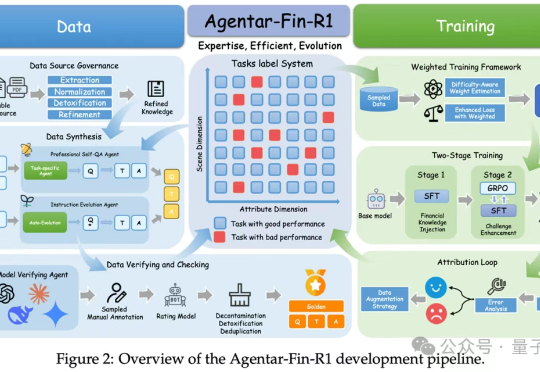

又到了一年一度“中国AI春晚”WAIC,各家大厂动作频发的时候。 今年会有哪些看点?你别说,我们还真在扒论文的过程中,发现了一些热乎线索。 比如蚂蚁数科的金融推理大模型,发布会还没开,技术论文已悄咪咪上线。 金融领域的推理大模型,你可以理解为金融领域的DeepSeek,带着SOTA的刷榜成绩来了。

那是 1964 年,德国南部的小城爱尔兰根,阳光洒落在西门子数据中心的窗格上,一台名为 Zuse Graphomat Z64 的绘图仪静静运转着。 它并不懂何为艺术,却在工业数学家 Georg Nees 的指令下,画出了世界上最早一批由计算机生成的图像。

等了50年,AI教父Hinton终于「真人现身」中国了!这位图灵奖+诺奖教父级大神,不仅亲自踏上魔都土地,还与市委书记同框合影,瞬间刷屏全网!最近他再次预言,AI已进入觉醒倒计时。现在全网都在翘首以待,准备迎接明天他的高能演讲。

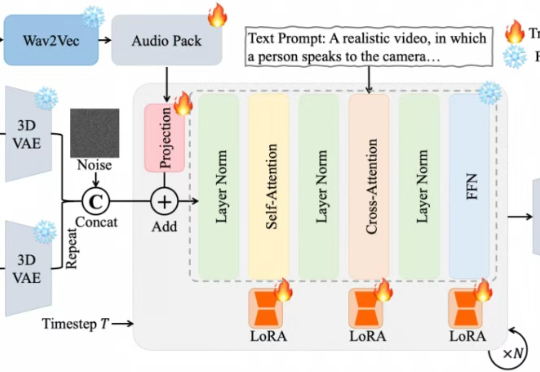

近期,夸克技术团队和浙江大学联合开源了OmniAvatar,这是一个创新的音频驱动全身视频生成模型,只需要输入一张图片和一段音频,OmniAvatar即可生成相应视频,且显著提升了画面中人物的唇形同步细节和全身动作的流畅性。此外,还可通过提示词进一步精准控制人物姿势、情绪、场景等要素。

如何理解大模型推理能力?现在有来自谷歌DeepMind推理负责人Denny Zhou的分享了。 就是那位和清华姚班马腾宇等人证明了只要思维链足够长,Transformer就能解决任何问题的Google Brain推理团队创建者。 Denny Zhou围绕大模型推理过程和方法,在斯坦福大学CS25上讲了一堂“LLM推理”课。

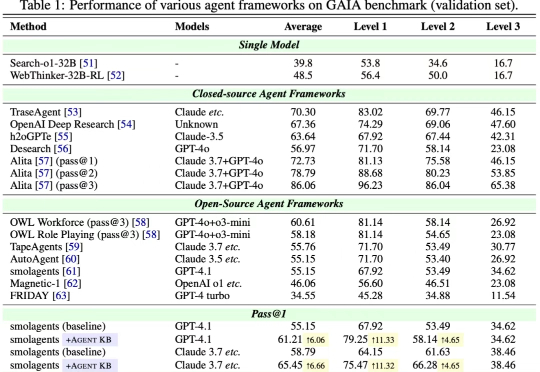

近日,来自 OPPO、耶鲁大学、斯坦福大学、威斯康星大学麦迪逊分校、北卡罗来纳大学教堂山分校等多家机构的研究团队联合发布了 Agent KB 框架。这项工作通过构建一个经验池并且通过两阶段的检索机制实现了 AI Agent 之间的有效经验共享。Agent KB 通过层级化的经验检索,让智能体能够从其他任务的成功经验中学习,显著提升了复杂推理和问题解决能力。

硅谷 AI 投资人 Elad Gil 昨天发布了自己对 AI 领域投资的总结回顾与预测。在他看来,过去四年 AI 经历了从 “技术迷雾”到“商业马拉松” 的变化:随着模型能力的不断提升,过去 12 个月里一系列 AI 应用落地的细分场景在得到验证,头部公司浮现,一定程度上,未来 1-2 年的市场格局初定,AI 应用层正进入收敛周期:

就在昨天,来自UCLA的两位研究者黄溢辰和杨林做了一件让整个AI圈都震惊的事。他们用Google的Gemini 2.5 Pro模型,在2025年国际数学奥林匹克竞赛中拿下了金牌水平的成绩,6道题解对了5道。这可不是什么花架子,IMO被公认为是测试AI推理能力的终极试金石,因为它需要的不仅仅是计算,更需要创造性思维和严密的逻辑推理。

AI引入企业管理并非单纯效率工具,而是引发战略定位、组织流程与数据底层的系统性变革。忽视准备将导致混乱而非增效。实现“AI原生”需平衡效率与风险,重构人机协作规则。企业需清晰战略、完善数据基建,并通过文化建设降低员工抵触,方能将AI潜力转化为核心竞争优势,避免误用为裁员工具。