从大模型到智能体:50+ 头部企业的 AI 进化实践

从大模型到智能体:50+ 头部企业的 AI 进化实践极客邦科技创始人 & CEO 霍太稳从行业研究、内容生产、人才培养到创新创业支持的全方位服务体系展开分享了极客邦科技 AI 应用落地的布局。他首先介绍了极客邦最新发布的两个报告,一个是《中国大模型落地应用研究报告 2025》,大模型发展历经技术酝酿期、合规投入期,现处价值落地期,

极客邦科技创始人 & CEO 霍太稳从行业研究、内容生产、人才培养到创新创业支持的全方位服务体系展开分享了极客邦科技 AI 应用落地的布局。他首先介绍了极客邦最新发布的两个报告,一个是《中国大模型落地应用研究报告 2025》,大模型发展历经技术酝酿期、合规投入期,现处价值落地期,

What?LLM也要看出身!确实,不同的数据集训出的模型“个性”会有大不同,尤其在加之权衡方面。这就像我们经常与自己内心相互竞争的目标和价值观作斗争。

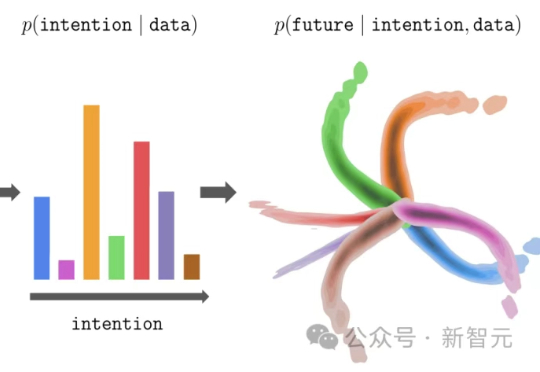

大模型的预训练-微调范式,正在悄然改写强化学习!伯克利团队提出新方法InFOM,不依赖奖励信号,也能在多个任务中实现超强迁移,还能做到「读心术」级别的推理。这到底怎么做到的?

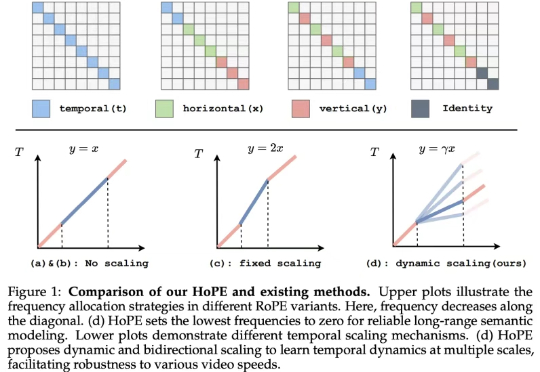

如今的视觉语言模型 (VLM, Vision Language Models) 已经在视觉问答、图像描述等多模态任务上取得了卓越的表现。然而,它们在长视频理解和检索等长上下文任务中仍表现不佳。

刚刚,华为正式宣布开源盘古 70 亿参数的稠密模型、盘古 Pro MoE 720 亿参数的混合专家模型(参见机器之心报道:华为盘古首次露出,昇腾原生72B MoE架构,SuperCLUE千亿内模型并列国内第一 )和基于昇腾的模型推理技术。

该大模型由海洋精准感知技术全国重点实验室(浙江大学)牵头研发,具备基础的海洋专业知识问答,以及声呐图像、海洋观测图等海洋特色多模态数据的自然语言解读能力。其采用的领域知识增强“慢思考”推理机制,相较现有通用大模型能有效降低幻觉式错误。

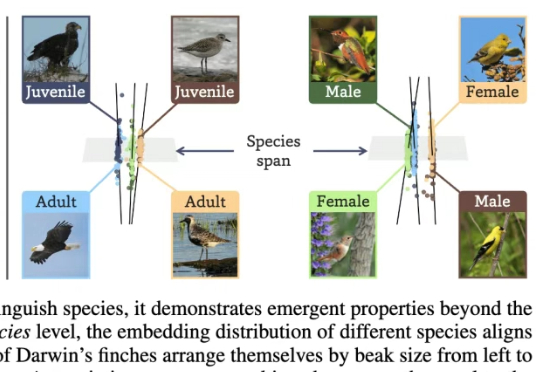

让AI看懂95万物种,并自己悟出生态关系与个体差异!俄亥俄州立大学研究团队在2亿生物图像数据上训练了BioCLIP 2模型。大规模的训练让BioCLIP 2取得了目前最优的物种识别性能。

这两天 Andrej Karpathy 的最新演讲在 AI 社区引发了热烈讨论,他提出了「软件 3.0」的概念,自然语言正在成为新的编程接口,而 AI 模型负责执行具体任务。

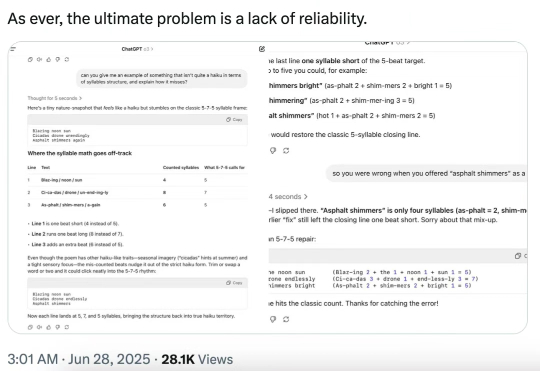

今天,著名的人工智能学者和认知科学家 Gary Marcus 转推了 MIT、芝加哥大学、哈佛大学合著的一篇爆炸性论文,称「对于 LLM 及其所谓能理解和推理的神话来说,情况变得更糟了 —— 而且是糟糕得多。」

近期,他与合作者创建了名为 EVO 2 的生物学基础模型,该模型通过学习生命的基础信息层——DNA,来解释和生成跨所有生命领域的基因序列。