DPO与GRPO谁更胜一筹?港中文、北大等联合发布首个系统性对比研究

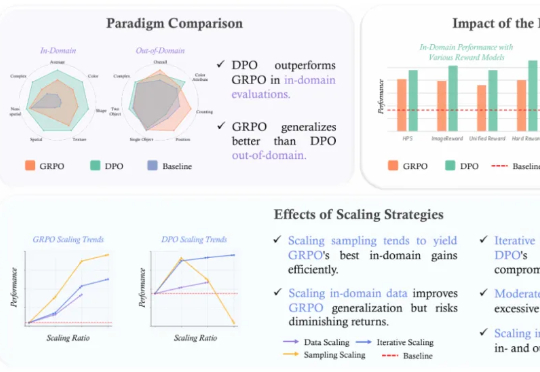

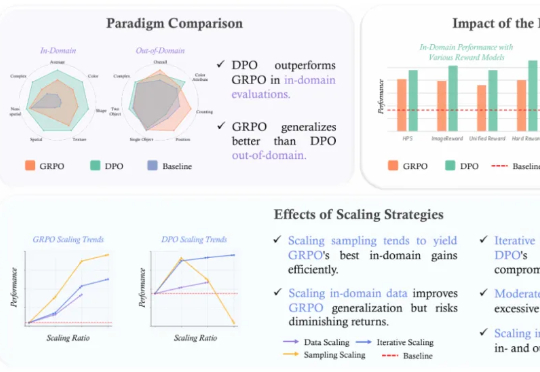

DPO与GRPO谁更胜一筹?港中文、北大等联合发布首个系统性对比研究近年来,强化学习 (RL) 在提升大型语言模型 (LLM) 的链式思考 (CoT) 推理能力方面展现出巨大潜力,其中直接偏好优化 (DPO) 和组相对策略优化 (GRPO) 是两大主流算法。

来自主题: AI技术研报

8794 点击 2025-06-20 10:53

近年来,强化学习 (RL) 在提升大型语言模型 (LLM) 的链式思考 (CoT) 推理能力方面展现出巨大潜力,其中直接偏好优化 (DPO) 和组相对策略优化 (GRPO) 是两大主流算法。

Midjourney sref 分享还没写完,视频模型直接上了,今天啥也别说了,先把体验分享端上来。

从 8.8 万篇文献中提取 1.4 万种材料的化学组成

生成模型会重现识别模型的历史吗?

大语言模型解决不等式证明问题时,可以给出正确答案,但大多数时候是靠猜。推理过程经不起推敲,逻辑完全崩溃。

剑桥大学和范德夏尔实验室在 ICML 2024 上发表的立场论文,直接挑战了当前Agent开发的核心假设:我们一直在用错误的方式让Agent"自我改进"。

2022年末,当ChatGPT的火种刚刚在全球点燃,引发第一波的震撼与惊叹时,张宏波进行了一项实验。他将自己刚刚孕育雏形的编程语言MoonBit的文法(Grammar)——一段描述语言规则的枯燥文本,喂给了那个强大的新模型。

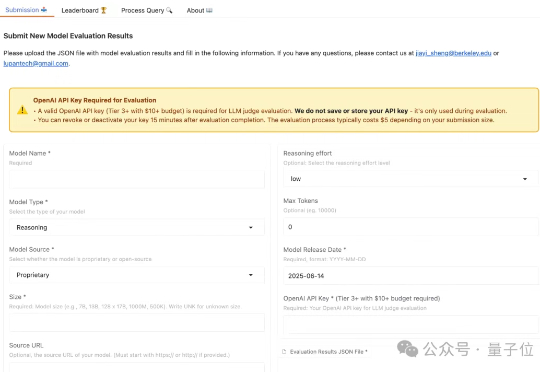

只需要动动嘴就可以驱动GUI代理?

满场观众瞩目之下,体操运动员稳稳完成一个跳步动作,然后……突然来了段木上芭蕾???

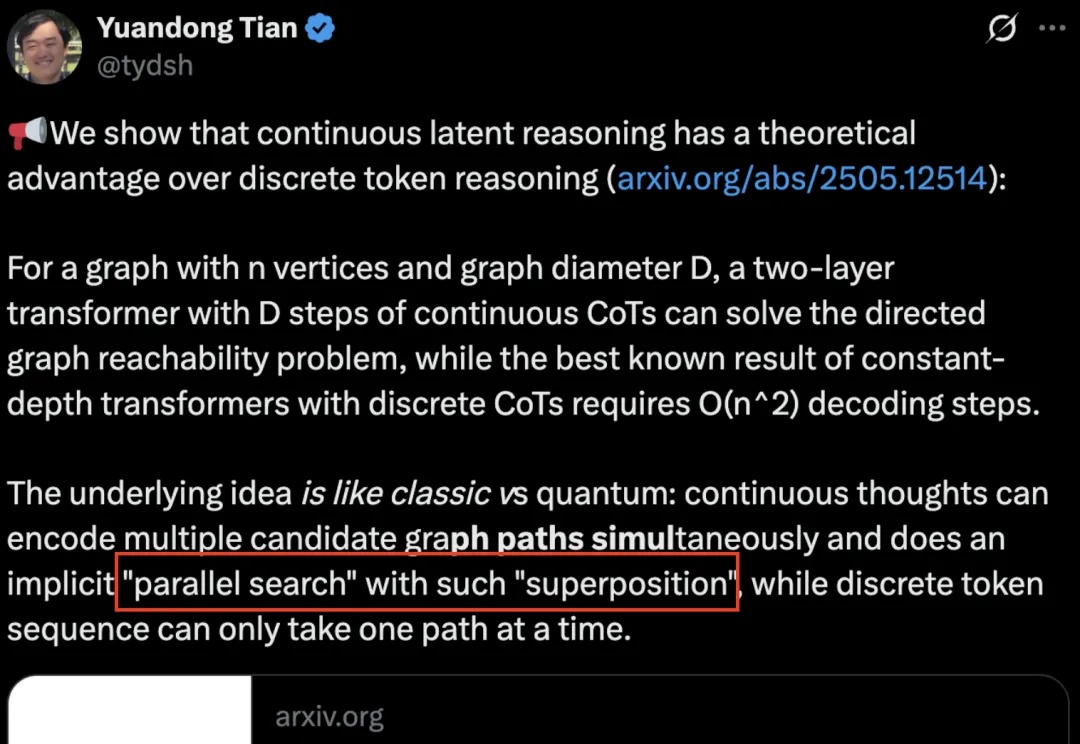

AI也有量子叠加态了?