腾讯 AI Lab副主任俞栋离职,混元团队“新老交替”进行中

腾讯 AI Lab副主任俞栋离职,混元团队“新老交替”进行中组织调整后的模型答卷,将对腾讯至关重要。《智能涌现》从多名独立信源处获悉,近日,出于个人发展原因,原腾讯 AI Lab副主任俞栋将从腾讯离职。截至发稿前,腾讯官方暂未回复。

组织调整后的模型答卷,将对腾讯至关重要。《智能涌现》从多名独立信源处获悉,近日,出于个人发展原因,原腾讯 AI Lab副主任俞栋将从腾讯离职。截至发稿前,腾讯官方暂未回复。

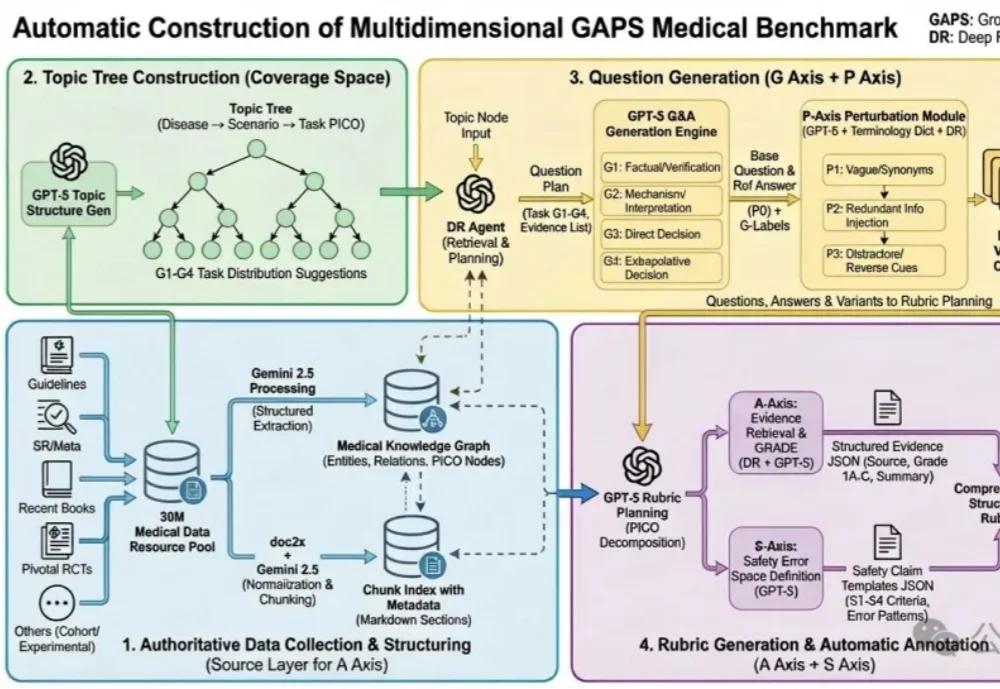

蚂蚁健康与北京大学人民医院王俊院士团队历时6个多月,联合十余位胸外科医生共同打磨,发布了全球首个大模型专病循证能力的评测框架—— GAPS(Grounding, Adequacy, Perturbation, Safety),及其配套评测集 GAPS-NSCLC-preview。

如果一项任务主要涉及文本处理,并且你拥有完善的数据渠道,能够获取完成该任务所需的全部文本信息,那么人工智能完成这项任务的难度就会较低。

清华大学等多所高校联合发布SR-LLM,这是一种融合大语言模型与深度强化学习的符号回归框架。它通过检索增强和语义推理,从数据中生成简洁、可解释的数学模型,显著优于现有方法。在跟车行为建模等任务中,SR-LLM不仅复现经典模型,还发现更优新模型,为机器自主科学发现开辟新路径。

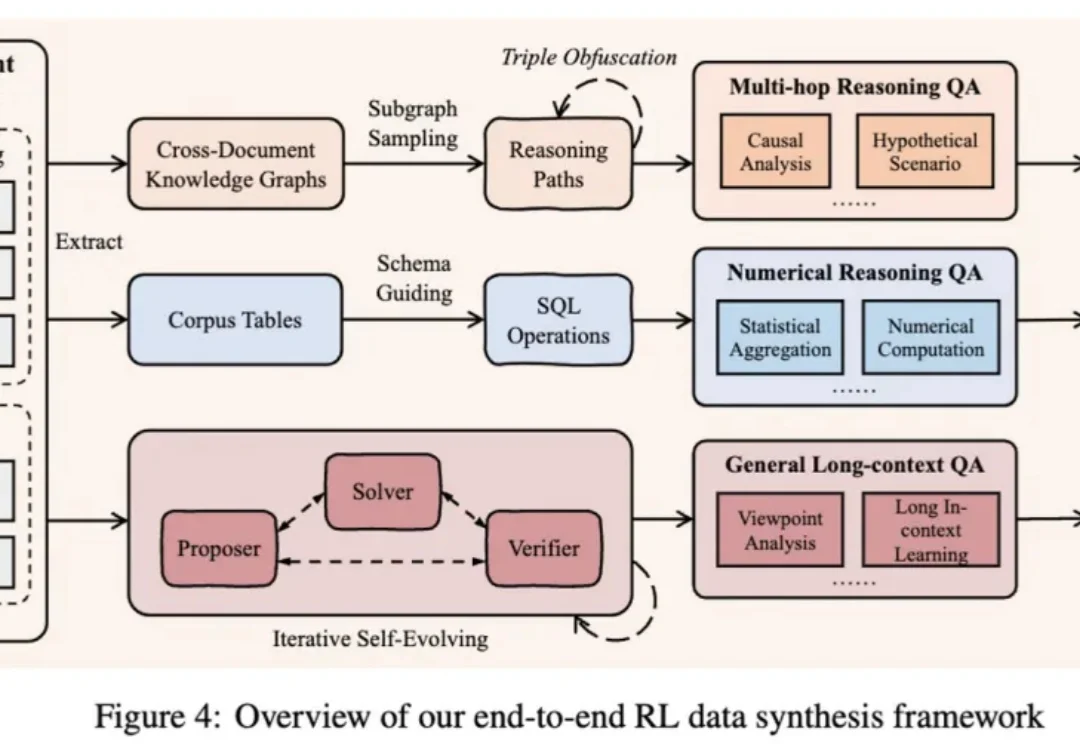

作为大模型从业者或研究员的你,是否也曾为一个模型的 “长文本能力” 而兴奋,却在实际应用中发现它并没有想象中那么智能?

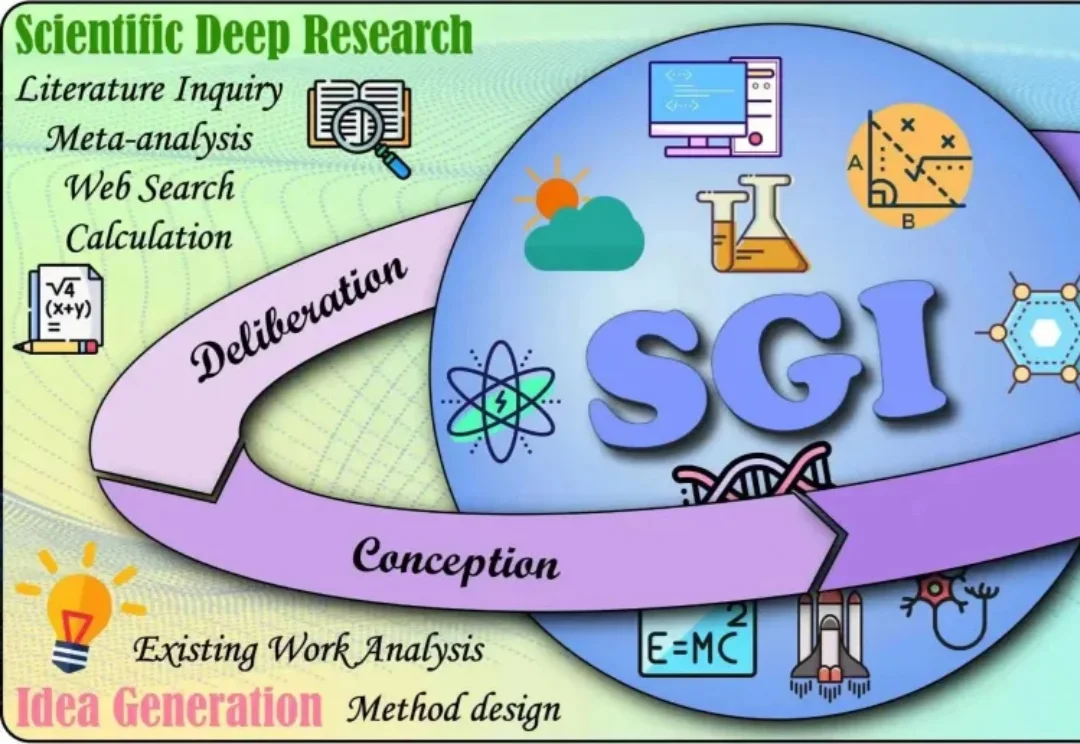

如今,大模型在理解、推理、编程等方面表现突出,但AI的“科学通用能力”(SGI)尚无统一标准。

太香了太香了,妥妥完爆ChatGPT和Nano Banana!

网易云的年度听歌报告出来了,你的 2025 听歌关键词是什么。

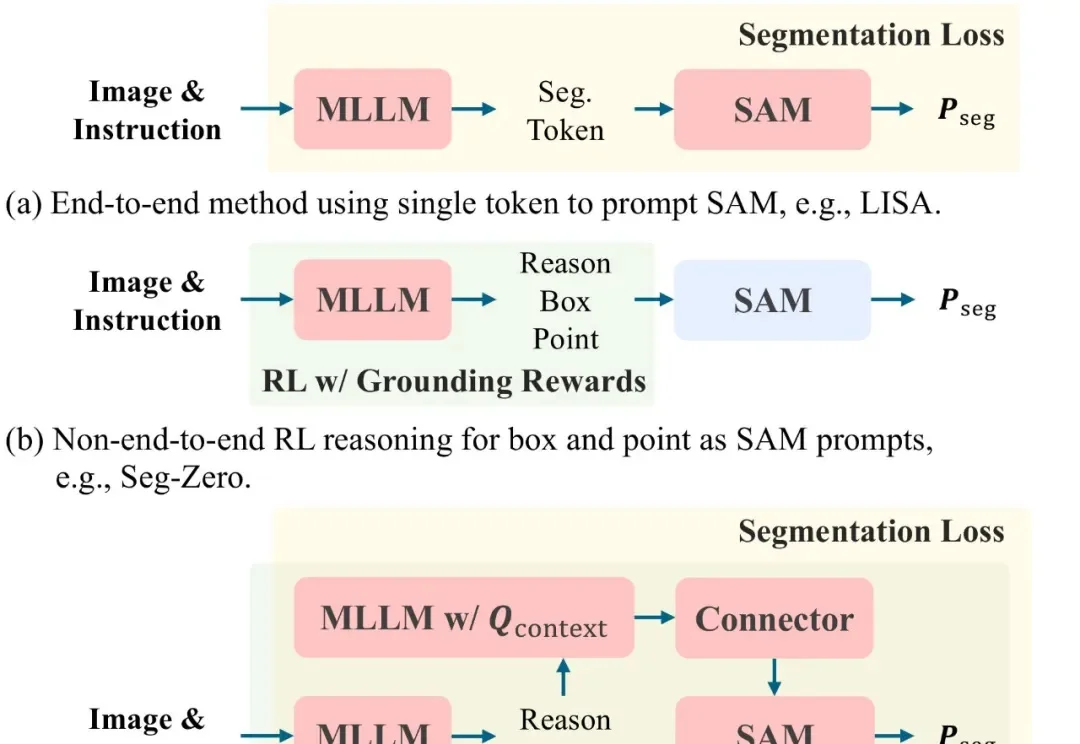

文本提示图像分割(Text-prompted image segmentation)是实现精细化视觉理解的关键技术,在人机交互、具身智能及机器人等前沿领域具有重大的战略意义。这项技术使机器能够根据自然语言指令,在复杂的视觉场景中定位并分割出任意目标。

两个月以来,我一直想写一篇给小白的 CC 入门指南,今天终于可以写了。