手机流畅处理128K长文本,vivo端侧新算法突破内存限制 | ACL 2025

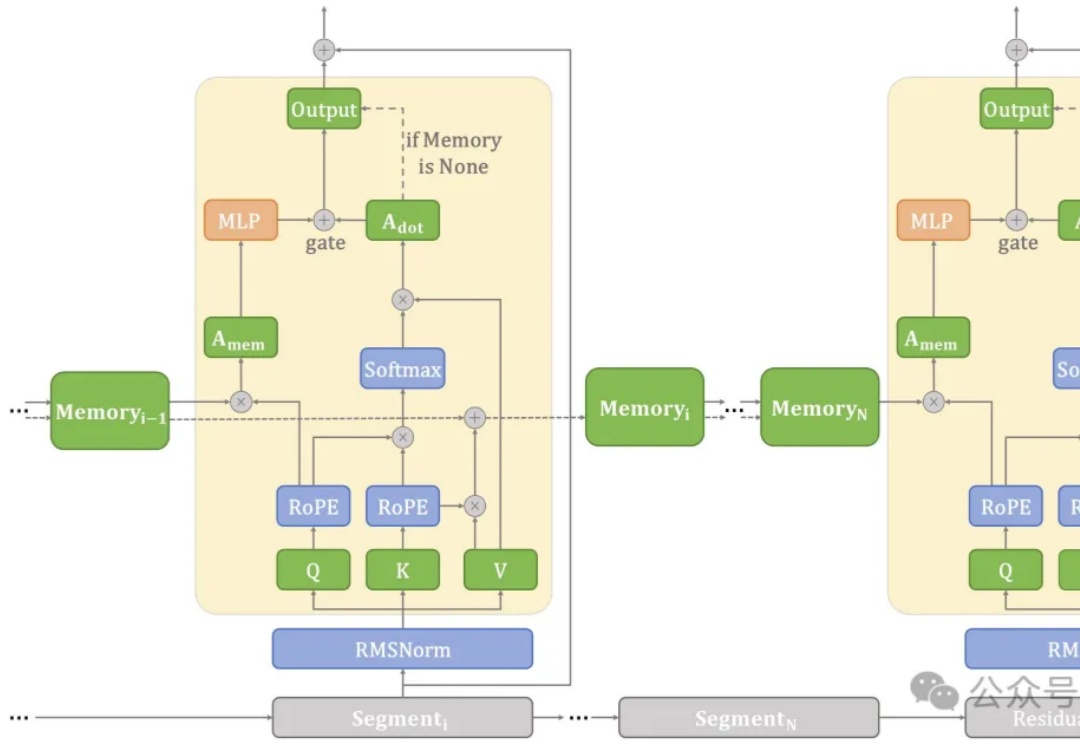

手机流畅处理128K长文本,vivo端侧新算法突破内存限制 | ACL 2025在端侧设备上处理长文本常常面临计算和内存瓶颈。

在端侧设备上处理长文本常常面临计算和内存瓶颈。

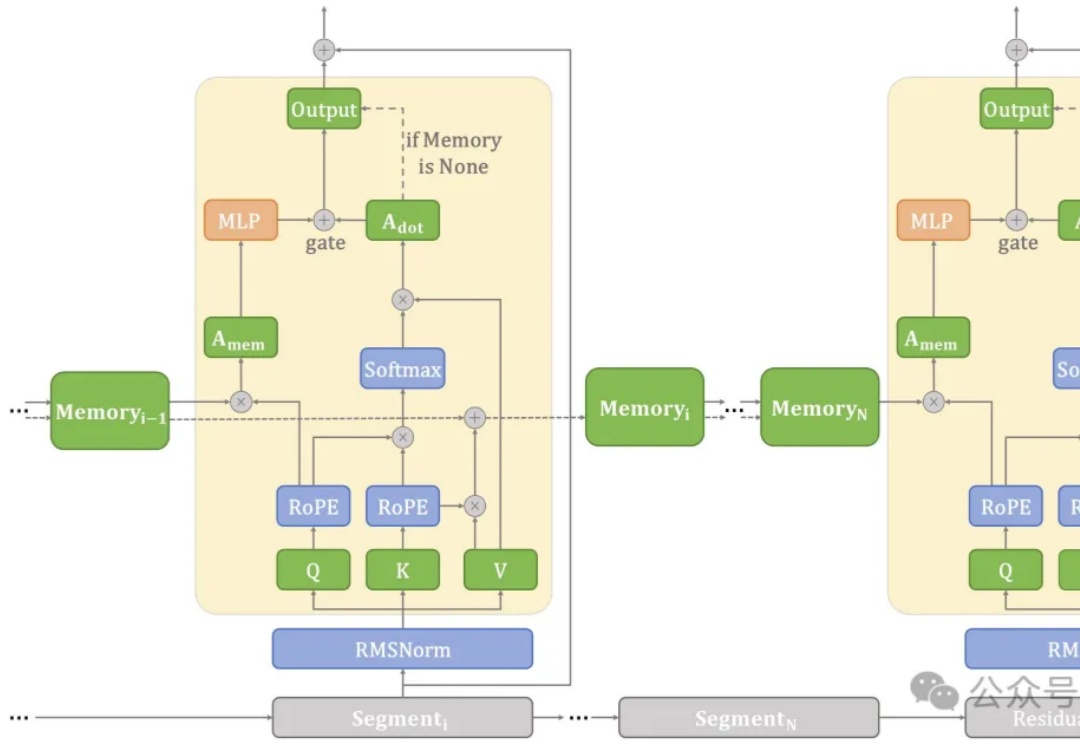

2025 年 5 月,美国加州大学河滨分校 (UC Riverside) 与宾夕法尼亚州立大学 (Penn State University) 联合团队在机器人领域顶级会议 ICRA 2025 上发布最新研究成果 LaMMA-P。

就在刚刚,智源研究员联合多所高校开放三款向量模型,以大优势登顶多项测试基准。其中,BGE-Code-v1直接击穿代码检索天花板,百万行级代码库再也不用怕了!

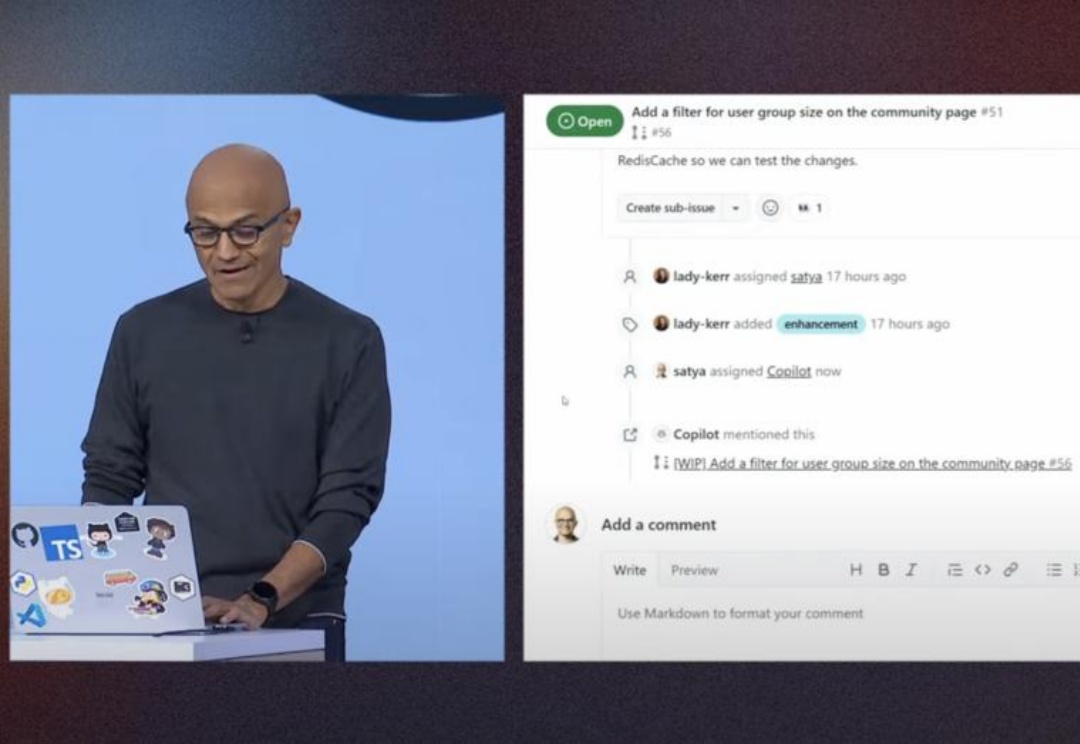

微软Build 2025全面转向AI Agent,整合OpenAI及xAI模型

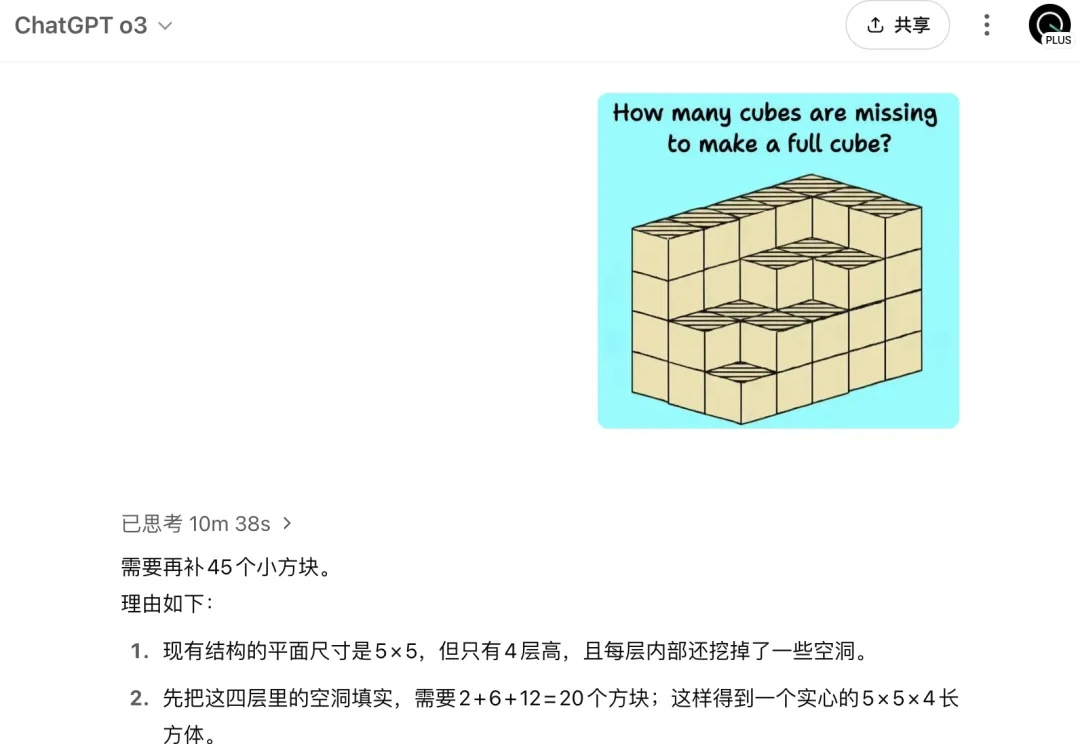

拷打AI的难度还在升级?这不,图像推理又出现了新难题。

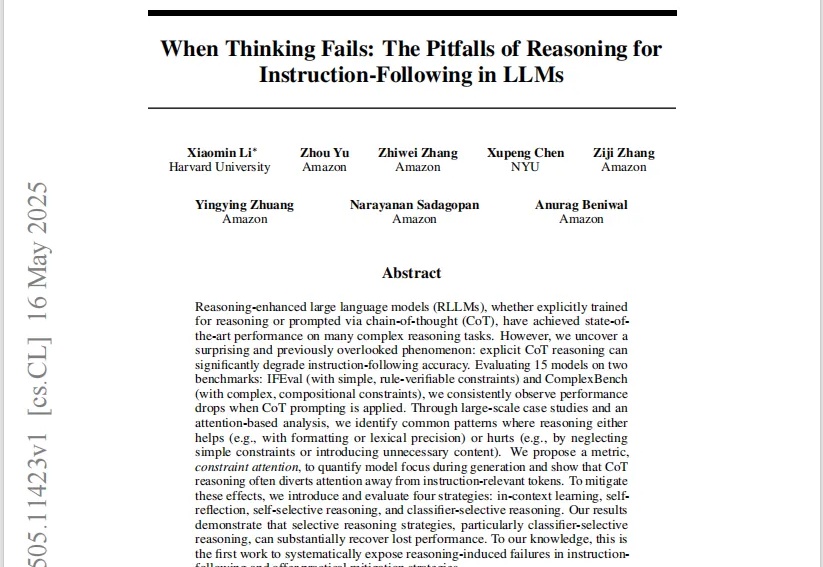

在今年,DeepSeek R1火了之后。

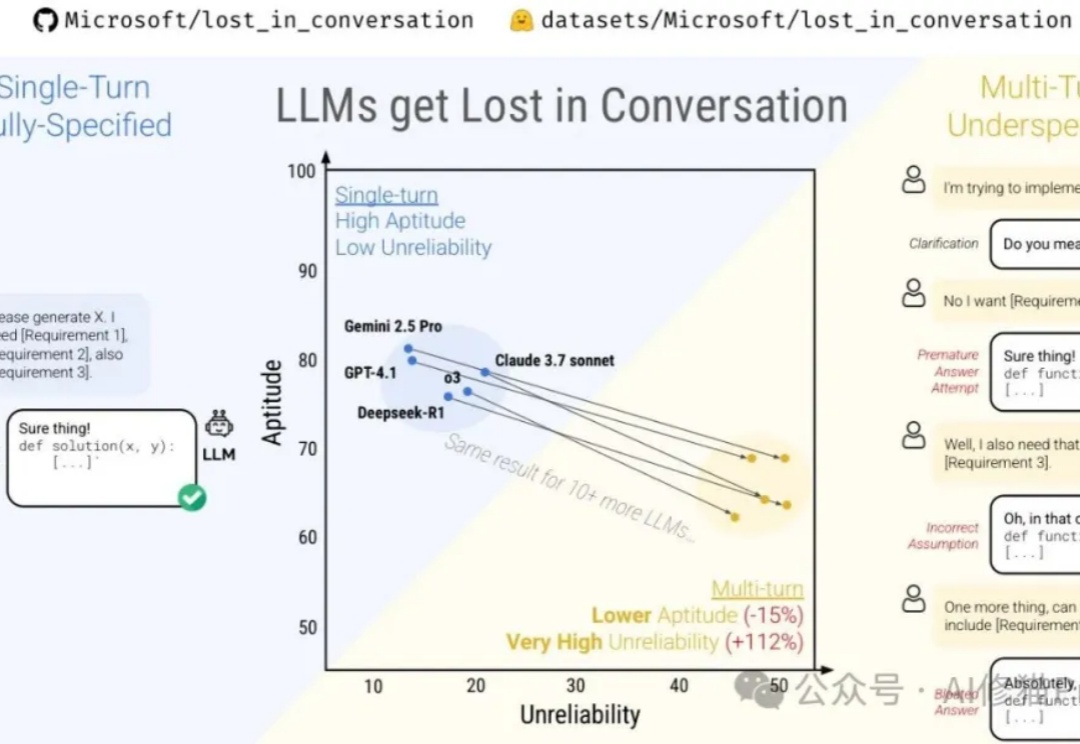

微软最近与Salesforce Research联合发布了一篇名为《Lost in Conversation》的研究,说当前最先进的LLM在多轮对话中表现会大幅下降,平均降幅高达39%。这一现象被称为对话中的"迷失"。文章分析了各大模型(包括Claude 3.7-Sonnet、Deepseek-R1等)在多轮对话中的表现差异,还解析了模型"迷失"的根本原因及有效缓解策略。

MCP 是一种开放的技术协议,旨在标准化大型语言模型(LLM)与外部工具和服务的交互方式。你可以把 MCP 理解成像是一个 AI 世界的通用翻译官,让 AI 模型能够与各种各样的外部工具"对话"。

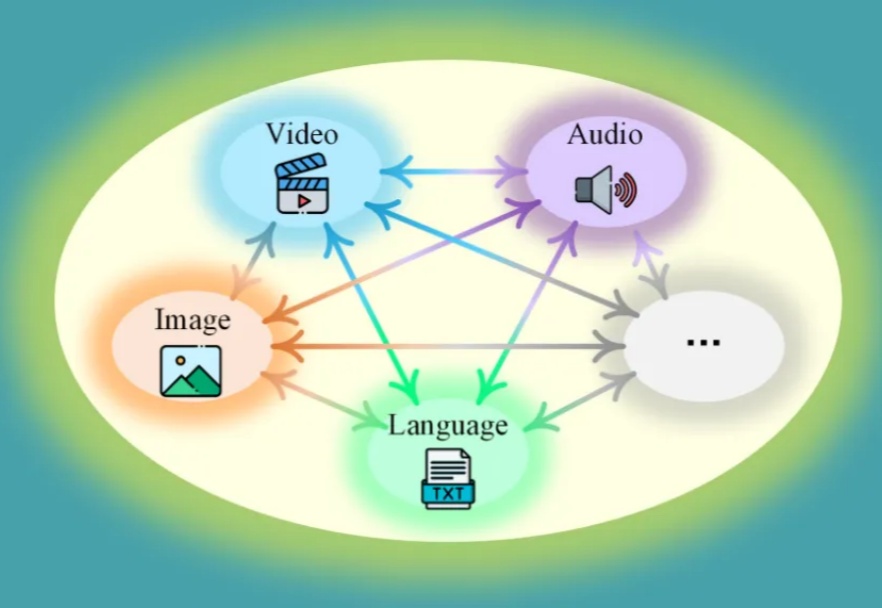

理想中的多模态大模型应该是什么样?十所顶尖高校联合发布General-Level评估框架和General-Bench基准数据集,用五级分类制明确了多模态通才模型的能力标准。当前多模态大语言模型在任务支持、模态覆盖等方面存在不足,且多数通用模型未能超越专家模型,真正的通用人工智能需要实现模态间的协同效应。

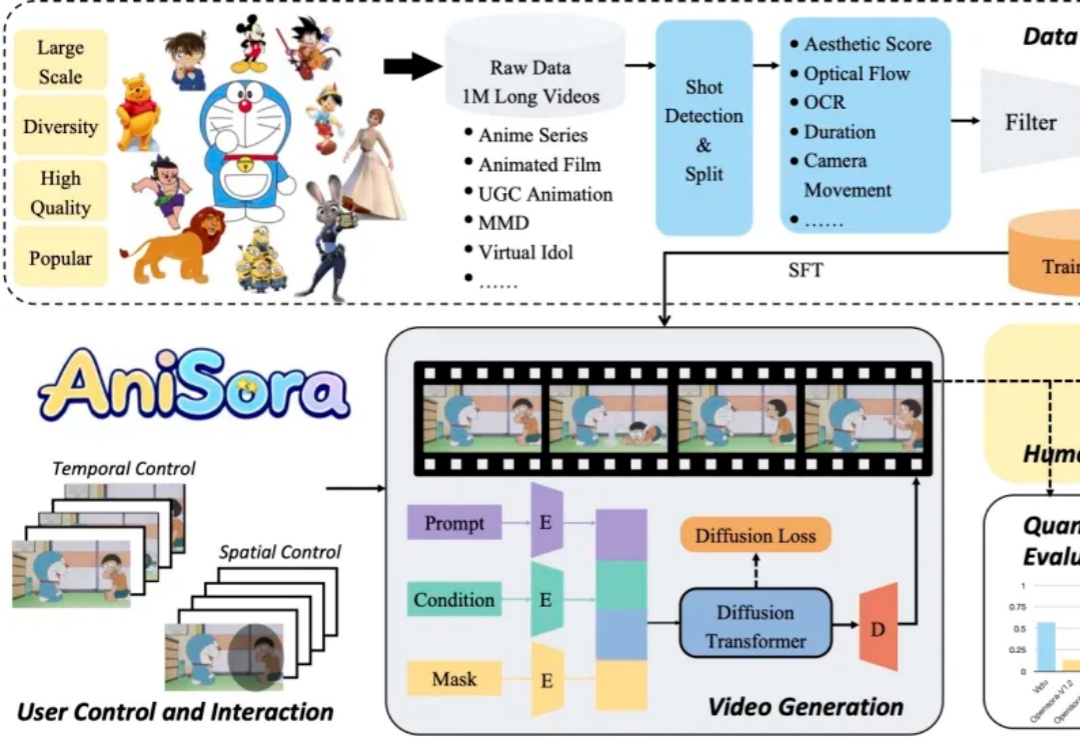

B 站开源动画视频生成模型 Index-AniSora,支持番剧、国创、漫改动画、VTuber、动画 PV、鬼畜动画等多种二次元风格视频镜头一键生成!