Anthropic正式开源了Claude的「灵魂」—— Claude's Constitution

Anthropic正式开源了Claude的「灵魂」—— Claude's Constitution今天,Anthropic 试图向世界展示它的灵魂。Anthropic 正式公布了一份长达 84 页的特殊文档——《Claude 宪法》(Claude's Constitution)。这份文件并非通常意义上的技术白皮书或用户协议,而是一份直接面向 AI 模型本身「撰写」的价值观宣言。

今天,Anthropic 试图向世界展示它的灵魂。Anthropic 正式公布了一份长达 84 页的特殊文档——《Claude 宪法》(Claude's Constitution)。这份文件并非通常意义上的技术白皮书或用户协议,而是一份直接面向 AI 模型本身「撰写」的价值观宣言。

不er,这个世界还有什么是真的?反正我是已经分不清了...

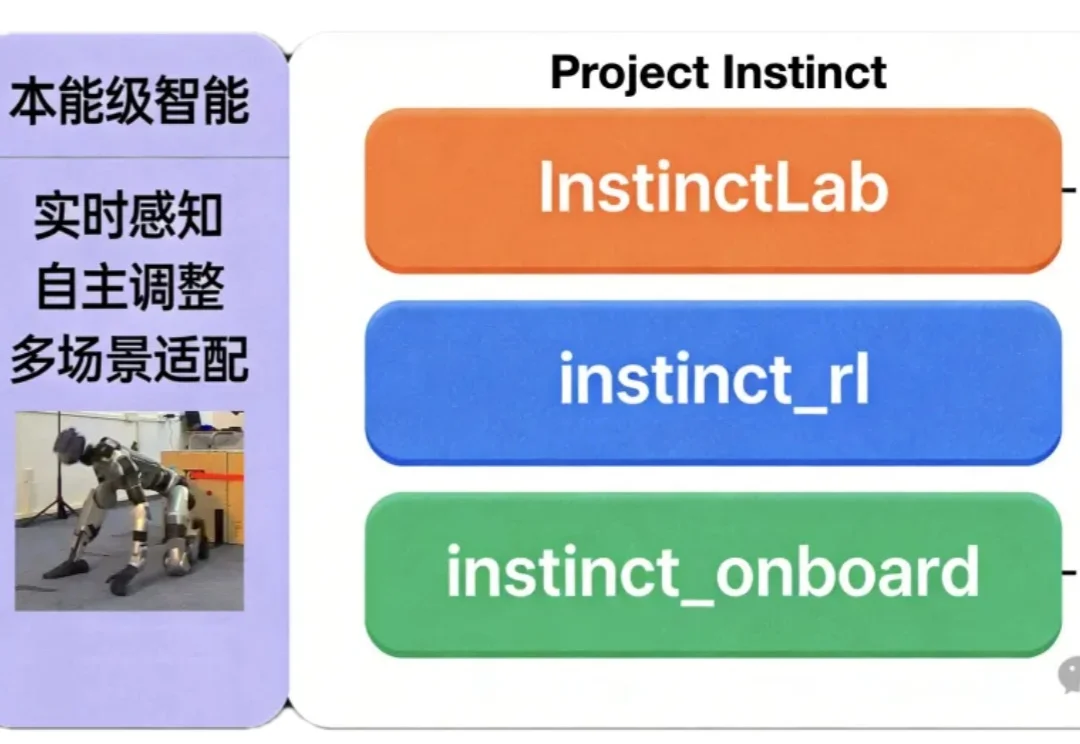

如何让机器人同时具备“本能反应”与复杂运动能力?

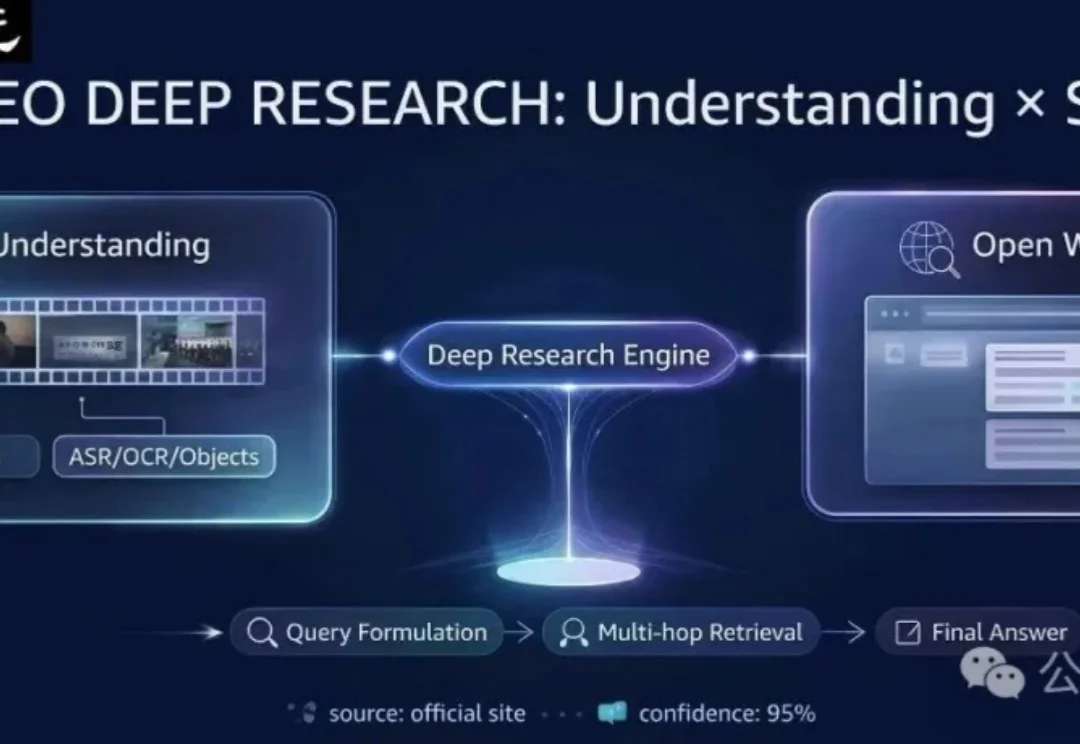

现有的多模态模型往往被困在「视频」的孤岛里——它们只能回答视频内的问题。但在真实世界中,人类解决问题往往是「看视频找线索 -> 上网搜证 -> 综合推理」。

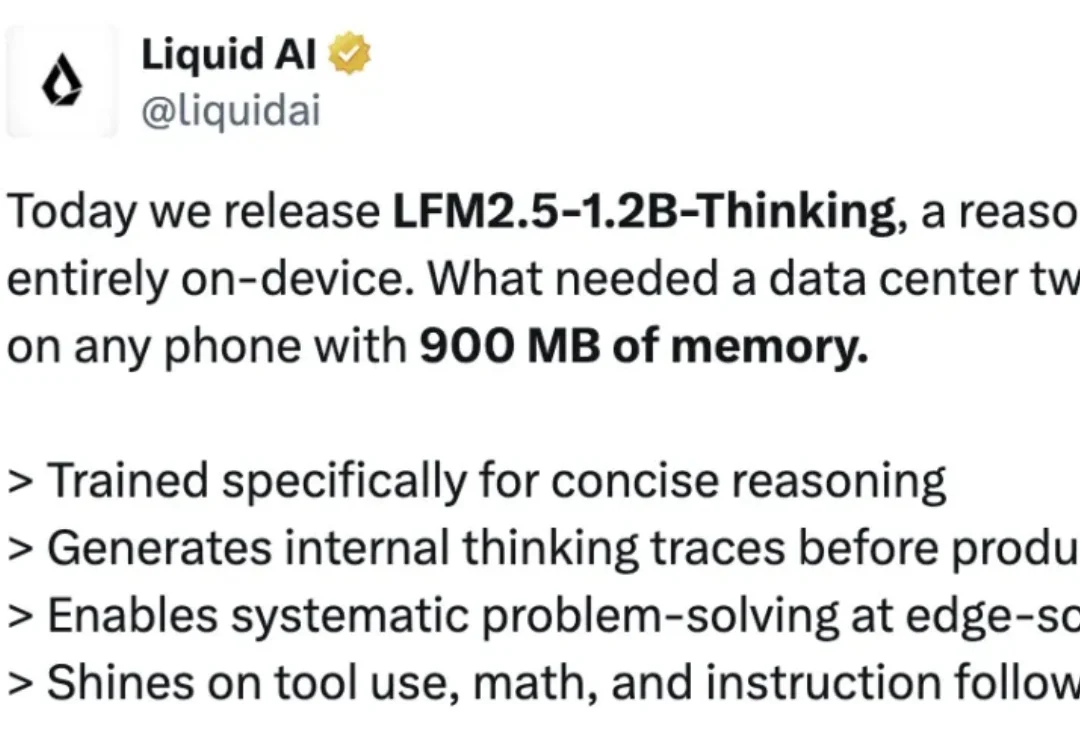

就在刚刚,Liquid AI 又一次在 LFM 模型上放大招。他们正式发布并开源了 LFM2.5-1.2B-Thinking,一款可完全在端侧运行的推理模型。Liquid AI 声称,该模型专门为简洁推理而训练;在生成最终答案前,会先生成内部思考轨迹;在端侧级别的低延迟条件下,实现系统化的问题求解;在工具使用、数学推理和指令遵循方面表现尤为出色。

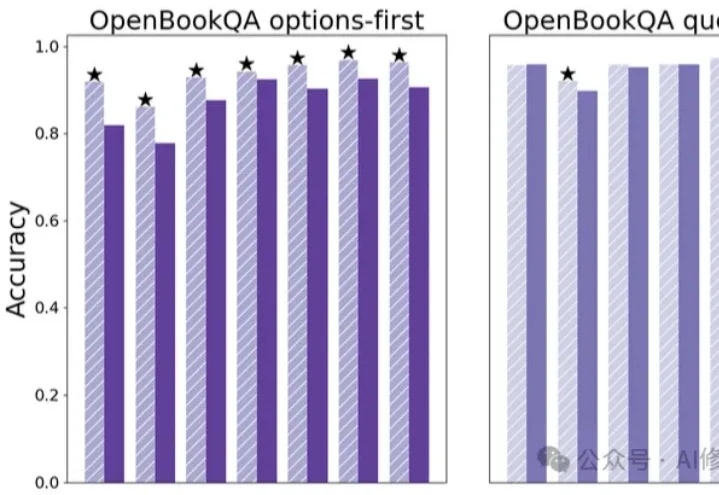

竟然只需要一次Ctrl+V?这可能是深度学习领域为数不多的“免费午餐”。

随着AI浪潮的袭来,笔者本人以及团队都及时的调整了业务方向,转型为一名AI开发者和AI产品开发团队,常常需要微调大模型注入业务场景依赖的私域知识,然后再把大模型部署上线进行推理,以支撑业务智能体或智能问答产品的逻辑流程。

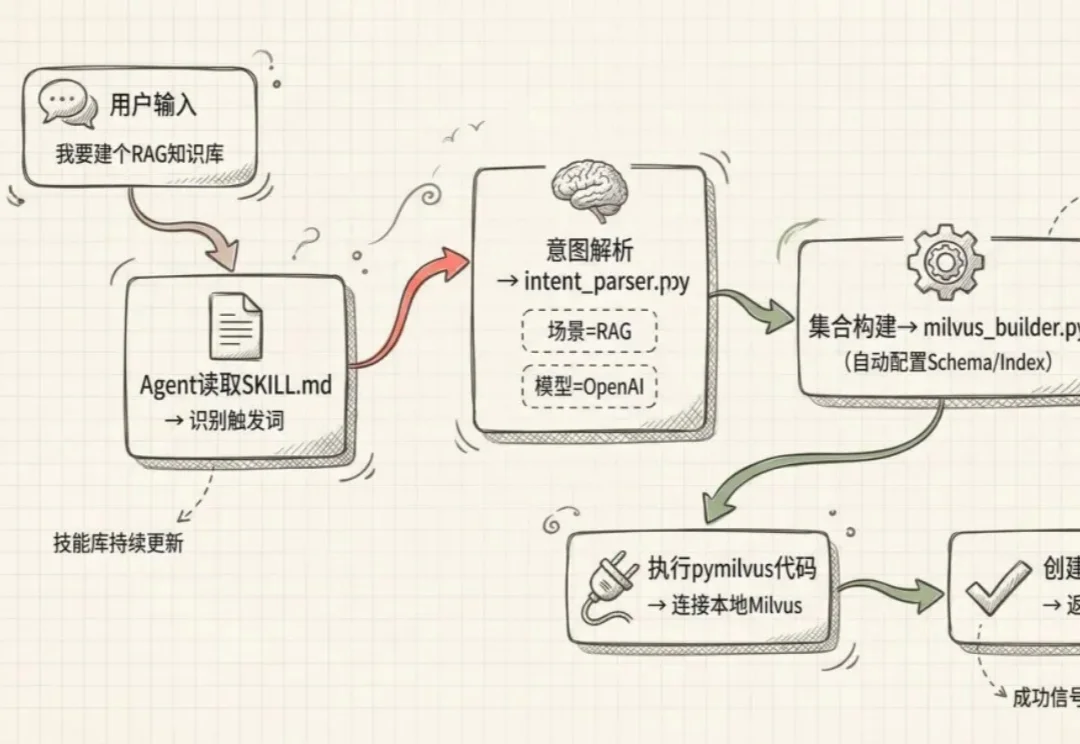

Agent很好,但要做好工具调用能才能跑得通。

近日,中国科学技术大学(USTC)联合新疆师范大学、中关村人工智能研究院、香港理工大学,在数据驱动的多功能双连通多尺度结构逆向设计领域取得重要突破。

现有AI记忆评测存在局限,如数据源单一、忽视变化本质、注入成本高等。CloneMem通过层次化生成框架构建合成人生,设计贴近真实场景的评测任务,涵盖多种问题类型。