谷歌:全栈AI之王

谷歌:全栈AI之王随着Gemini 3模型与第七代TPU的强势发布,谷歌终于打破了OpenAI与英伟达主导的市场叙事,宣告这一「沉睡的巨人」已凭借硬核实力完全醒来。

随着Gemini 3模型与第七代TPU的强势发布,谷歌终于打破了OpenAI与英伟达主导的市场叙事,宣告这一「沉睡的巨人」已凭借硬核实力完全醒来。

刚刚,梁文锋入选《自然》2025年度十大人物榜单!Nature给出的评语是:科技颠覆者!正式报道中,则用「这位中国金融奇才的DeepSeek AI模型惊艳了世界」。

这一次,AI真的是快要砸掉我的饭碗了。智谱最新升级的新一代视觉推理模型——GLM-4.6V。在深度体验一波之后,我们发现写图文并茂的公众号推文,还只是GLM-4.6V能力的一隅。

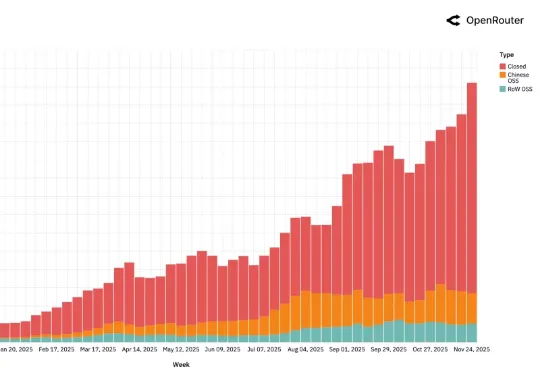

AI 领域迄今最大规模的用户行为实录,刚刚发布了。这是全球模型聚合平台 OpenRouter 联合硅谷顶级风投 a16z 发布的一份报告,基于全球 100 万亿次真实 API 调用、覆盖 300+款 AI 模型、60+家供应商、超过 50% 非美国用户 。

今日,美团正式发布并开源图像生成模型LongCat-Image,这是一款在图像编辑能力上达到开源SOTA水准的6B参数模型,重点瞄准文生图与单图编辑两大核心场景。在实际体验中,它在连续改图、风格变化和材质细节上表现较好,但在复杂排版场景下,中文文字渲染仍存在不稳定的情况。

李笛携原小冰核心团队创立新公司“明日新程”(Nextie),聚焦群体智能与认知大模型,推出内测产品“团子”,通过多智能体协作提升AI认知能力,计划2026年1月7日上线。奇绩创坛参与投资。

目标物理世界的“ChatGPT时刻”。

今年以来,开源项目LightX2V 及其 4 步视频生成蒸馏模型在 ComfyUI 社区迅速走红,单月下载量超过 170 万次。越来越多创作者用它在消费级显卡上完成高质量视频生成,把“等几分钟出一段视频”变成“边看边出片”。

最近,Google Research 发布了一篇 Blog《Titans + MIRAS:帮助人工智能拥有长期记忆》。它们允许 AI 模型在运行过程中更新其核心内存,从而更快地工作并处理海量上下文。

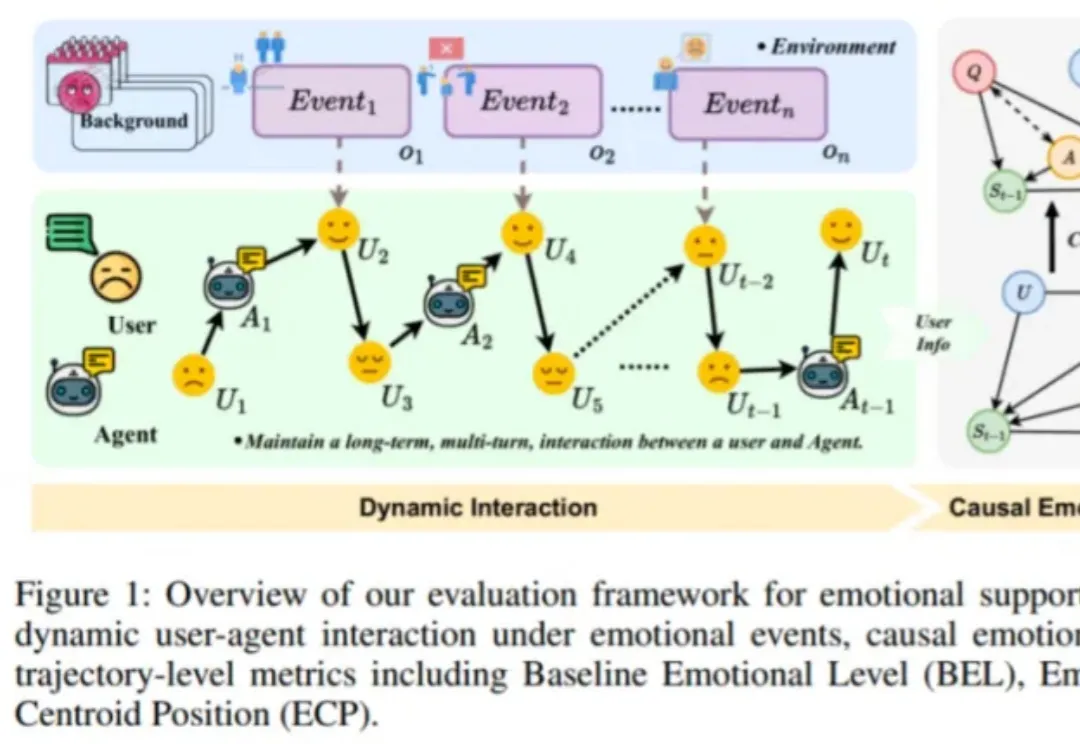

近日,由趣丸科技与北京大学软件工程国家工程研究中心共同发表的《Detecting Emotional Dynamic Trajectories: An Evaluation Framework for Emotional Support in Language Models(检测情感动态轨迹:大语言模型情感支持的评估框架)》论文,获 AAAI 2026 录用。