阿里妈妈搜索广告2024大模型思考与实践

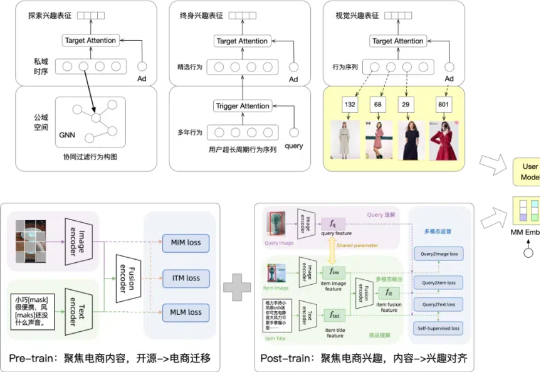

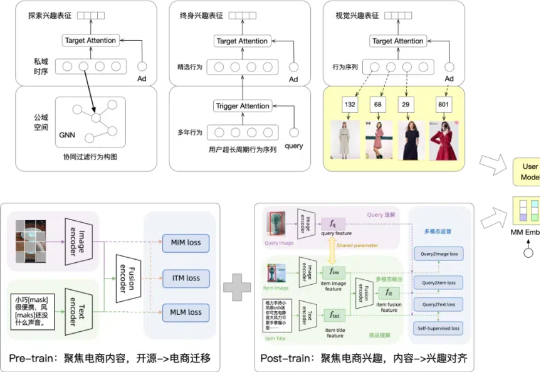

阿里妈妈搜索广告2024大模型思考与实践随着大模型时代的到来,搜推广模型是否具备新的进化空间?能否像深度学习时期那样迸发出旺盛的迭代生命力?带着这样的期待,阿里妈妈搜索广告在过去两年的持续探索中,逐步厘清了一些关键问题,成功落地了多个优化方向。

随着大模型时代的到来,搜推广模型是否具备新的进化空间?能否像深度学习时期那样迸发出旺盛的迭代生命力?带着这样的期待,阿里妈妈搜索广告在过去两年的持续探索中,逐步厘清了一些关键问题,成功落地了多个优化方向。

最近, Meta首席AI科学家杨立昆接受海外播客This Is IT 的专访,探讨了深度学习的发展历程、机器学习的三种范式、莫拉维克悖论与AI发展的限制、训练AI模型的资源、AI基础设施投资等话题。

哈尔滨工业大学团队提出HEROS-GAN技术,通过生成式深度学习将低成本加速度计信号转化为高精度信号,突破其精度与量程瓶颈。该技术利用最优传输监督和拉普拉斯能量调制,使0.5美元的传感器达到200美元高端设备的性能,为工业、医疗等领域应用带来变革。

利用闲置算力满足 AI 初创企业的需求。由于对运行 AI 模型的需求激增,对算力的需求也随之激增。世界各地的公司都在努力寻求运行更高级 AI 模型所需的 GPU。虽然 GPU 并非运行 AI 模型的唯一选择,但它们已成为首选的硬件,因为它们能够有效地同时处理多项操作,而这是开发深度学习模型时的一个关键特性。

脑机接口技术炙手可热,马斯克的Neuralink更是吸引了全球目光。然而其侵入式方案的风险不容忽视。Meta AI则另辟蹊径,近日推出了非侵入式的Brain2Qwerty深度学习模型,它能通过分析脑电图或脑磁图「读」出人们在键盘上输入的文字。

1月23日,在第55届世界经济论坛(冬季达沃斯)上,“深度学习”三巨头之一、图灵奖得主、Meta AI首席科学家杨立昆(Yann LeCun),如此对腾讯新闻《一线》透露Meta2025年在AI领域的投资规模。

Keras之父官宣创业了!全新成立的实验室Ndea,押注了一条通往AGI的新路线——深度学习+程序合成。值得一提的是,这条新路,曾是Keras之父在谷歌搞的业余项目。

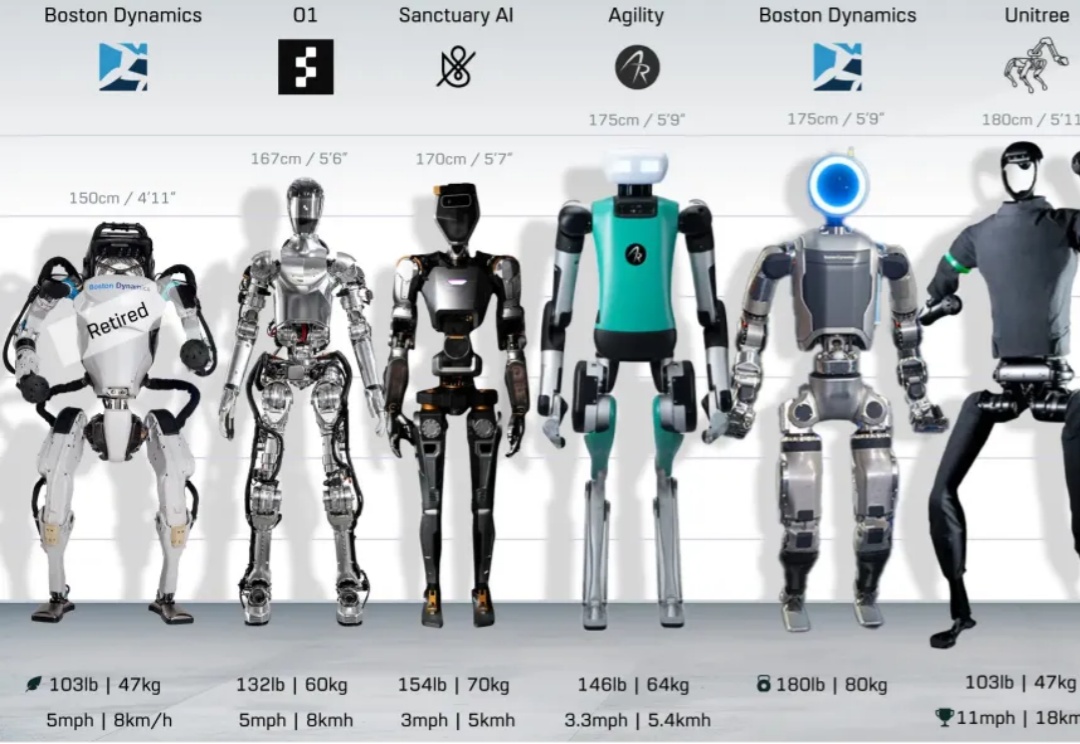

随着AI时代的到来,算法、大模型、深度学习等技术飞速发展,使得人形机器人成为了面向未来的黄金赛道。

AI末日将近? 深度学习三巨头之一、被称为AI教父的Hinton教授在最新演讲中指出,技术的发展速度远远超出了他的预期,如果再不加以监管人类将会在10年内灭绝

印度最大的癌症护理网络 —— 健康全球企业(HCG)近日宣布与全球知名咨询公司埃森哲建立战略合作关系,旨在利用生成性人工智能和深度学习技术,推动癌症研究和治疗的创新。