北大彭一杰教授课题组提出RiskPO,用风险度量优化重塑大模型后训练

北大彭一杰教授课题组提出RiskPO,用风险度量优化重塑大模型后训练当强化学习(RL)成为大模型后训练的核心工具,「带可验证奖励的强化学习(RLVR)」凭借客观的二元反馈(如解题对错),迅速成为提升推理能力的主流范式。从数学解题到代码生成,RLVR 本应推动模型突破「已知答案采样」的局限,真正掌握深度推理逻辑 —— 但现实是,以 GRPO 为代表的主流方法正陷入「均值优化陷阱」。

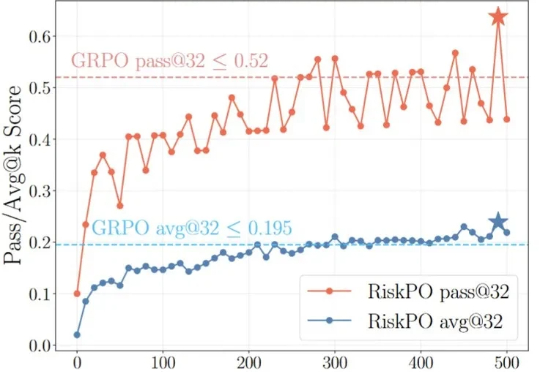

当强化学习(RL)成为大模型后训练的核心工具,「带可验证奖励的强化学习(RLVR)」凭借客观的二元反馈(如解题对错),迅速成为提升推理能力的主流范式。从数学解题到代码生成,RLVR 本应推动模型突破「已知答案采样」的局限,真正掌握深度推理逻辑 —— 但现实是,以 GRPO 为代表的主流方法正陷入「均值优化陷阱」。

强化学习·RL范式尝试为LLMs应用于广泛的Agentic AI甚至构建AGI打开了一扇“深度推理”的大门,而RL是否是唯一且work的一扇门,先按下不表(不作为今天跟大家唠的重点),至少目前看来,随着o1/o3/r1/qwq..等一众语言推理模型的快速发展,正推动着LLMs和Agentic AI在不同领域的价值与作用,

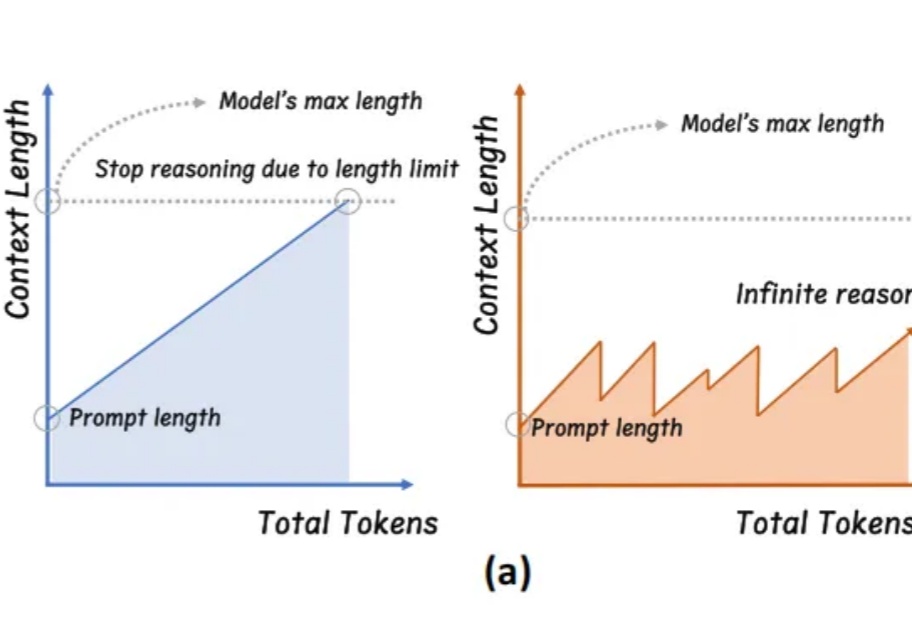

学会“适当暂停与总结”,大模型终于实现无限推理。

英伟达H20也不能用了。中国大模型还能好吗?

一句话看懂:o3以深度推理与工具调用能力领跑复杂任务,GPT-4.1超长上下文与精准指令执行适合API开发,而o4-mini则堪称日常任务的「性价比之王」。

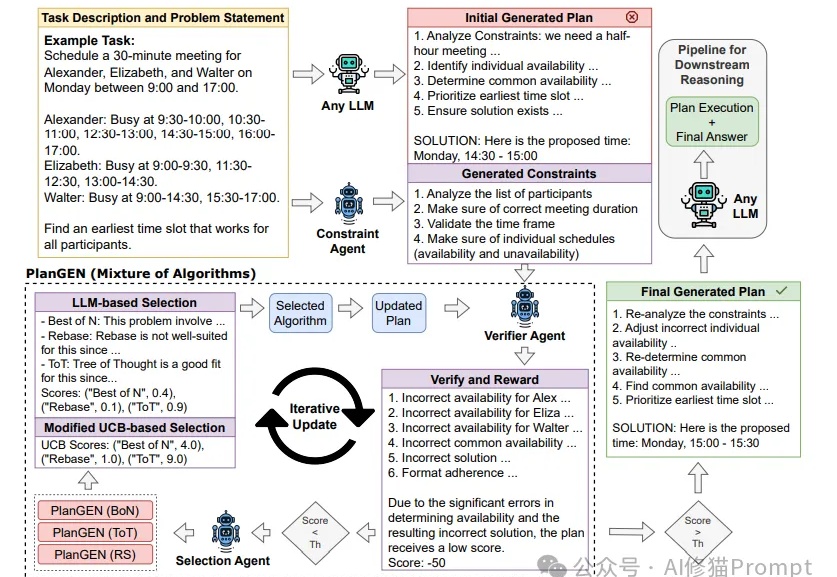

Agent这两天随着邀请码进入公众视野,展示了不凡的推理能力。然而,当面对需要精确规划和深度推理的复杂问题时,即使是最先进的LLMs也常常力不从心。Google研究团队提出的PlanGEN框架,正是为解决这一挑战而生。

2025年,中国大模型迎来最高光时刻。DeepSeek凭借深度推理、低成本强势崛起,中科院系AI企业祭出的YAYI-Ultra大模型在代码能力上超越GPT-4o,成功跻身OpenCompas榜单全球前十,高精度和低能耗兼而有之。

AI竞赛白热化!Anthropic秘密研发一种与众不同的AI——语言模型与可控推理能力相结合的混合模型。模型包括一个独特的「滑动条」功能,它赋予开发者对计算资源和成本前所未有的控制权。

唯一一个在全国产算力上训练的深度推理模型来了!今天,讯飞星火深度推理大模型X1发布,发布会上现场摇数学题开做,答案全部正确。强强pk全国产胜,中文数学能力远超国内外「o1」级推理模型?

AI搜索转向深度推理,挑战传统搜索市场。与此前“大海捞针”不同,最近更新中AI搜索长了“脑子”,在面对问题时,能像人一样先拆解步骤,再精准搜索,最后呈现答案。