当两个「世界第一」同时出现|写在混元与可灵先后宣布登顶全球第一之后

当两个「世界第一」同时出现|写在混元与可灵先后宣布登顶全球第一之后最近,两条消息同时刷屏:先是 9 月 23 日快手宣布其可灵 2.5 Turbo 图生/文生视频模型,推出 10 天后,即在 Artificial Analysis 上成为世界第一;紧接着,腾讯也宣布混元图像 3.0 模型在 LMArena 上成为世界第一。

最近,两条消息同时刷屏:先是 9 月 23 日快手宣布其可灵 2.5 Turbo 图生/文生视频模型,推出 10 天后,即在 Artificial Analysis 上成为世界第一;紧接着,腾讯也宣布混元图像 3.0 模型在 LMArena 上成为世界第一。

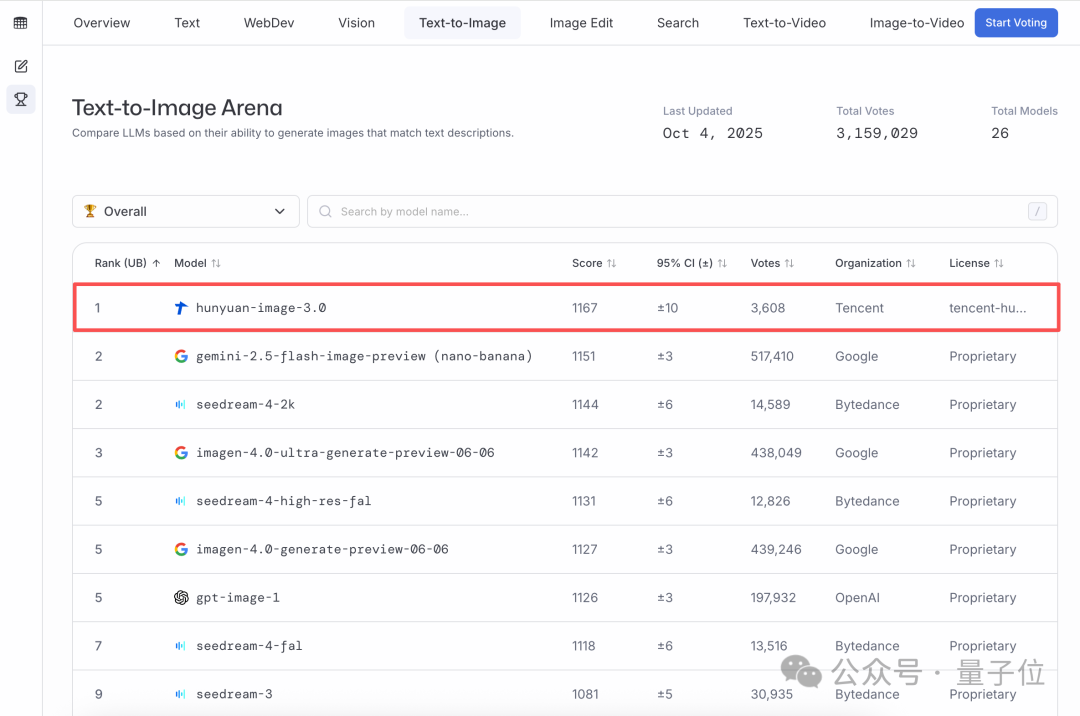

全球文生图大模型王座,易主了。就在刚刚,LMArena竞技场发布了最新的文生图榜单,第一名来自中国,属于腾讯混元图像3.0!不仅超越了谷歌的Nano Banana,也超越了字节的Seedream和OpenAI的gpt-Image,在全球26个大模型中稳居第一。

业界首个高质量原生3D组件生成模型来了!来自腾讯混元3D团队。现有的3D生成算法通常会生成一体化的3D模型,而下游应用通常需要语义可分解的3D形状,即3D物体的每一个组件需要单独地生成出来。

先给你们看个刺激的:国外有个哥们儿,自己一个人用 AI做 3D 模型,最高单日收入折算快 1 万人民币了:一年收入30 万刀。而他在用的也只是通过提示词让 AI 生成对应的 3D 模型,或者上传图片生成 3D 模型。

不用在建模、UV、贴图软件之间反复横跳,一个工作台就能得到:这是腾讯专为3D设计师、游戏开发者、建模师等打造的专业级AI工作台混元3D Studio。

腾讯混元 3D 发布了全新 3.0 版本,带来了更丰富的细节和更真实的质感,我们的创意可以不用停留在文字、图片或视频,而是现实世界里,能够摸得着的物理实体。

腾讯元宝日活冲前三、混元3D建模精度飙3倍;还要砸1.5亿在沙特建新数据中心!2025腾讯全球数字生态大会这波信息量不小。表面没大张旗鼓,实则在C端悄悄打磨起了大模型产品。从刚公布的数据来看,成果还挺显眼。

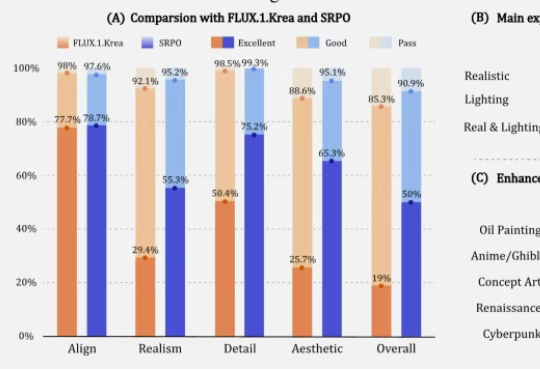

让AI生成的图像更符合人类精细偏好,在32块H20上训练10分钟就能收敛。腾讯混元新方法让微调的FLUX1.dev模型人工评估的真实感和美学评分提高3倍以上。

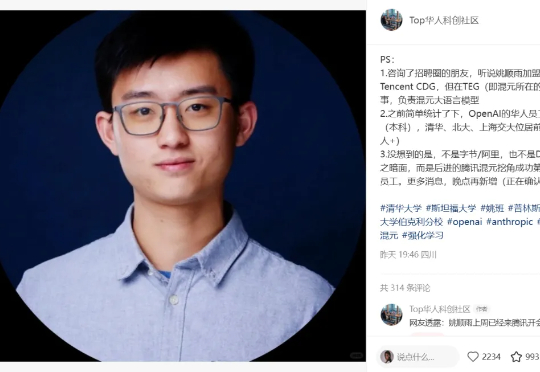

昨天,有消息称,OpenAI 著名研究者、清华校友、著名博客《AI 下半场》的作者姚顺雨已经加入了腾讯混元大模型团队,并且还传言说他将在这里组建一支自己领导的研究团队。

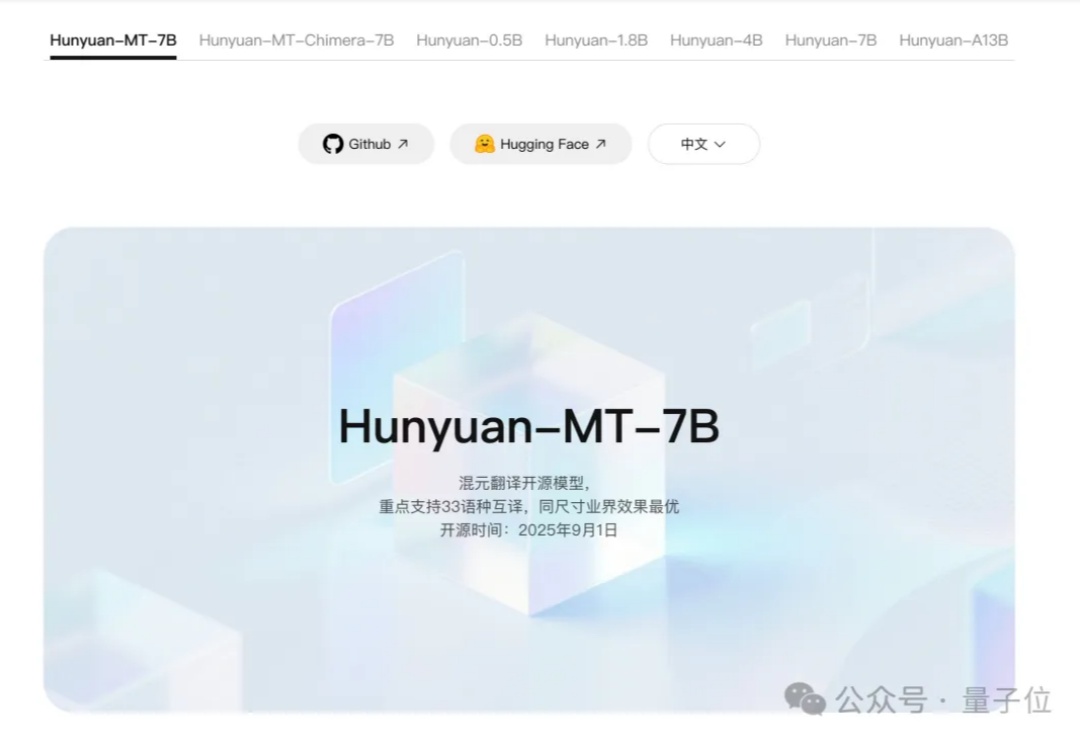

腾讯混元,刚刚又拿下一个国际冠军—— Hunyuan-MT-7B,以7B总参数量获得国际翻译比赛冠军。该模型支持33个语种、5种民汉语言/方言互译,是一个能力全面的轻量级翻译模型。