Transformer挑战者出现!斯坦福CMU联合团队,开源模型及代码,公司已创办

Transformer挑战者出现!斯坦福CMU联合团队,开源模型及代码,公司已创办现在ChatGPT等大模型一大痛点:处理长文本算力消耗巨大,背后原因是Transformer架构中注意力机制的二次复杂度。

来自主题: AI技术研报

7171 点击 2023-12-05 17:32

搜索

搜索

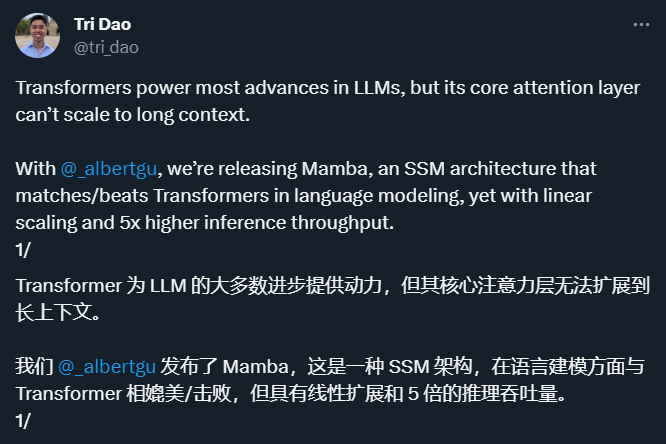

现在ChatGPT等大模型一大痛点:处理长文本算力消耗巨大,背后原因是Transformer架构中注意力机制的二次复杂度。

屹立不倒的 Transformer 迎来了一个强劲竞争者。在别的领域,如果你想形容一个东西非常重要,你可能将其形容为「撑起了某领域的半壁江山」。但在 AI 大模型领域,Transformer 架构不能这么形容,因为它几乎撑起了「整个江山」。