低成本算法,大幅提升视觉分类鲁棒性!悉尼大学华人团队发布全新EdgeNet方法

低成本算法,大幅提升视觉分类鲁棒性!悉尼大学华人团队发布全新EdgeNet方法EdgeNet可以处理从干净的自然图像或嘈杂的对抗性图像中提取的边缘,产生鲁棒的特征,具有轻量级、即插即用等特点,能够无缝集成到现有的预训练深度网络中,训练成本低。

EdgeNet可以处理从干净的自然图像或嘈杂的对抗性图像中提取的边缘,产生鲁棒的特征,具有轻量级、即插即用等特点,能够无缝集成到现有的预训练深度网络中,训练成本低。

随着 Sora 的成功发布,视频 DiT 模型得到了大量的关注和讨论。设计稳定的超大规模神经网络一直是视觉生成领域的研究重点。DiT [1] 的成功为图像生成的规模化提供了可能性。

以脉冲神经网络(SNN)为代表的脑启发神经形态计算(neuromorphic computing)由于计算上的节能性质在最近几年受到了越来越多的关注 [1]。受启发于人脑中的生物神经元,神经形态计算通过模拟并行的存内计算、基于脉冲信号的事件驱动计算等生物特性,能够在不同于冯诺依曼架构的神经形态芯片上以低功耗实现神经网络计算。

作为麻省理工学院(MIT)电气工程与计算机科学系(EECS)副教授,何恺明第一节课讲授了卷积神经网络的基本知识。

扩散模型,迎来了一项重大新应用——像Sora生成视频一样,给神经网络生成参数,直接打入了AI的底层!

困扰可控核聚变的一项重大难题,被AI成功攻克了!普林斯顿团队通过训练神经网络,提前300毫秒就预测了核聚变中的等离子不稳定态,因而能够防止等离子体的逃逸。人类离无穷尽的清洁能源,又近了一步。

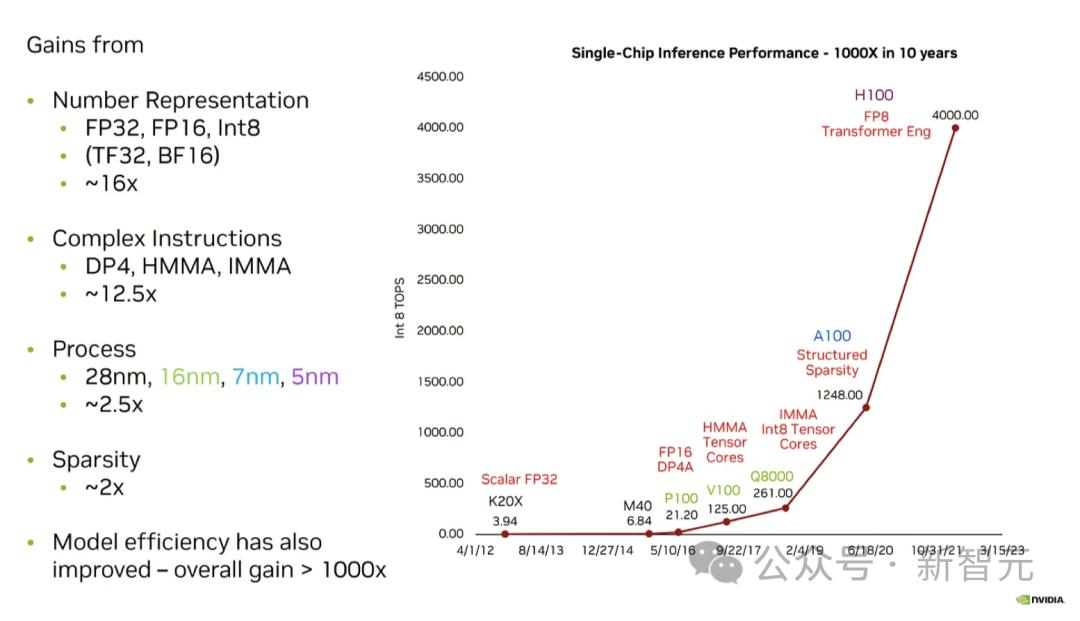

为了应对大模型不断复杂的推理和训练,英伟达、AMD、英特尔、谷歌、微软、Meta、Arm、高通、MatX以及Lemurian Labs,纷纷开始研发全新的硬件解决方案。

神经网络由于自身的特点而容易受到对抗性攻击,然而,谷歌DeepMind的最新研究表明,我们人类的判断也会受到这种对抗性扰动的影响

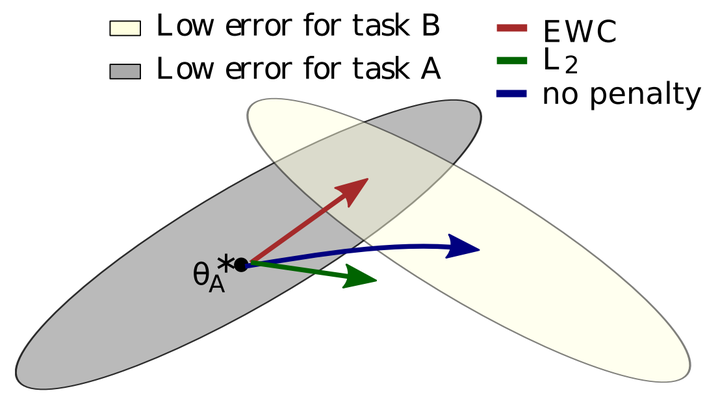

所谓灾难性遗忘,就是一个在原始任务上训练好的神经网络在训练完新任务后,在原始任务上的表现崩溃式的降低。

神经网络的概念、技术基本实现原理、应用场景与产品案例等方面的内容,一起来看看,或许会对AI产品经理们有所帮助。