论文自动变漫画PPT!Nano Banana同款用秘塔免费生成,还有一对一语音讲解

论文自动变漫画PPT!Nano Banana同款用秘塔免费生成,还有一对一语音讲解Nano Banana 2的知识变漫画玩法可谓是彻底火出了圈。

Nano Banana 2的知识变漫画玩法可谓是彻底火出了圈。

在AI快速迭代的浪潮下,搜索正在经历一场前所未有的重构。秘塔AI最新推出的「Agentic Search」模式,不再停留于「问什么答什么」,而是「边想边搜边做」。

Bing Search API 将于2025年8月下线,如果你正寻找替代方案,不妨试试秘塔。 过去一年,我们自建了数百亿规模的多语言索引库,并在“秘塔AI搜索”中每天承受千万级的调用实践。

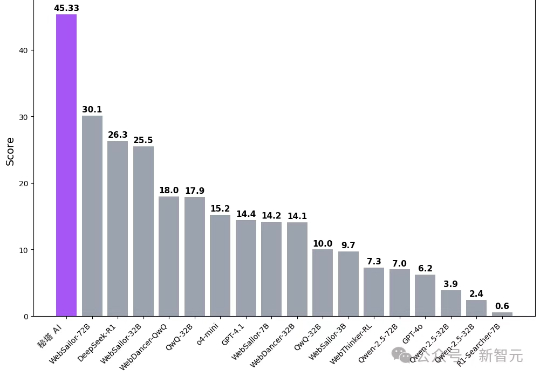

刚刚,国内首个免费可用Deep Research上线了!它在多个权威评测中拿下第一,准确率直接碾压开源WebSailor。研究过程中,它能多线迭代追搜,直至逻辑闭环。更绝的是,一键生成炫酷的互动研究报告,视觉效果直接拉满。

太卷了,卷麻了! 对标海外的Deep Research(深度研究)功能,现在咱国内,免费,想咋用就咋用。

昨天晚上,秘塔AI搜索悄悄上了一个新功能。测试完以后,我觉得这玩意,还是值得我将近通宵写一篇的。

是的,秘塔AI搜索推出了全新“极速”模型。通过在GPU上进行kernel fusion,以及在CPU上进行动态编译优化,我们在单张H800 GPU上实现了最高400 tokens/秒的响应速度,大部分问题2秒内就能答完。

自去年11月底,360刚刚推出纳米AI搜索的时候,AI真探社就曾发过一篇文章跟进报道。当时国内的AI搜索赛道还是一片蓝海,除了百度作为ALL IN AI时代的代表以外,也就天工搜索和秘塔AI搜索还在这个赛道里面,所以我们当时和主流观点一样,认为360这个老牌搜索大厂的入局或能起到一个鲶鱼效应,甚至有再现曾经百度搜索对打360搜索的名场面的可能性:

在当今流水线式的教育体制下,我们就像廉价的零件一样被生产出来。因为数量巨大,没人会对每一个人的教学质量负责。——《上海交通大学生存手册》

给我整不会了。