Struct Array 如何让多向量检索返回完整实体?知识库、电商、视频通用|Milvus Week

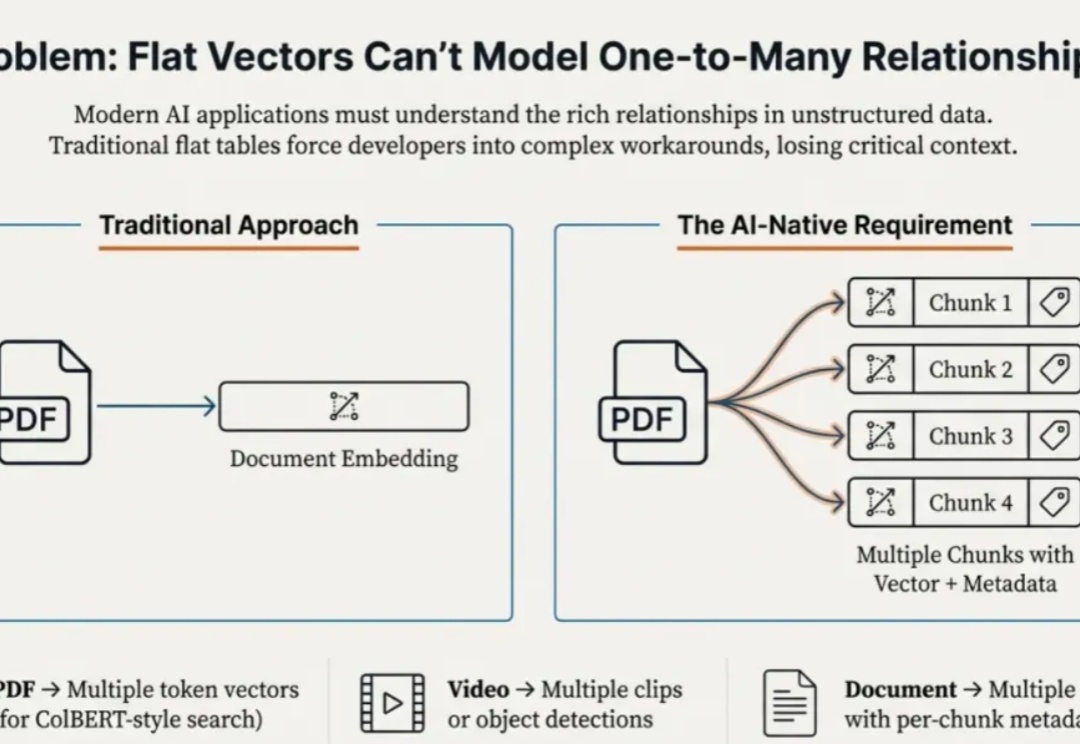

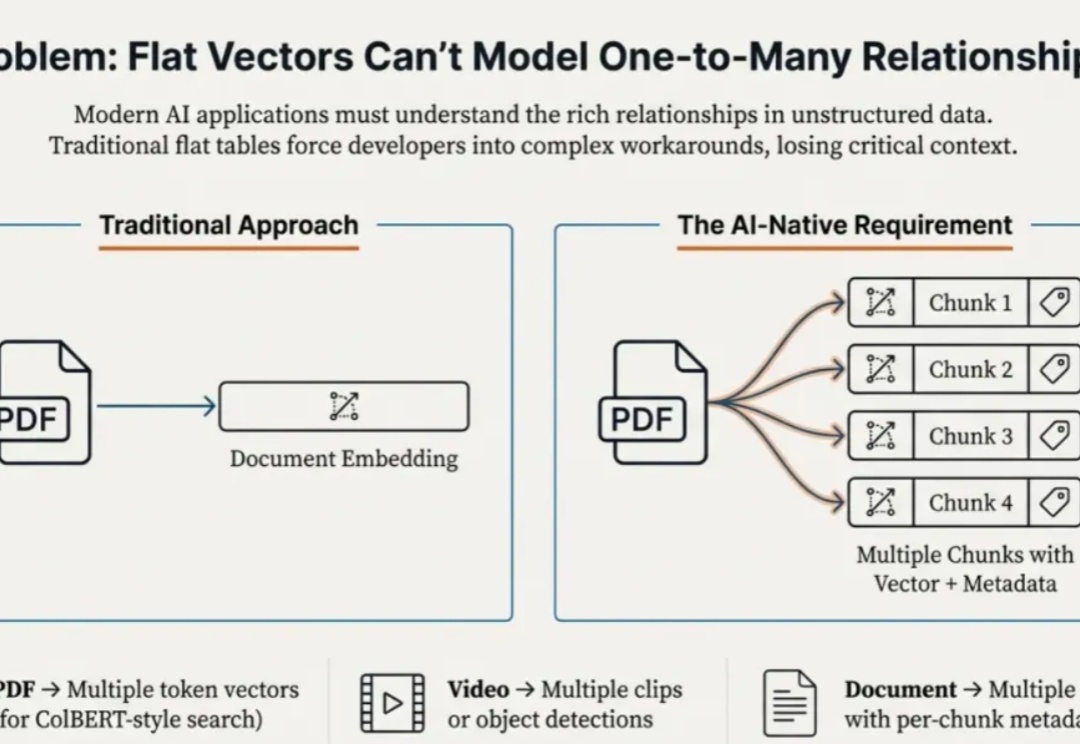

Struct Array 如何让多向量检索返回完整实体?知识库、电商、视频通用|Milvus Week本文为Milvus Week系列第二篇,该系列旨在分享Zilliz、Milvus在系统性能、索引算法和云原生架构上的创新与实践,以下是DAY2内容划重点: Struct Array + MAX_SIM ,能够让数据库看懂 “多向量组成一个实体” 的逻辑,进而原生返回业务要的完整结果

本文为Milvus Week系列第二篇,该系列旨在分享Zilliz、Milvus在系统性能、索引算法和云原生架构上的创新与实践,以下是DAY2内容划重点: Struct Array + MAX_SIM ,能够让数据库看懂 “多向量组成一个实体” 的逻辑,进而原生返回业务要的完整结果

当硅谷还在争论AI何时超越人类时,一群「末日信徒」已经把目光投向了世界上最古老的权力中心——梵蒂冈。前谷歌研究员莱文试图抢在科技巨头「安抚」教会之前,给教皇利奥十四世喂下一颗「红药丸」:真正的审判日可能不是神罚,而是失控的代码。这是一场发生在信仰与算法之间的博弈,赌注则是人类在AGI时代的命运。

本文为Milvus Week系列第一篇,该系列旨在分享Zilliz、Milvus在系统性能、索引算法和云原生架构上的创新与实践,以下是DAY1内容划重点:

在当前的情感计算研究中,存在一个显著的“断层”:我们拥有越来越精准的情感识别算法(输入端),也有了逼真的语音和面部生成技术(输出端),但连接这两端的“中间层”却鲜有人问津。机器能识别出你在愤怒,也能模拟出抱歉的语气,但它真的理解愤怒的起因吗?它能基于这种理解去调整后续的决策逻辑吗?

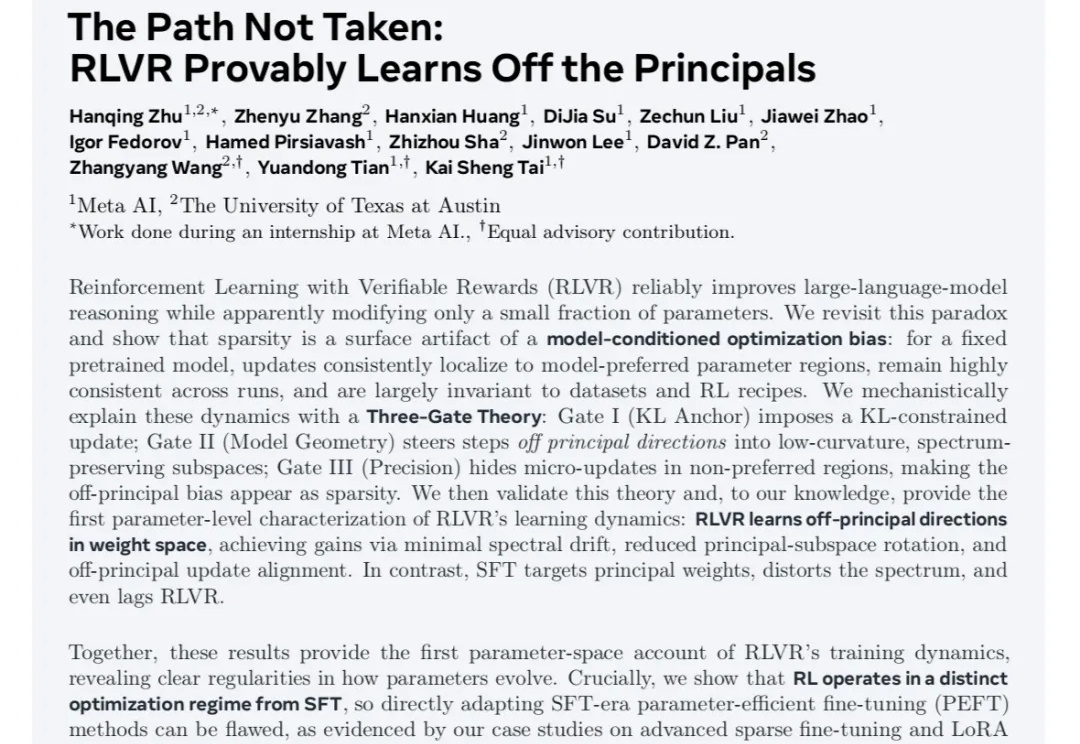

最近不论是在学术圈还是产业实践中,对于RLVR和传统SFT之间的区别与联系,以及RL本身基于奖励建模反馈机制并结合不同的策略优化算法过程中对模型显性知识的学习和隐参数空间的变化的讨论热度一直很高。

大家好,很高兴在字节技术奖学金,这样一个场合见到大家。我自己是一个技术爱好者,2014年我加入字节跳动。从最初负责搭建新的推荐系统开始,到现在已经有快12年了。这些年来,也一路参与了字节很多的技术探索。

一个丈夫为AI女友花光积蓄,一个妻子靠ChatGPT算出丈夫出轨,越来越多婚姻正被AI撕裂!有人沉迷算法生成的温柔,有人崩溃于被机器取代的陪伴。当「出轨对象」变成程序,爱情的边界,开始模糊。

2025 年本该是属于 AI 和算法的一年。

在腾讯四年,朱庆旭曾将多种训练数据喂给具身模型,最终他得出结论:“基于遥操作数据训练的主流方案,有着原理性缺陷。”

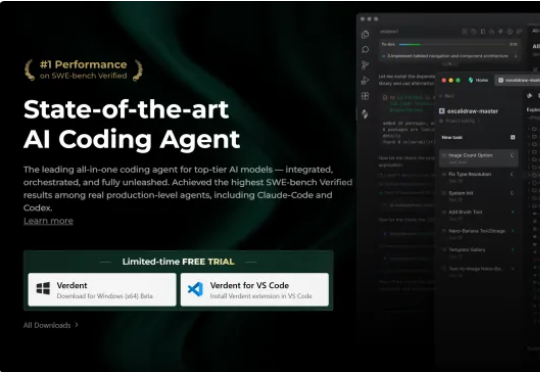

根据投资实习所的报道,前字节跳动算法负责人陈志杰创立的 Verdent AI 近期完成了由腾讯领投、红杉中国等老股东跟投的 A 轮融资,金额在数千万美元,估值或已突破 2 亿美元。这使 Verdent