Sora2之后,又来了个全新的影视级AI视频模型,它的名字,叫GAGA。

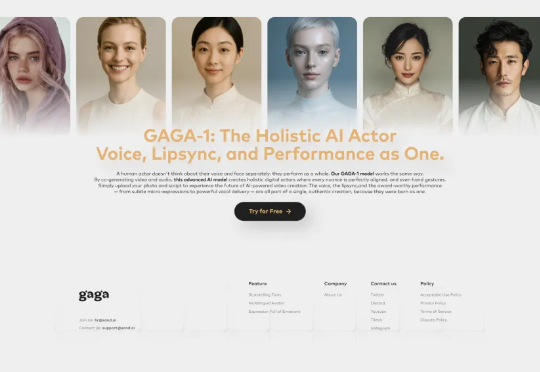

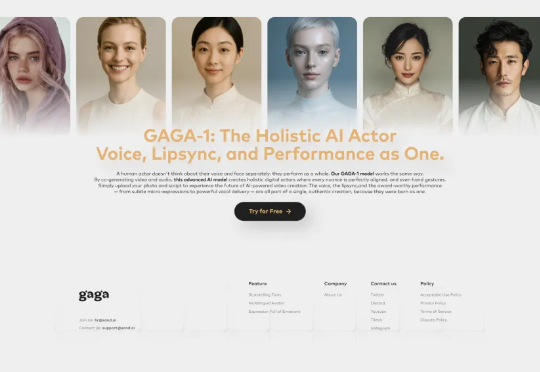

Sora2之后,又来了个全新的影视级AI视频模型,它的名字,叫GAGA。Sora2爆火之后,随之而来的AI视频领域的新产品。 来自我的好朋友,曹越老师的Sand.ai。凌晨,他们终于上线了他们全新的音画同步视频模型GAGA-1,在人物表演上,我觉得,已经算是现在的TOP级了。

Sora2爆火之后,随之而来的AI视频领域的新产品。 来自我的好朋友,曹越老师的Sand.ai。凌晨,他们终于上线了他们全新的音画同步视频模型GAGA-1,在人物表演上,我觉得,已经算是现在的TOP级了。

现在AI给影视行业带来的变化,就像当年从胶片到数字的革新一样。 作者 | 李威(北京) 国庆假期刚开始,Sora 2就引爆了整个AI圈子。 这个新的视频模型带来了对现实世界更精准的呈现,有更强的可控性

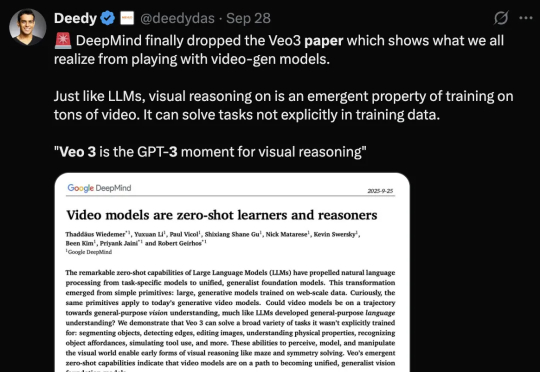

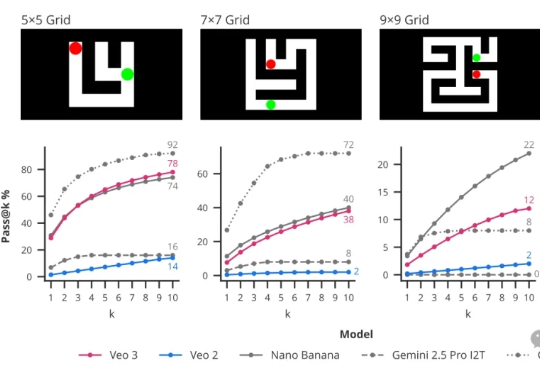

DeepMind公开了有关Veo 3视频模型最新论文!论文提出了「帧链」(Chain-of-Frames,CoF),认为视频模型也可能像通用大模型一样具备推理能力。零样本能力的涌现,表明视频模型的「GPT-3时刻」来了。

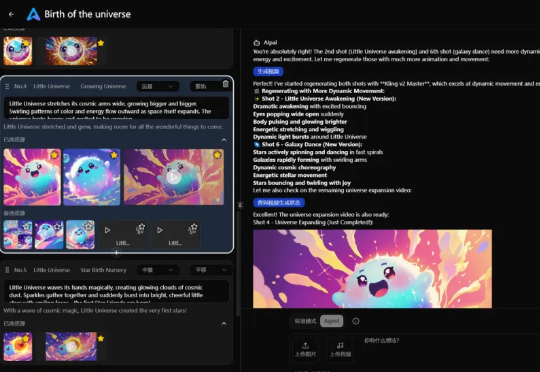

CoT思维链的下一步是什么? DeepMind提出帧链CoF(chain-of-frames)。

刚刚,快手可灵AI基座模型再升级,推出可灵2.5 Turbo视频生成模型。AI视频玩家抹一把老泪,终于有AI视频模型让运动员们拥有不鬼畜自由了!a16z合伙人在𝕏上分享了一个可灵2.5 Turbo生成的视频:

可灵正式发布了他们的 2.5 Turbo (app.klingai.com)版本视频模型,作为超创提前试了一下,这次的进步真的很大。

自 Sora 亮相以来,AI 视频的真实感突飞猛进,但可控性仍是瓶颈:模型像才华横溢却随性的摄影师,难以精准执行 “导演指令”。我们能否让 AI 做到: 仅凭一张静态照片,就能 “脑补” 出整个 3D

可灵2.5,来了。 不仅已经对可灵的超级创作者们正式进行灰度内测,还在这个周末,登上了釜山国际电影节。

AI视频又进化了! Luma AI 发布全球首个推理视频模型,也是首个能够生成工作室级 HDR 的模型。 Ray3 是一款专为讲述故事而设计的 AI 视频模型。 它能够对视觉内容进行思考和推理,并提

一年前,Google 在 AI 赛道上还是「追赶者」的形象。ChatGPT 席卷硅谷时,它显得迟缓。 但短短几个月后,情况突变。 Gemini 2.5 Pro 横扫各大榜单,「香蕉」模型 Nano Banana 让生图、修图成了轻松事;视频模型 Veo 3 展示了物理世界的理解力;Genie 3 甚至能一句话生成一个虚拟世界。