PixVerse V5 突袭上线,我们在「拍我AI」上第一时间深度实测

PixVerse V5 突袭上线,我们在「拍我AI」上第一时间深度实测视频,早已是我们这个时代的默认语言。 从社交媒体的刷屏狂欢到大银幕的光影叙事,我们每个人都深度参与其中。而当 AI 技术让视频的创作门槛骤降,一个更加公平的「AI 视频模型竞技场」也随之拉开帷幕。

视频,早已是我们这个时代的默认语言。 从社交媒体的刷屏狂欢到大银幕的光影叙事,我们每个人都深度参与其中。而当 AI 技术让视频的创作门槛骤降,一个更加公平的「AI 视频模型竞技场」也随之拉开帷幕。

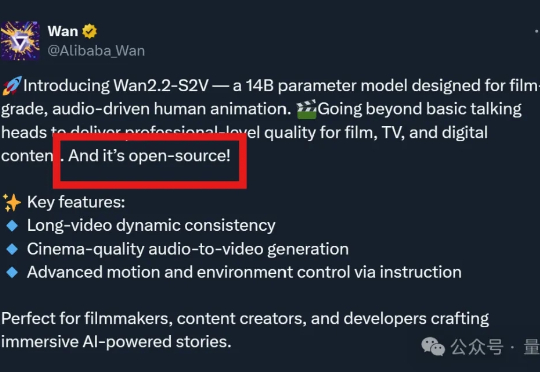

AI视频生成正在迎来“通义时刻”! 就在昨夜,阿里突然发布了一款由音频驱动的14B视频模型Wan2.2-S2V—— 仅需一张图片和一段音频,即可生成面部表情自然、口型一致、肢体动作丝滑的电影级数字人视频。

电影级视频生成模型来了。

世界首个实时AI扩散视频模型炸场,Karpathy亲自站台,颠覆AI视频交互,0延迟+无限时长,每秒24帧不卡顿,MirageLSD首次实现AI直播级生成。

你可能听说过OpenAI的Sora,用数百万视频、千万美元训练出的AI视频模型。 但你能想象,有团队只用3860段视频、不到500美元成本,也能在关键任务上做到SOTA?

今年最火的视频 AI 视频模型 Veo3 ,最近又迎来更新,能让图片开口说话了。Google CEO Sundar Pichai 发 X 说,自从五月 Google 开发者大会以来,用户已经使用 Veo 3 创建了超过 4000 万的视频。

以前常说「要把自己活成一支队伍」,如今感谢 AI,真的实现了。 最近,生数科技旗下 AI 视频模型 Vidu Q1 推出参考生功能,极大简化传统内容生产流程,真正实现「一个人就是一个剧组」!

总部位于洛杉矶的人工智能视频生成初创公司Moonvalley 团队认为,仅靠文本提示无法完成电影制作。

最近,一类「穿越 vlog」爆火了。有人让 Veo 3 变成「时间机器」,将人们带回历史事件中进行现场直播。

AI视频生成,Midjourney终于落下大锤了!今天,V1视频生成模型正式上线,每一帧效果超逼真,网友上手实测惊掉下巴。