开源复现o3图像思考!快手让AI不再被动看图,模型自主生成代码调用工具

开源复现o3图像思考!快手让AI不再被动看图,模型自主生成代码调用工具在Openai 发布o3后,think with image功能得到了业界和学术界的广泛关注。

在Openai 发布o3后,think with image功能得到了业界和学术界的广泛关注。

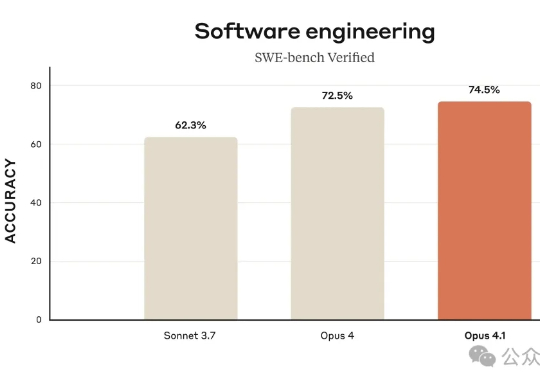

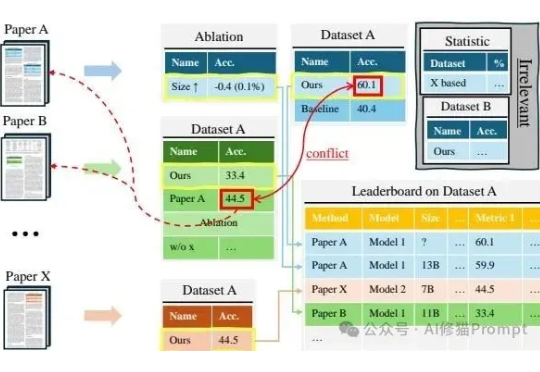

OpenAI在SWE-bench Verified编程测试中仅完成477道题却公布74.9%高分,对比之下,Anthropic的Claude完成全部500题。

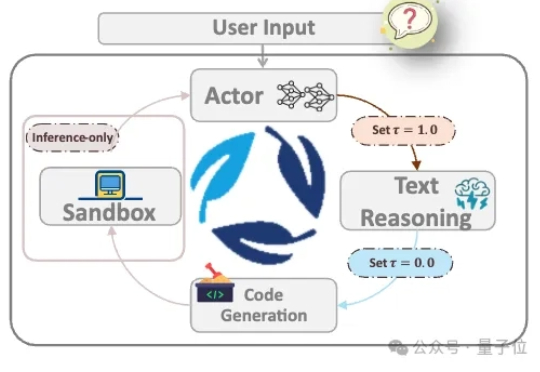

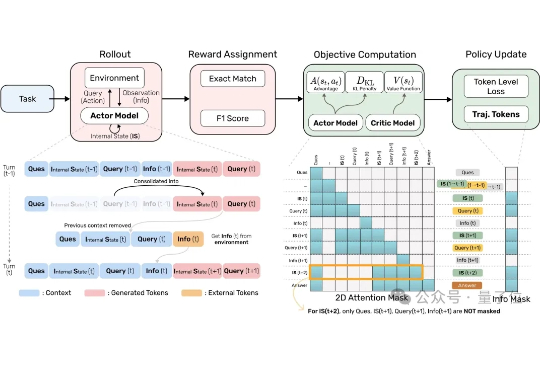

AI Agent正在被要求处理越来越多复杂的任务。 但当它要不停地查资料、跳页面、筛选信息时,显存狂飙、算力吃紧的问题就来了。

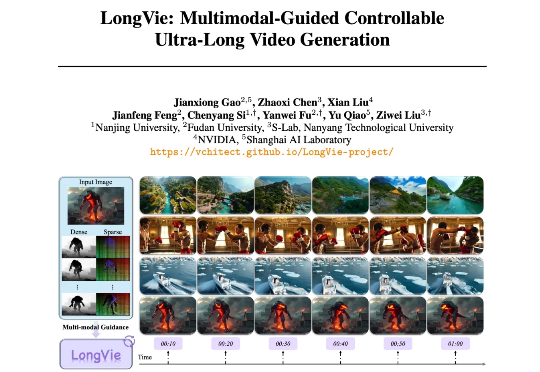

从 Sora 的惊艳亮相到多款高性能开源模型的诞生,视频生成在过去两年迎来爆发式进步,已能生成几十秒的高质量短片。然而,要想生成时长超过 1 分钟、内容与运动可控、风格统一的超长视频,仍面临巨大挑战。

您可能已经在产品里放进了问答、总结、甚至自动报表模块,但表格一上来,体验就变味了,这不奇怪。表格是二维、带结构、还经常跨表跨文,和纯文本完全不一样;项目作者在《Tabular Data Understanding with LLMs》里把这件事掰开揉碎,从输入表示到任务版图,再到评测与未来方向都梳理清楚了。

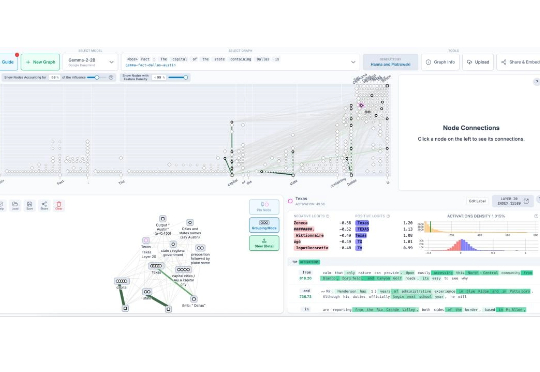

智东西8月20日报道,8月16日,Anthropic最新一期官方油管视频上线,三位AI研究员抽丝剥茧,深入探讨AI研究不应避开的一个关键“谜团”——大模型究竟是怎么思考的?

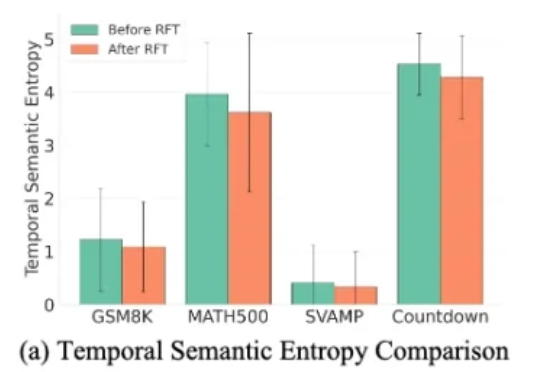

近年来,扩散大语言模型(Diffusion Large Language Models, dLLMs)正迅速崭露头角,成为文本生成领域的一股新势力。与传统自回归(Autoregressive, AR)模型从左到右逐字生成不同,dLLM 依托迭代去噪的生成机制,不仅能够一次性生成多个 token,还能在对话、推理、创作等任务中展现出独特的优势。

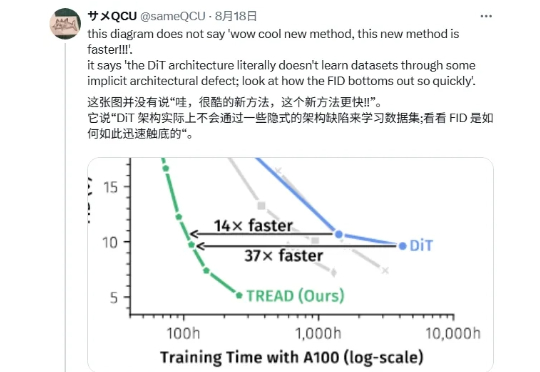

「兄弟们,DiT 是错的!」 最近一篇帖子在 X 上引发了很大的讨论,有博主表示 DiT 存在架构上的缺陷,并附上一张论文截图。

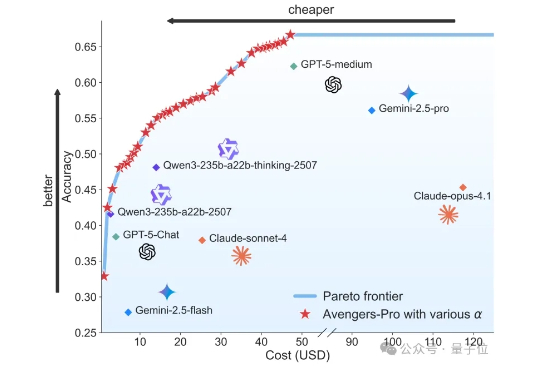

虽然大模型的优越表现令人瞩目,但动辄高昂的使用成本也让不少用户望而却步。 为平衡性能与成本,上海人工智能实验室科研团队基于前期技术积累,开源推出了Avengers-Pro多模型调度路由方案。

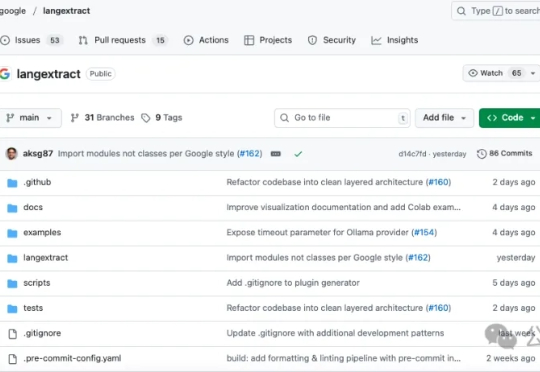

真正的业务宝藏往往就埋藏在那些看似杂乱无章的文本数据之中,即非结构化文本,但问题是,如何高效、可靠地把这些宝藏精准地挖出来,一直是个令人头疼的难题,今天我们就来聊聊最近GitHub12.3k star爆火的Google 开源项目LangExtract,它为这个问题提供了一个相当漂亮的答案。