大模型“天梯赛”来了,让Agent在Kaggle真实任务中进化|佐治亚理工、斯坦福开源

大模型“天梯赛”来了,让Agent在Kaggle真实任务中进化|佐治亚理工、斯坦福开源当前最强大的大语言模型(LLM)虽然代码能力飞速发展,但在解决真实、复杂的机器学习工程(MLE)任务时,仍像是在进行一场“闭卷考试”。它们可以在单次尝试中生成代码,却无法模拟人类工程师那样,在反复的实验、调试、反馈和优化中寻找最优解的真实工作流。

当前最强大的大语言模型(LLM)虽然代码能力飞速发展,但在解决真实、复杂的机器学习工程(MLE)任务时,仍像是在进行一场“闭卷考试”。它们可以在单次尝试中生成代码,却无法模拟人类工程师那样,在反复的实验、调试、反馈和优化中寻找最优解的真实工作流。

Surge AI 成立于 2020 年,是一家专注于数据标注的公司。自成立以来,主创团队都极为低调,社交平台上鲜有公开动态。即便如此,Surge AI 仍在短短几年内实现了业绩大爆发,并成为业内公认的“领域最大且最好的玩家”。截至 2024 年,Surge AI 的 ARR 已突破 10 亿美元,超越了行业巨头 Scale AI 的 8.7 亿美元收入,成为其最大的竞争对手。

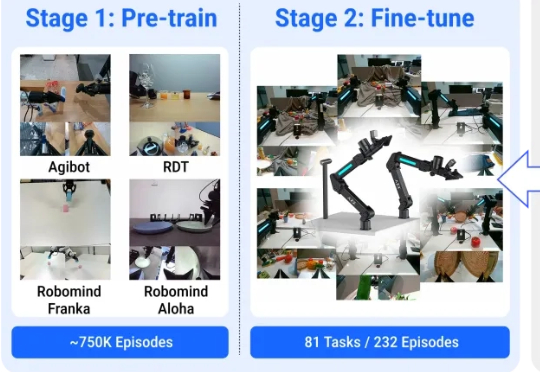

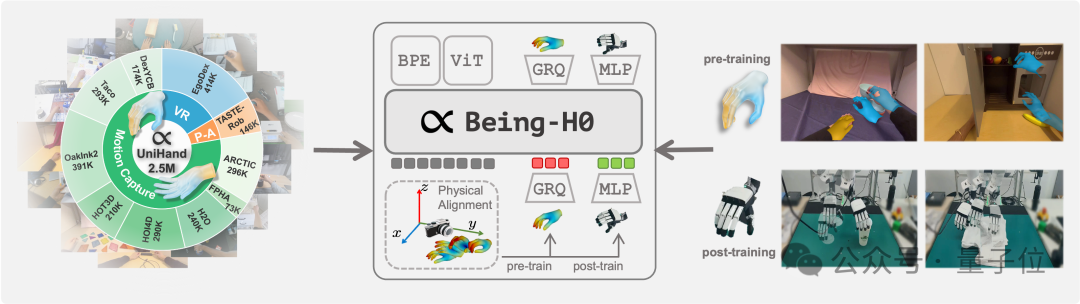

机器人能通过普通视频来学会实际物理操作了! 来看效果,对于所有没见过的物品,它能精准识别并按照指令完成动作。

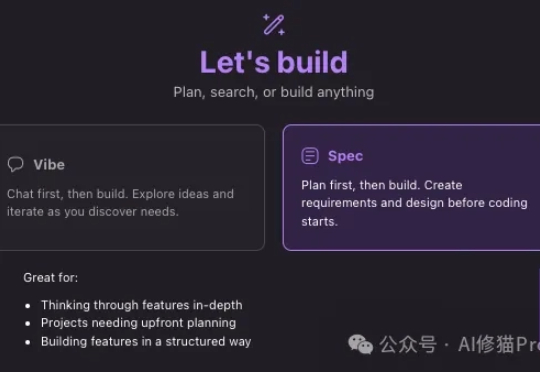

10天前Amazon发布了他们自己的开发平台,Kiro IDE,其中有一个很厉害的交互功能“Spec(Specification)”,强调的是规范的文档,说明书,以一套非常结构化的方法确保开发过程的系统性、可控性和质量,堪称现代软件工程的最佳实践。让vibe coding有一个规范的范式。

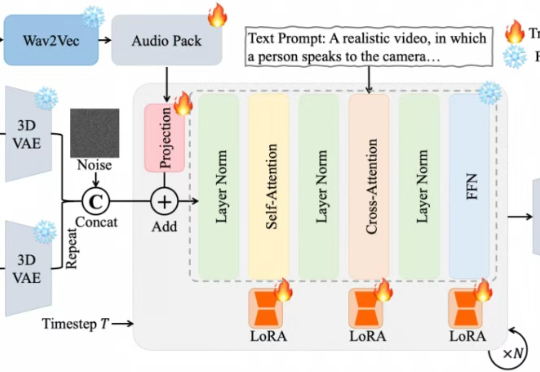

近期,夸克技术团队和浙江大学联合开源了OmniAvatar,这是一个创新的音频驱动全身视频生成模型,只需要输入一张图片和一段音频,OmniAvatar即可生成相应视频,且显著提升了画面中人物的唇形同步细节和全身动作的流畅性。此外,还可通过提示词进一步精准控制人物姿势、情绪、场景等要素。

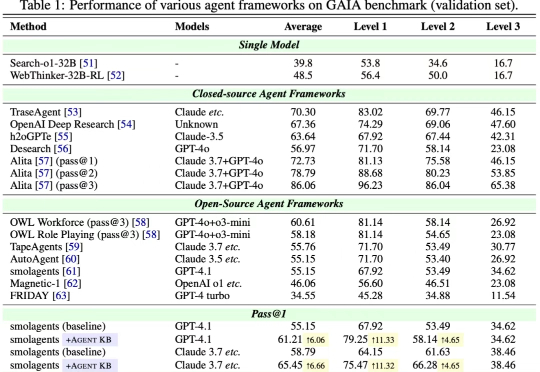

近日,来自 OPPO、耶鲁大学、斯坦福大学、威斯康星大学麦迪逊分校、北卡罗来纳大学教堂山分校等多家机构的研究团队联合发布了 Agent KB 框架。这项工作通过构建一个经验池并且通过两阶段的检索机制实现了 AI Agent 之间的有效经验共享。Agent KB 通过层级化的经验检索,让智能体能够从其他任务的成功经验中学习,显著提升了复杂推理和问题解决能力。

部分人拒绝AI,指出其训练依赖“被盗劳动力”且不道德,担心导致去技能化丧失技能和独立思维,强调人类创造力、情感体验不可替代;历史类比卢德运动表明拒绝难成功,但维护人类主体性至关重要。

就在昨天,来自UCLA的两位研究者黄溢辰和杨林做了一件让整个AI圈都震惊的事。他们用Google的Gemini 2.5 Pro模型,在2025年国际数学奥林匹克竞赛中拿下了金牌水平的成绩,6道题解对了5道。这可不是什么花架子,IMO被公认为是测试AI推理能力的终极试金石,因为它需要的不仅仅是计算,更需要创造性思维和严密的逻辑推理。

如何让机器人从看懂世界,到理解意图,再到做出动作,是具身智能领域当下最受关注的技术重点。 但真机数据的匮乏,正在使对应的视觉-语言-动作(VLA)模型面临发展瓶颈。

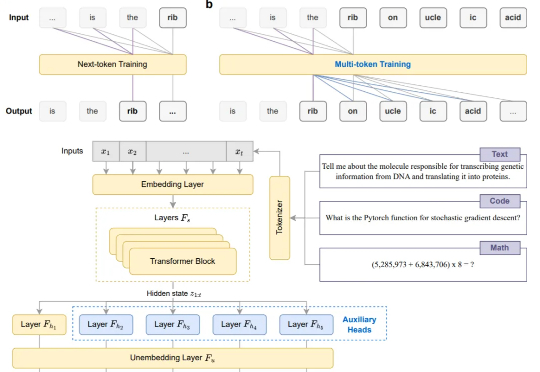

告别Next-token,现在模型微调阶段就能直接多token预测!