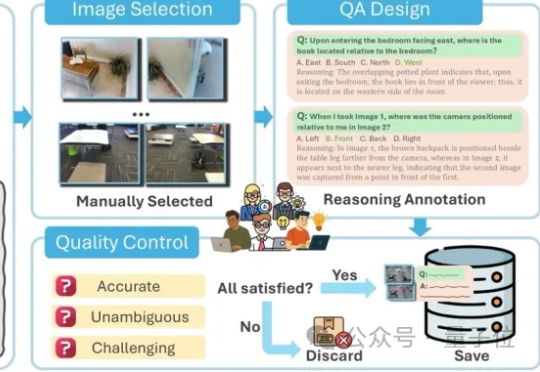

o3绞尽脑汁仅答对40%的题目,开源模型基本乱猜?MMSI-Bench:多图空间智能试金石

o3绞尽脑汁仅答对40%的题目,开源模型基本乱猜?MMSI-Bench:多图空间智能试金石AI能看图,也能讲故事,但能理解“物体在哪”“怎么动”吗? 空间智能,正是大模型走向具身智能的关键拼图。

AI能看图,也能讲故事,但能理解“物体在哪”“怎么动”吗? 空间智能,正是大模型走向具身智能的关键拼图。

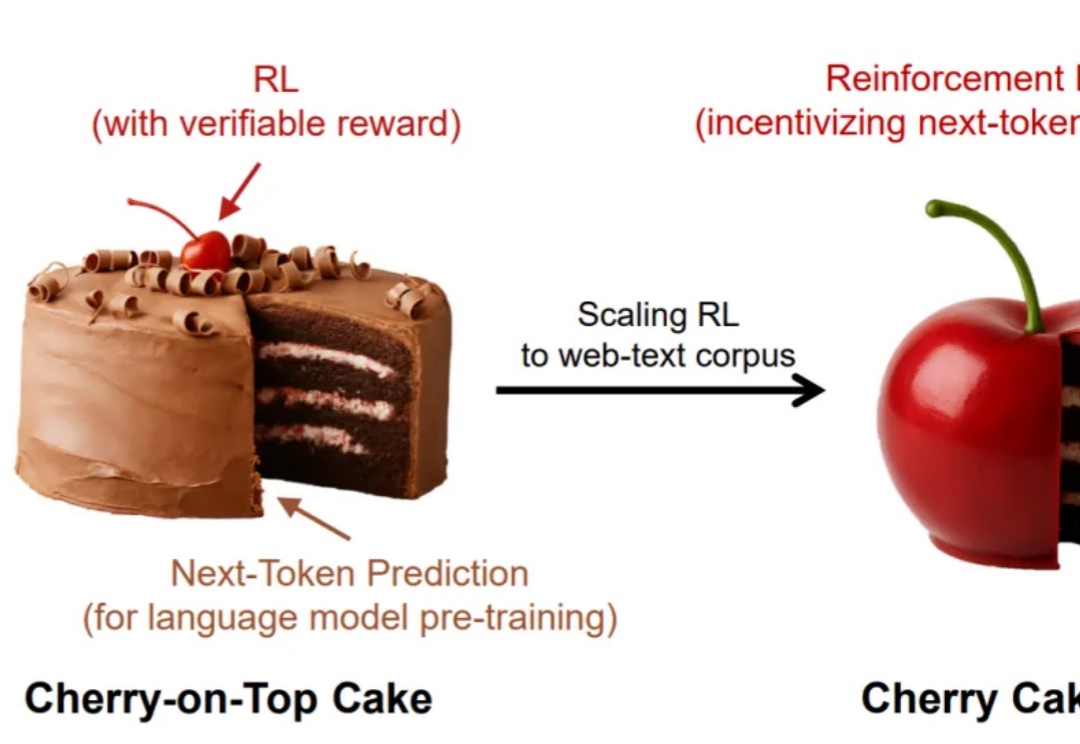

谁说强化学习只能是蛋糕上的樱桃,说不定,它也可以是整个蛋糕呢?

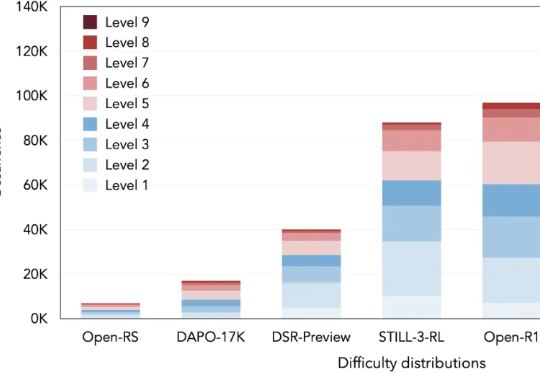

本文将介绍 DeepMath-103K 数据集。该工作由腾讯 AI Lab 与上海交通大学团队共同完成。

就在刚刚,华为首次亮相了一套“虚”的技术—— 数字化风洞,一个在正式训推复杂AI模型之前,可以在电脑中“彩排”的虚拟环境平台

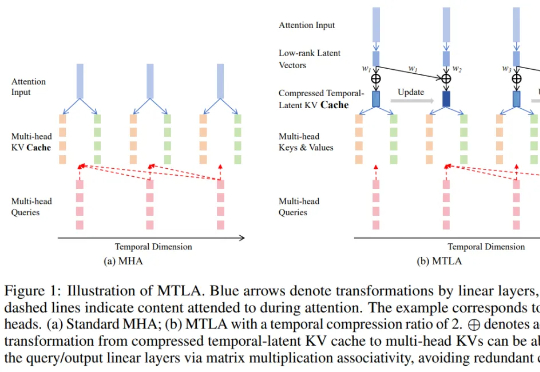

视觉注意力机制,又有新突破,来自香港大学和英伟达。

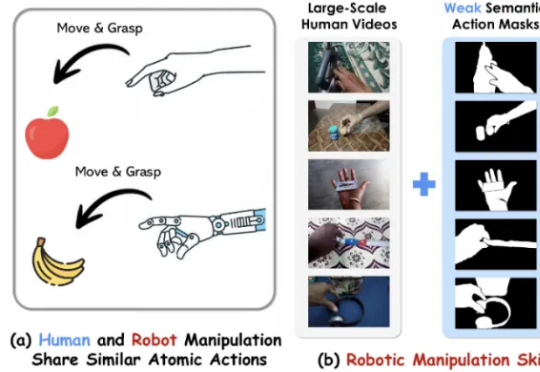

第一作者陈昌和是美国密歇根大学的研究生,师从 Nima Fazeli 教授,研究方向包括基础模型、机器人学习与具身人工智能,专注于机器人操控、物理交互与控制优化。

近年来,大语言模型(LLM)以其卓越的文本生成和逻辑推理能力,深刻改变了我们与技术的互动方式。然而,这些令人瞩目的表现背后,LLM的内部机制却像一个神秘的“黑箱”,让人难以捉摸其决策过程。

SemiAnalysis全新硬核爆料,意外揭秘了OpenAI全新模型的秘密?据悉,新模型介于GPT-4.1和GPT-4.5之间,而下一代推理模型o4将基于GPT-4.1训练,而背后最大功臣,就是强化学习。

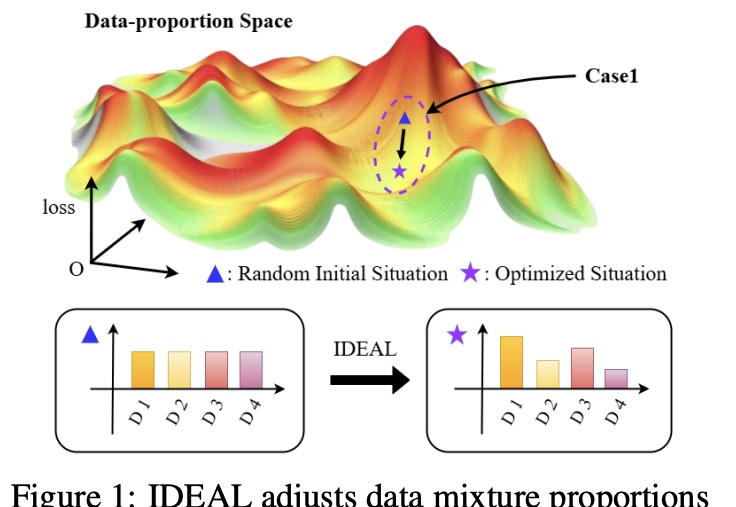

大幅缓解LLM偏科,只需调整SFT训练集的组成。

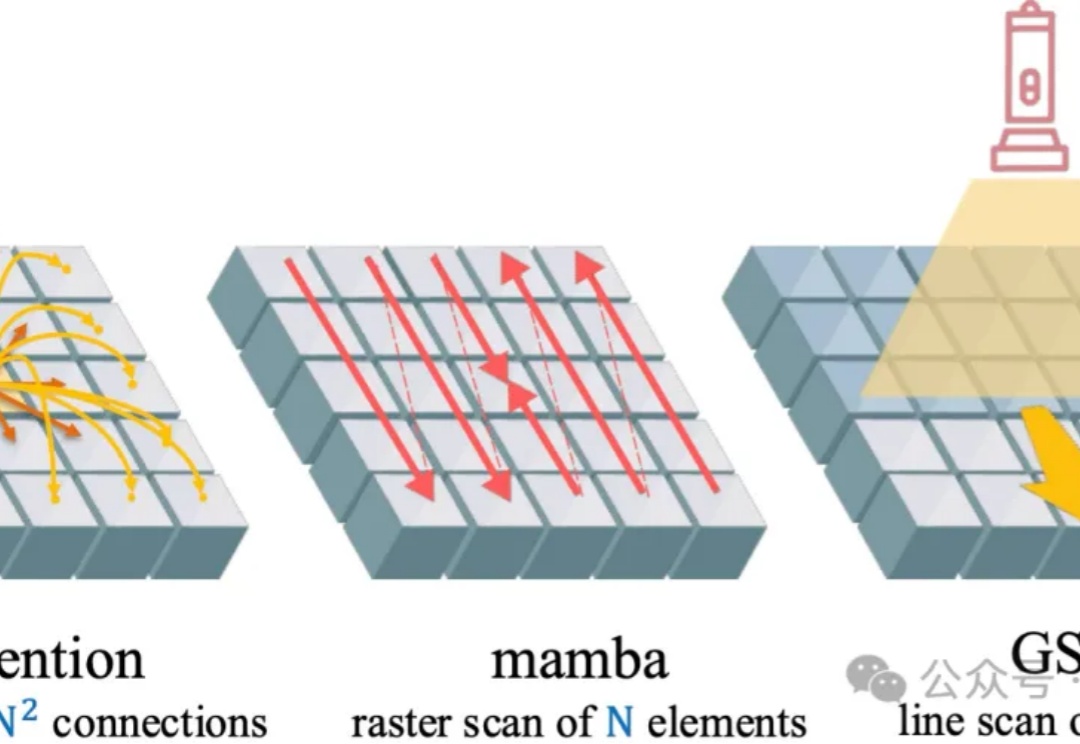

在大语言模型蓬勃发展的背景下,Transformer 架构依然是不可替代的核心组件。尽管其自注意力机制存在计算复杂度为二次方的问题,成为众多研究试图突破的重点