谷歌新发现:DeepSeek推理分裂出多重人格,左右脑互搏越来越聪明

谷歌新发现:DeepSeek推理分裂出多重人格,左右脑互搏越来越聪明AI变聪明的真相居然是正在“脑内群聊”?!

AI变聪明的真相居然是正在“脑内群聊”?!

不知道有多少人曾为了让数据图表既“好看”又“好懂”,而在设计软件与代码编辑器之间反复横跳,熬到“头秃”。

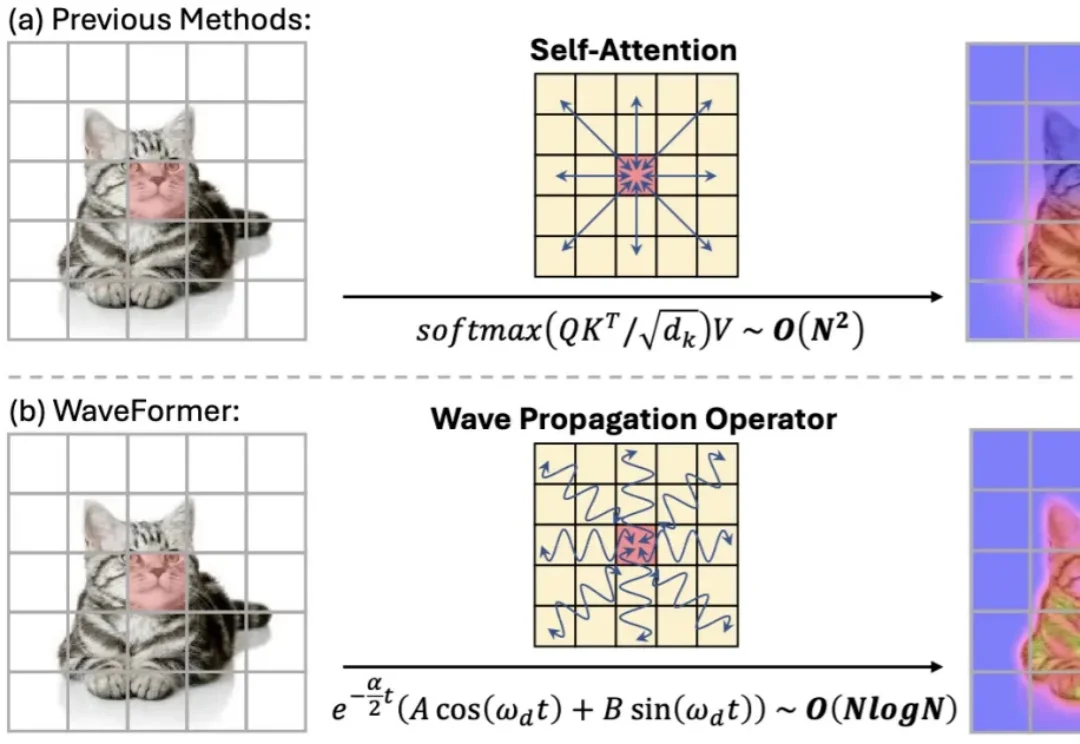

“全局交互” 几乎等同于 self-attention:每个 token 都能和所有 token 对话,效果强,但代价也直观 —— 复杂度随 token 数平方增长,分辨率一高就吃不消。现有方法大多从 “相似度匹配” 出发(attention),或从 “扩散 / 传导” 出发(热方程类方法)。但热方程本质上是一个强低通滤波器:随着传播时间增加,高频细节(边缘、纹理)会迅速消失,导致特征过平滑。

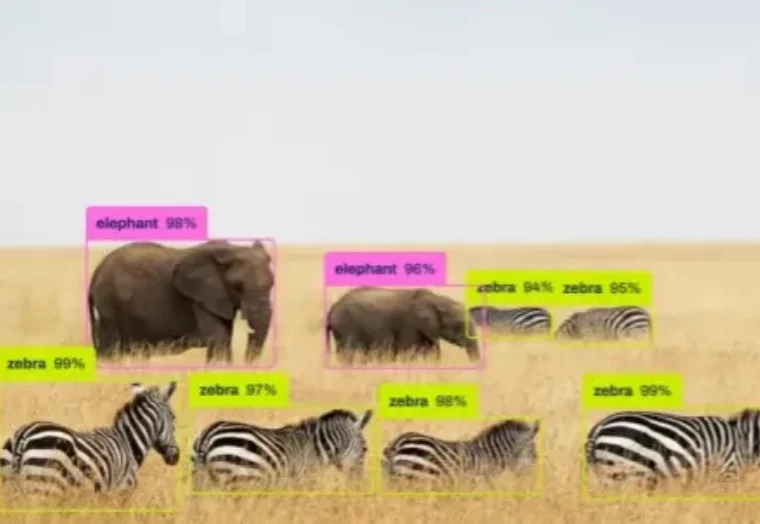

如果你最近关注了 GitHub,可能会注意到一个有趣的现象: YOLO 的版本号,直接从 11 跳到了 26。

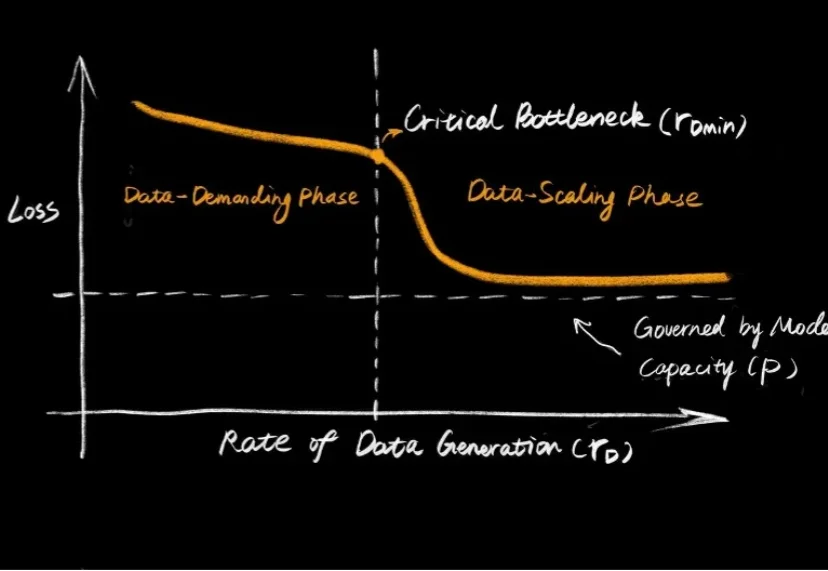

大语言模型的爆发,让大家见证了 Scaling Law 的威力:只要数据够多、算力够猛,智能似乎就会自动涌现。但在机器人领域,这个公式似乎失效了。

我们进入了一个模型不再只是“工具”的时代。真正的突破,不在于它能做多少事,而在于它是否能读懂你的意图、情绪与沉默。

不要被AI的温柔表象欺骗! Anthropic最新研究刺穿了AGI的温情假象:你以为在和良师益友倾诉,其实是在悬崖边给「杀手」松绑。 当脆弱情感遇上激活值坍塌,RLHF防御层将瞬间溃缩。既然无法教化野兽,人类只能选择最冷酷的「赛博脑叶切除术」。

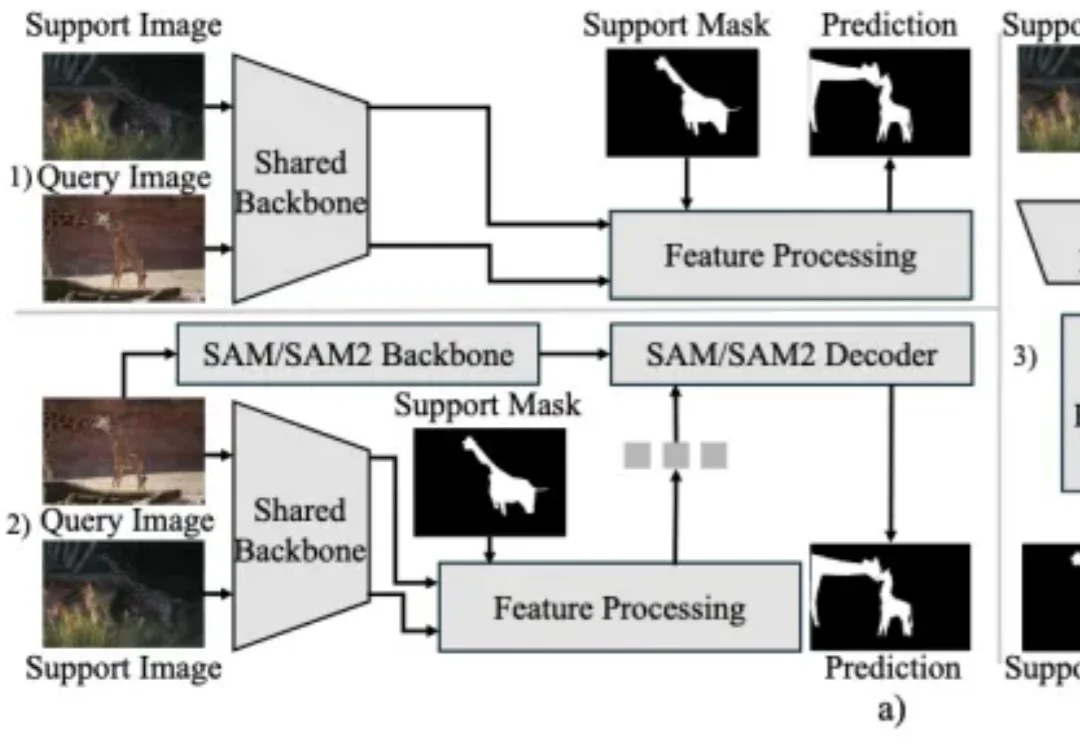

上下文分割(In-Context Segmentation)旨在通过参考示例指导模型实现对特定目标的自动化分割。尽管 SAM 凭借卓越的零样本泛化能力为此提供了强大的基础,但将其应用于此仍受限于提示(如点或框)构建,这样的需求不仅制约了批量推理的自动化效率,更使得模型在处理复杂的连续视频时,难以维持时空一致性。

最新综述首次系统探讨LLM控制机器人的安全威胁、防御机制与未来挑战,指出LLM的具身鸿沟导致其在物理空间可能执行危险动作,而现有防御体系存在逻辑与物理脱节等问题。

元旦期间,DeepSeek 发布的 mHC 震撼了整个 AI 社区。