MIT团队推出递归语言模型!不改架构、不扩窗口,上下文处理能力扩展百倍

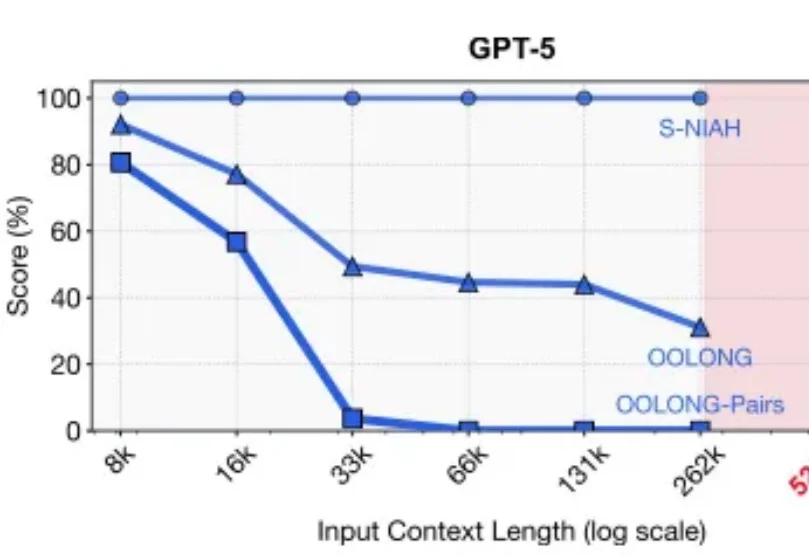

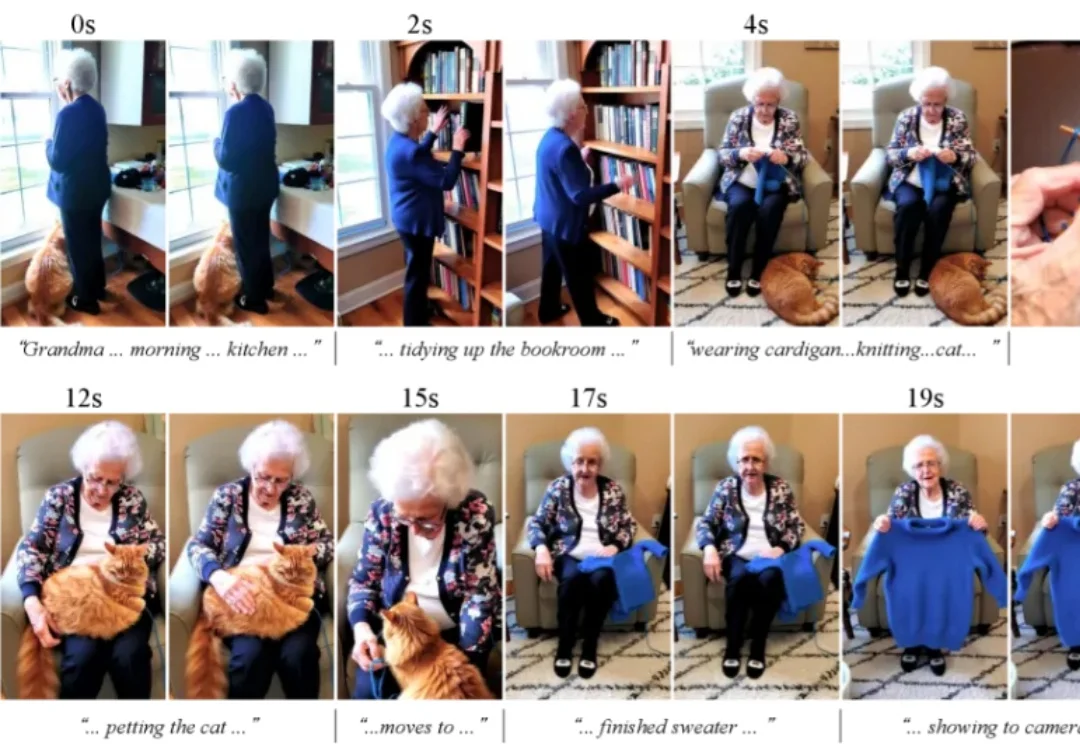

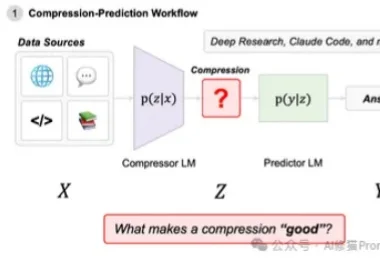

MIT团队推出递归语言模型!不改架构、不扩窗口,上下文处理能力扩展百倍新年伊始,MIT CSAIL 的一纸论文在学术圈引发了不小的讨论。Alex L. Zhang 、 Tim Kraska 与 Omar Khattab 三位研究者在 arXiv 上发布了一篇题为《Recursive Language Models》的论文,提出了所谓“递归语言模型”(Recursive Language Models,简称 RLM)的推理策略。