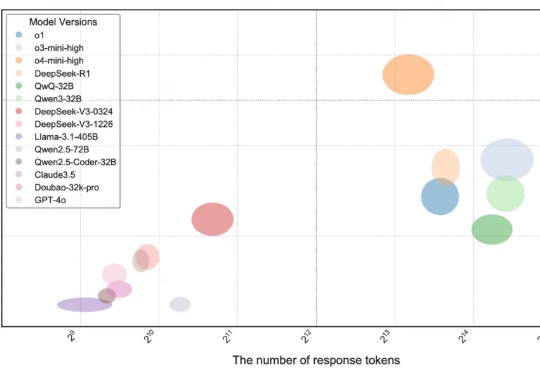

打破大模型编程「数据污染」与「能力虚胖」困境,Meituan-M17团队构建新一代AI编程评测新标准——OIBench

打破大模型编程「数据污染」与「能力虚胖」困境,Meituan-M17团队构建新一代AI编程评测新标准——OIBench当前,大语言模型(LLMs)在编程领域的能力受到广泛关注,相关论断在市场中普遍存在,例如 DeepMind 的 AlphaCode 曾宣称达到人类竞技编程选手的水平

当前,大语言模型(LLMs)在编程领域的能力受到广泛关注,相关论断在市场中普遍存在,例如 DeepMind 的 AlphaCode 曾宣称达到人类竞技编程选手的水平

谁说扩散模型只能生成图像和视频?现在它们能高质量地写代码了,速度还比传统大模型更快!Inception Labs推出基于扩散技术的全新商业级大语言模型——Mercury。

MoCa框架把单向视觉语言模型转化为双向多模态嵌入模型,通过持续预训练和异构对比微调,提升模型性能和泛化能力,在多模态基准测试中表现优异,尤其小规模模型性能突出。

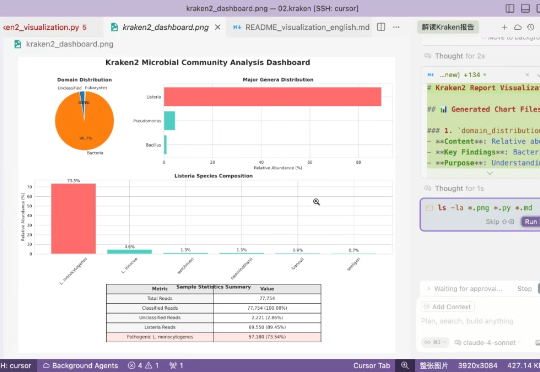

最近一直在测试大模型来做生物信息,效果还可以,主要使用gemini cli,由于一直还有机会用上claude code,所以只能通过cursor来使用claude 4,这次内容我们来测试一下claud4的生物信息能力。

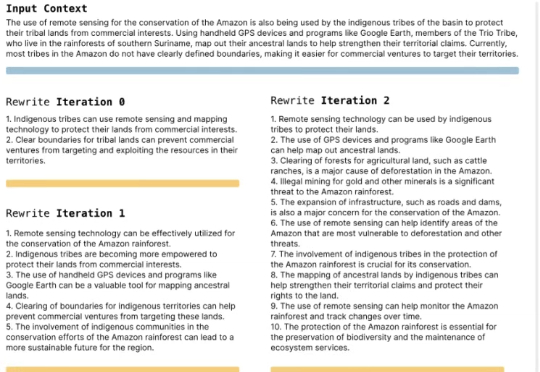

自适应语言模型框架SEAL,让大模型通过生成自己的微调数据和更新指令来适应新任务。SEAL在少样本学习和知识整合任务上表现优异,显著提升了模型的适应性和性能,为大模型的自主学习和优化提供了新的思路。

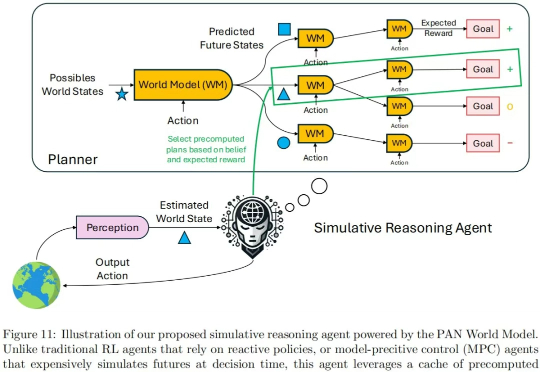

现在的世界模型,值得批判。 我们知道,大语言模型(LLM)是通过预测对话的下一个单词的形式产生输出的。由此产生的对话、推理甚至创作能力已经接近人类智力水平。

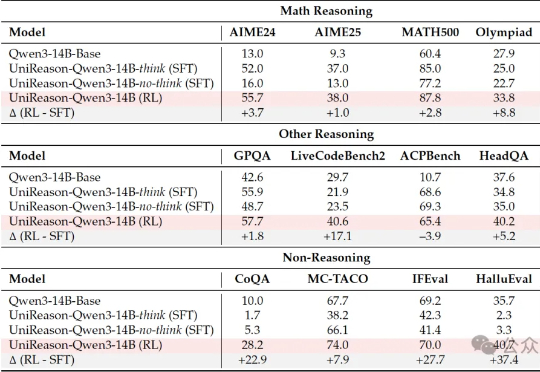

学好数理化,走遍天下都不怕! 这一点这在大语言模型身上也不例外。

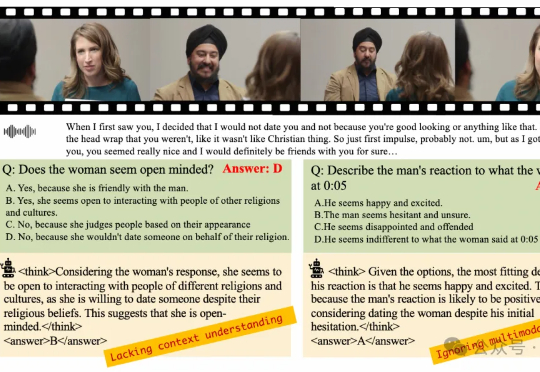

在多模态大语言模型(MLLMs)应用日益多元化的今天,对模型深度理解和分析人类意图的需求愈发迫切。尽管强化学习(RL)在增强大语言模型(LLMs)的推理能力方面已展现出巨大潜力,但将其有效应用于复杂的多模态数据和格式仍面临诸多挑战。

蛋白质之后,DNA正成为AI+生命科学的下一个热门领域。

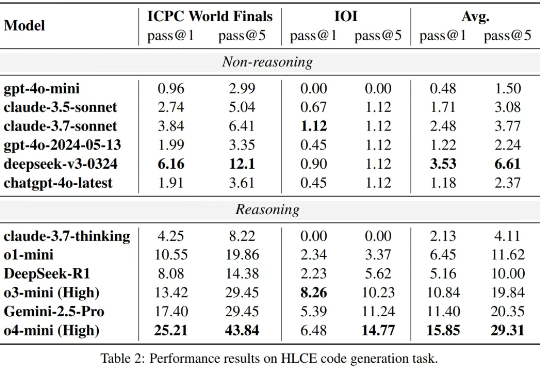

大语言模型(LLM)在标准编程基准测试(如 HumanEval,Livecodebench)上已经接近 “毕业”,但这是否意味着它们已经掌握了人类顶尖水平的复杂推理和编程能力?