谢赛宁团队新作:不用提示词精准实现3D画面控制

谢赛宁团队新作:不用提示词精准实现3D画面控制曾几何时,用文字生成图像已经变得像用笔作画一样稀松平常。

曾几何时,用文字生成图像已经变得像用笔作画一样稀松平常。

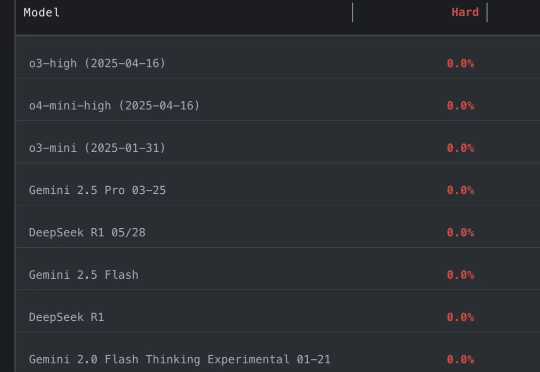

好夸张…… 参赛大模型全军覆没,通通0分。 谢赛宁等人出题,直接把o3、Gemini-2.5-pro、Claude-3.7、DeepSeek-R1一众模型全都难倒。

凌晨三点的 AI 实验室,键盘敲击声在空荡的房间回响。屏幕上,博士生小王、小李、小赵正疯狂调整模型参数,只为在 NeurIPS 截稿前将准确率从 98.2% 刷到 98.5%。

统一图像理解和生成,还实现了新SOTA。

谢赛宁十年前被NeurIPS(当时还叫NIPS)拒收的论文,刚在今年获得了AISTATS 2025年度时间检验奖。

o3和o4-mini视觉推理突破,竟未引用他人成果?一名华盛顿大学博士生发出质疑,OpenAI研究人员对此回应:不存在。

来自Meta和NYU的团队,刚刚提出了一种MetaQuery新方法,让多模态模型瞬间解锁多模态生成能力!令人惊讶的是,这种方法竟然如此简单,就实现了曾被认为需要MLLM微调才能具备的能力。

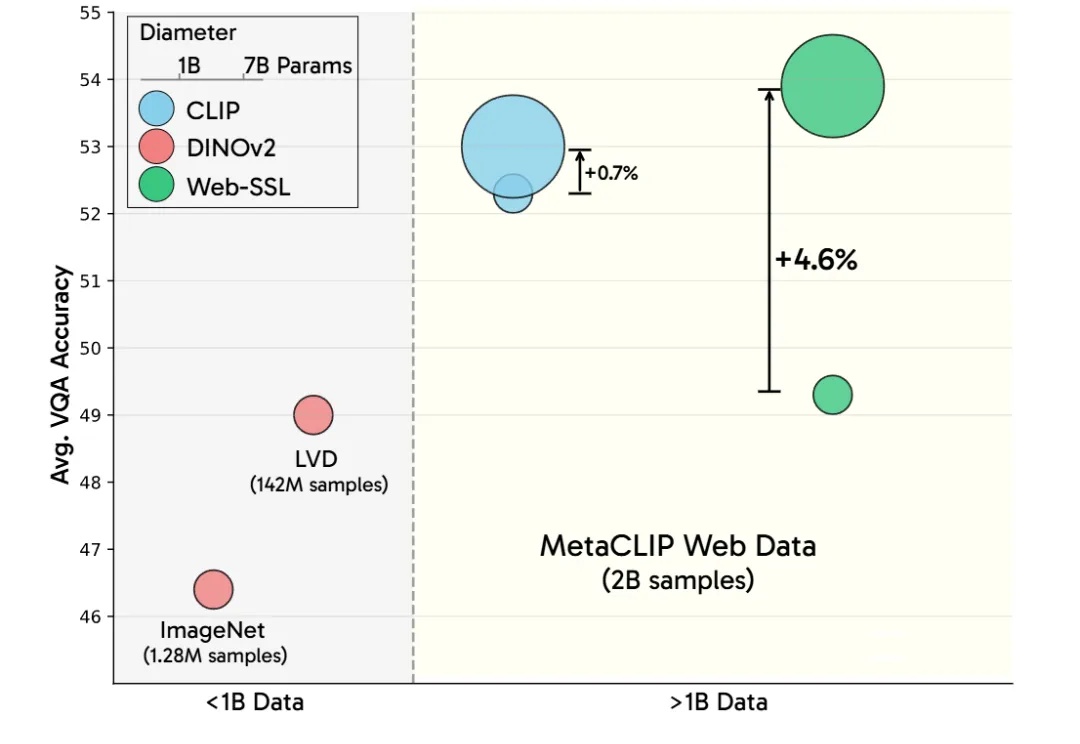

LeCun谢赛宁等研究人员通过新模型Web-SSL验证了SSL在多模态任务中的潜力,证明其在扩展模型和数据规模后,能媲美甚至超越CLIP。这项研究为无语言监督的视觉预训练开辟新方向,并计划开源模型以推动社区探索。

扩展无语言的视觉表征学习。

近年来,多模态大模型(MLLM)在视觉理解领域突飞猛进,但如何让大语言模型(LLM)低成本掌握视觉生成能力仍是业界难题!