AI时代还用德尔菲法?其实“少数人”远比“多数人”更有价值 |谷歌最新

AI时代还用德尔菲法?其实“少数人”远比“多数人”更有价值 |谷歌最新每当需要处理复杂领域中高度不确定性或缺乏历史数据的问题时,纯粹的科学证据不足、存在矛盾或过于复杂,通常我们就需要依赖专家们的集体智慧来形成共识,指导实践。德尔菲法(Delphi method)是半个多世纪以来最常用的一种专家共识方法。

每当需要处理复杂领域中高度不确定性或缺乏历史数据的问题时,纯粹的科学证据不足、存在矛盾或过于复杂,通常我们就需要依赖专家们的集体智慧来形成共识,指导实践。德尔菲法(Delphi method)是半个多世纪以来最常用的一种专家共识方法。

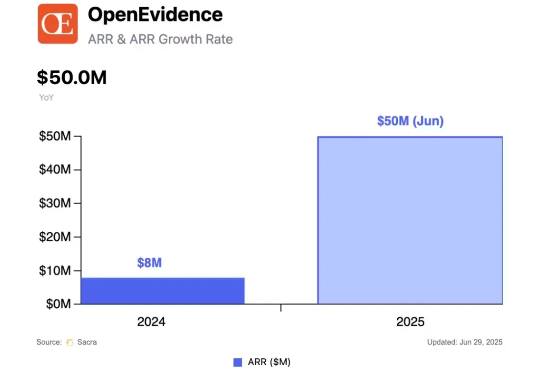

首个满分选手的出现,标志着AI医疗的又一个里程碑。 近日,美国初创公司OpenEvidence宣布,其开发的全新AI系统在美国医师执照考试(USMLE)中获得了100%的满分。

不久之后,我们阅读的各种新闻网站的首页,也许都是AI编排的。 8月12日,以AI搜索为主赛道的公司Perplexity,提出以345亿美元收购谷歌Chrome浏览器。这一数字甚至高于Perplexity目前180亿美元的估值。

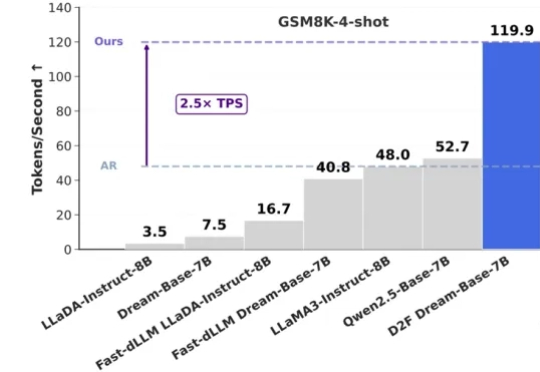

在大语言模型(LLMs)领域,自回归(AR)范式长期占据主导地位,但其逐 token 生成也带来了固有的推理效率瓶颈。此前,谷歌的 Gemini Diffusion 和字节的 Seed Diffusion 以每秒千余 Tokens 的惊人吞吐量,向业界展现了扩散大语言模型(dLLMs)在推理速度上的巨大潜力。

Genie 3来了!这或许是最接近「模拟世界」的AI魔法。只需一句话,它就能生成一个动态、可互动的世界——角色能互动、下水会溅起水花,甚至还能记住一分钟前的细节。DeepMind研究者直言:Genie 3是通向AGI的关键一步。

谷歌官宣! Gemini 8月新功能和最新更新出炉,专为学生打造。这次目标为什么选择学生,这背后却是一场深思熟虑的「阳谋」。谷歌这盘「从校园包围社会」的大旗,你看懂了吗?

8 月 13 日,Google I/O Connect China 2025——Google 开发者大会在上海拉开帷幕。来自 Google 全球不同领域的专家,为中国出海开发者们带来 AI 驱动下的前沿技术、创新开发工具以及全球化平台的最新动态。

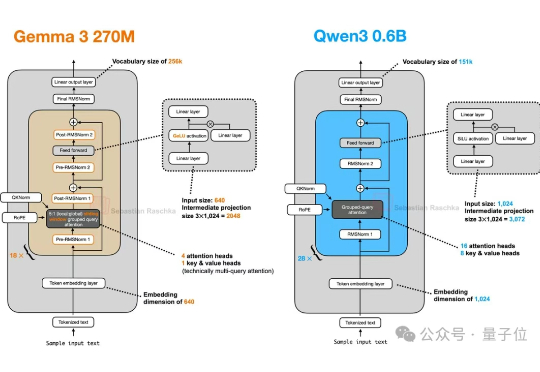

谷歌开源Gemma 3 270M闪亮登场!只需几分钟即可完成微调,指令遵循和文本结构化能力更是惊艳,性能超越Qwen 2.5同级模型。

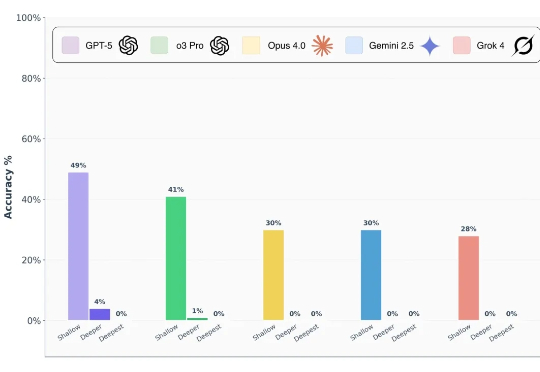

前沿 AI 模型真的能做到博士级推理吗? 前段时间,谷歌、OpenAI 的模型都在数学奥林匹克(IMO)水平测试中达到了金牌水准,这样的表现让人很容易联想到 LLM 是不是已经具备了解决博士级科研难题的推理能力?

8月6日,谷歌正式发布编程智能体Jules,摘掉了「测试版」标签。Jules具备异步执行能力,依托Gemini2.5Pro模型,可独立修复Bug、更新代码并深度集成GitHub,大幅提升开发效率。