4B小模型掀翻大模型牌桌!性能超GPT-3.5,无限长文本性能超Kimi...

4B小模型掀翻大模型牌桌!性能超GPT-3.5,无限长文本性能超Kimi...你敢相信 4B 参数小模型,性能却超越千亿量级的 GPT-3.5 !OpenAI、谷歌、微软、苹果等一众海内外巨头还没做到的事,被一家中国大模型公司抢先了!

你敢相信 4B 参数小模型,性能却超越千亿量级的 GPT-3.5 !OpenAI、谷歌、微软、苹果等一众海内外巨头还没做到的事,被一家中国大模型公司抢先了!

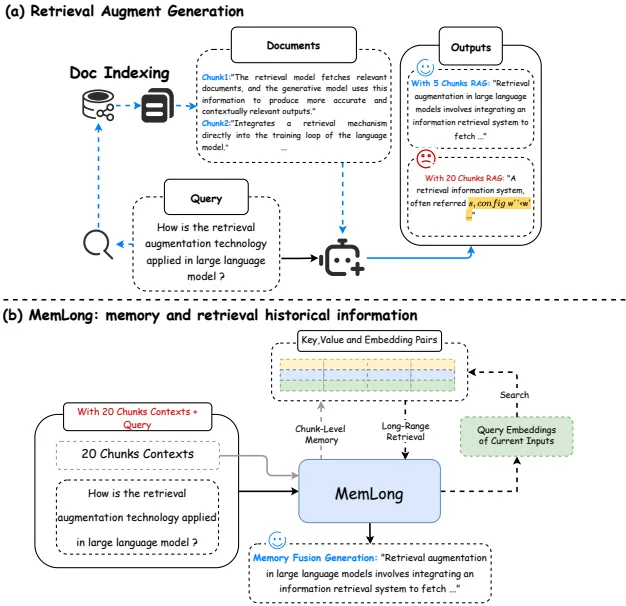

这篇文章介绍了一个名为MemLong的模型,它通过使用外部检索器来增强长文本建模的能力。

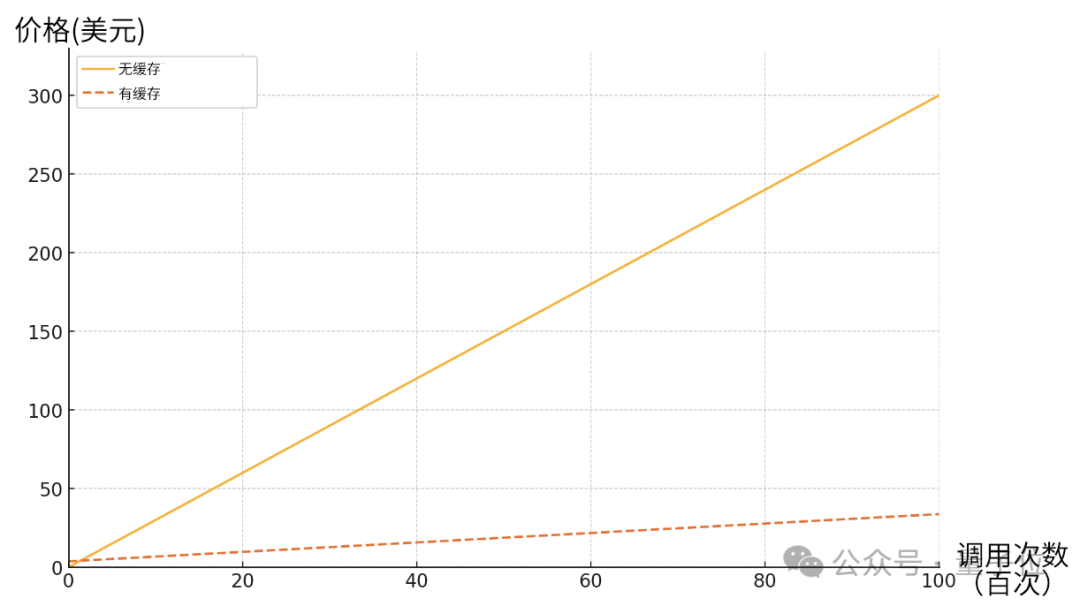

Claude深夜上新重磅功能——API长文本缓存。

最近各家模型发的都挺勤,一会一个 SOTA,一会一个遥遥领先。

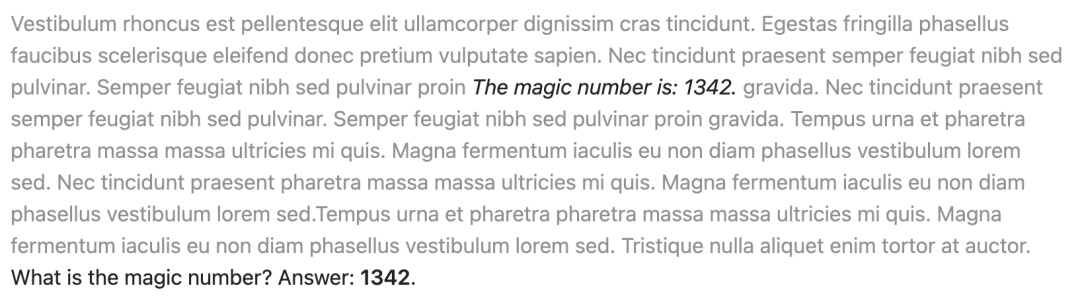

长文本处理能力对LLM的重要性是显而易见的。在2023年初,即便是当时最先进的GPT-3.5,其上下文长度也仅限于2k,然而今日,128k的上下文长度已经成为衡量模型技术先进性的重要标志之一。那你知道LLMs的长文本阅读能力如何评估吗?

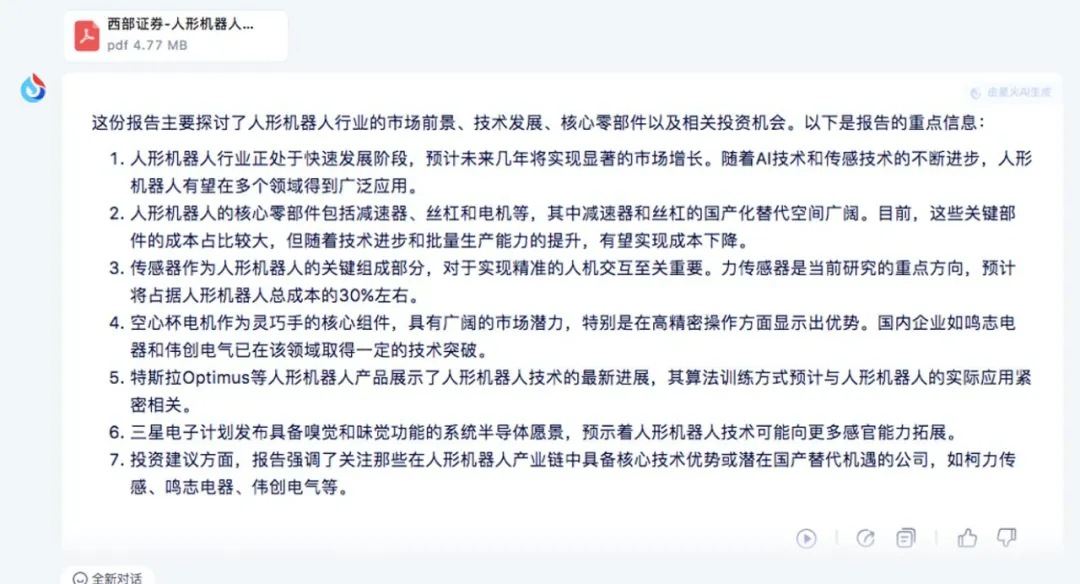

关于长文本和 RAG 到底如何选择,一直有争论,从基模公司到应用开发者。 今天这篇文章,是来自基模公司月之暗面和中间层 Zilliz 的技术对话,值得一看。

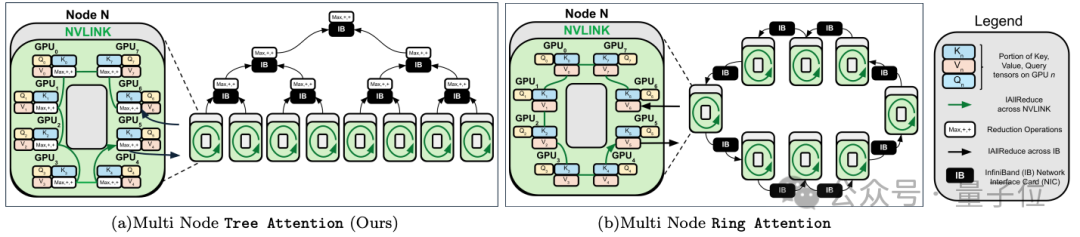

跨GPU的注意力并行,最高提速8倍,支持512万序列长度推理。

在长文本理解能力这块,竟然没有一个大模型及格!

大型语言模型(LLM)往往会追求更长的「上下文窗口」,但由于微调成本高、长文本稀缺以及新token位置引入的灾难值(catastrophic values)等问题,目前模型的上下文窗口大多不超过128k个token

4 月 26 日,科大讯飞发布讯飞星火大模型 V3.5 的功能上新,其中一个重点就是面向用户各种场景中高效获取信息需求,发布首个长文本、长图文、长语音的大模型,能够支持文档、图文资料、会议录音等各种信息来源的快速理解和学习,还能够结合各种行业场景知识给出专业、准确回答。