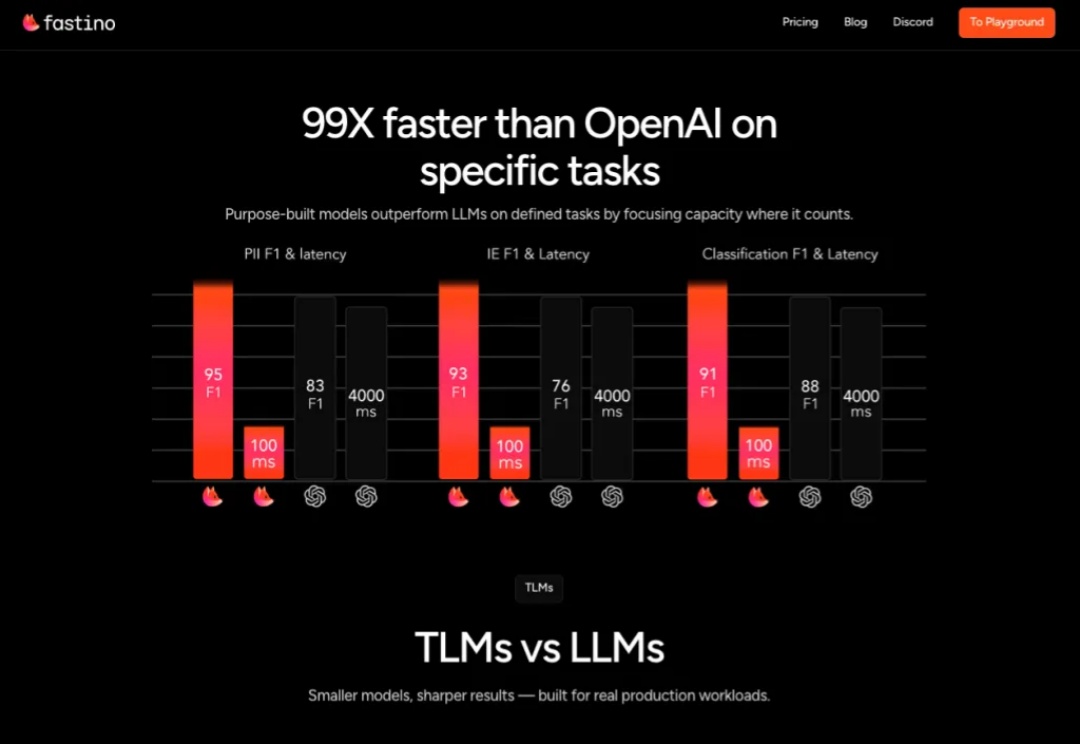

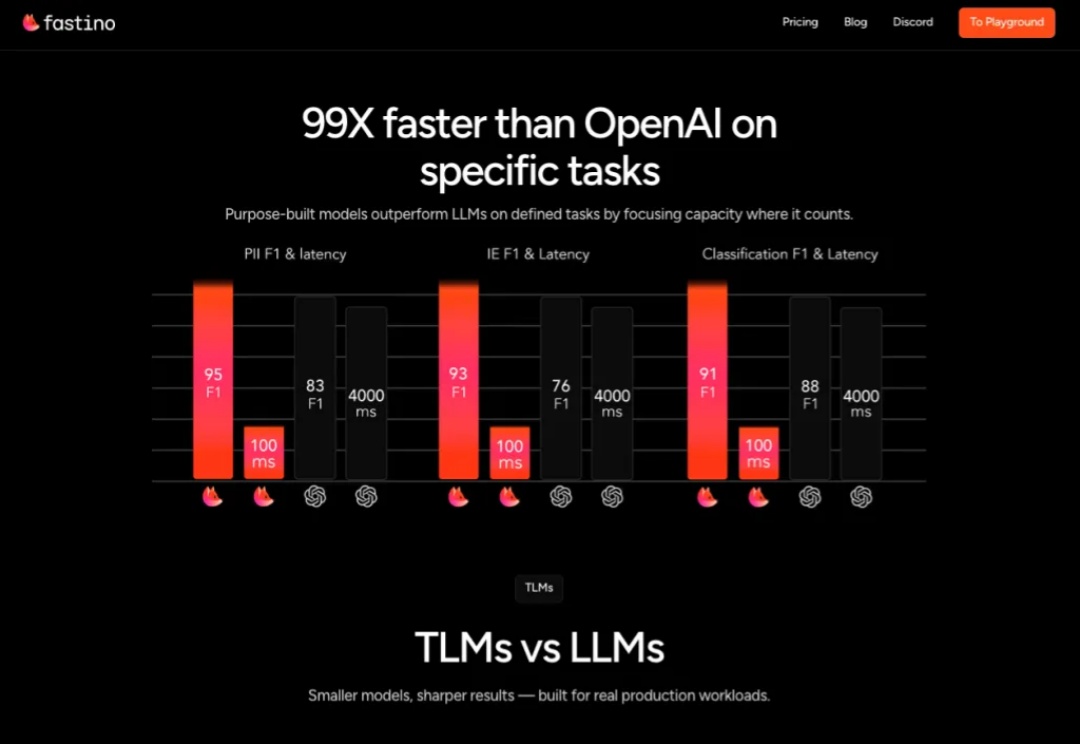

速递|OpenAI首投机构再出手!Khosla1750万美元押注“轻量化AI”Fastino,AI训练平民化

速递|OpenAI首投机构再出手!Khosla1750万美元押注“轻量化AI”Fastino,AI训练平民化科技巨头常吹嘘需要庞大昂贵GPU 集群的万亿参数 AI 模型,但 Fastino 正采取截然不同的策略

科技巨头常吹嘘需要庞大昂贵GPU 集群的万亿参数 AI 模型,但 Fastino 正采取截然不同的策略

昨日,北京市知识产权局党组成员、副局长潘新胜在参加百度活动时表示,北京正在全力推进建设具有全球影响力的人工智能创新策源地和产业高地,打造世界级人工智能产业集群。

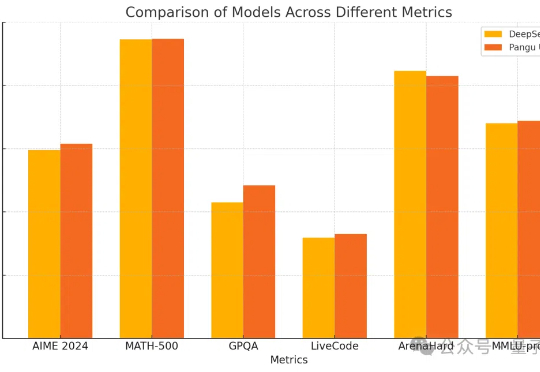

密集模型的推理能力也能和DeepSeek-R1掰手腕了?

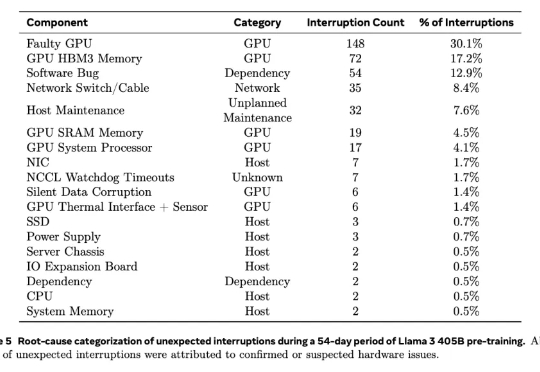

根据去年2024年7月28日Meta公司在训练大模型(Llama 3)时使用“16384 个 英伟达H100 GPU 集群”的经验,该显卡在高负载、大规模集群运行环境下容易出现以下故障点:

文本到图像(Text-to-Image, T2I)生成任务近年来取得了飞速进展,其中以扩散模型(如 Stable Diffusion、DiT 等)和自回归(AR)模型为代表的方法取得了显著成果。然而,这些主流的生成模型通常依赖于超大规模的数据集和巨大的参数量,导致计算成本高昂、落地困难,难以高效地应用于实际生产环境。

再次证明,AI行业里大力出奇迹。

当我们惊叹于Deepseek的妙语连珠时,是否正目睹硅基系统对人类语言本源的复刻?那在服务器集群中奔流的矩阵运算,与人脑皮层间跳跃的神经电波,究竟共享着怎样的“语言密码”?

国内首个自研万卡集群,刚刚成功点亮!国产AI的高价门槛直接被打下来了。在百度智能云平台上,DeepSeek R1和V3的官方价格直接低至五折和三折,基本实现全网最低。

GPU万卡集群,小米下场了!摩尔线程智算集群扩展至万卡!中国移动将商用三个自主可控万卡集群......一系列标题的袭来,让笔者突然意识到,仿佛在不经意间,智能算力建设已然迈入万卡时代。

大模型浪潮下,AI与其背后的通信网络存在密不可分的联系,可以总结为Network for AI和AI for Network两层关系—— 我们用网络加速AI训练推理,通过AI手段让网络变得更加安全可靠。