腾讯混元大模型负责人王迪:揭秘万亿 MoE 系统工程之道|智者访谈

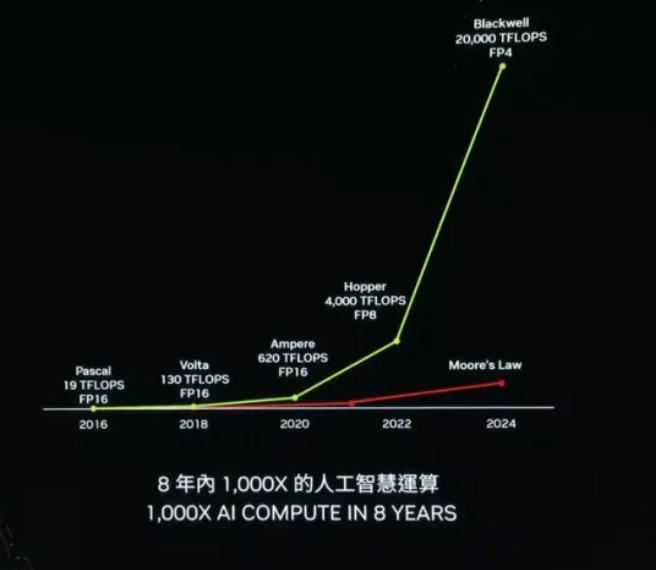

腾讯混元大模型负责人王迪:揭秘万亿 MoE 系统工程之道|智者访谈人工智能正经历一场由大模型引发的革命。这些拥有数十亿甚至万亿参数的庞然大物,正在重塑我们对 AI 能力的认知,也构筑起充满挑战与机遇的技术迷宫——从计算集群高速互联网络的搭建,到训练过程中模型稳定性和鲁棒性的提升,再到探索更快更优的压缩与加速方法,每一步都是对创新者的考验。

人工智能正经历一场由大模型引发的革命。这些拥有数十亿甚至万亿参数的庞然大物,正在重塑我们对 AI 能力的认知,也构筑起充满挑战与机遇的技术迷宫——从计算集群高速互联网络的搭建,到训练过程中模型稳定性和鲁棒性的提升,再到探索更快更优的压缩与加速方法,每一步都是对创新者的考验。

2024年上海的7月是一个沉闷的雨季,但对国产AI 行业来说,却迎来了堪比摇滚乐集会的WAIC(世界人工智能大会)。

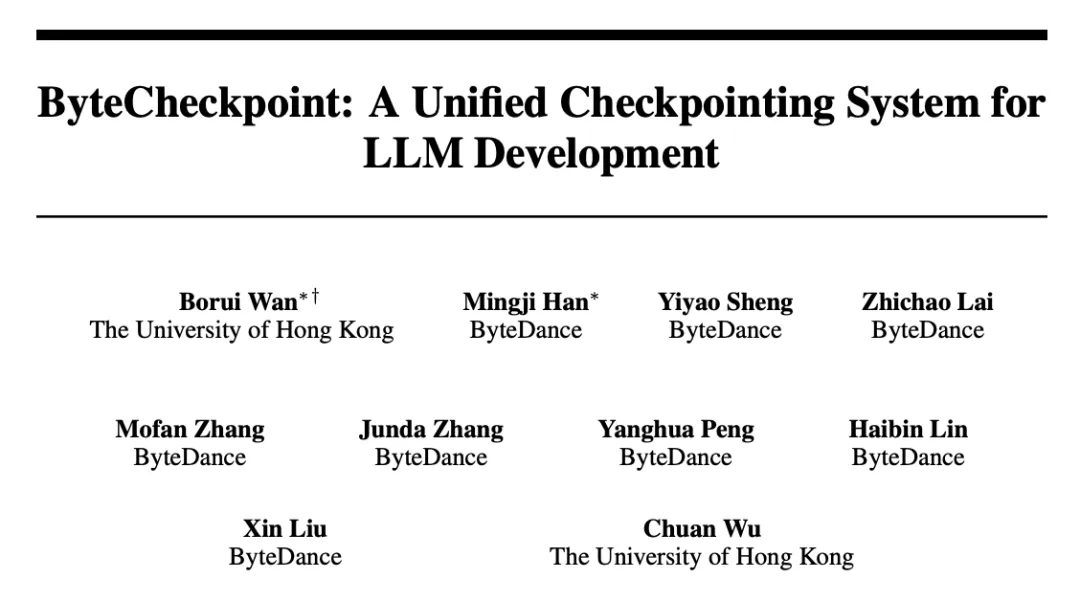

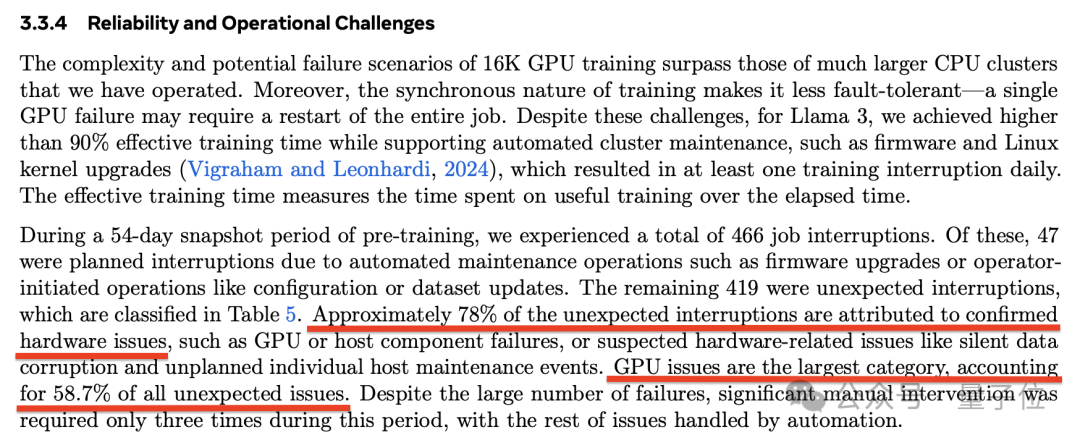

伴随大模型迭代速度越来越快,训练集群规模越来越大,高频率的软硬件故障已经成为阻碍训练效率进一步提高的痛点,检查点(Checkpoint)系统在训练过程中负责状态的存储和恢复,已经成为克服训练故障、保障训练进度和提高训练效率的关键。

是时候用CPU通用服务器跑千亿参数大模型了!

埃隆·马斯克掌控的那几家公司——包括SpaceX、特斯拉、xAI乃至X(原Twitter)——都需要大量的GPU,而且也都是为自己的特定AI或者高性能计算(HPC)项目服务。

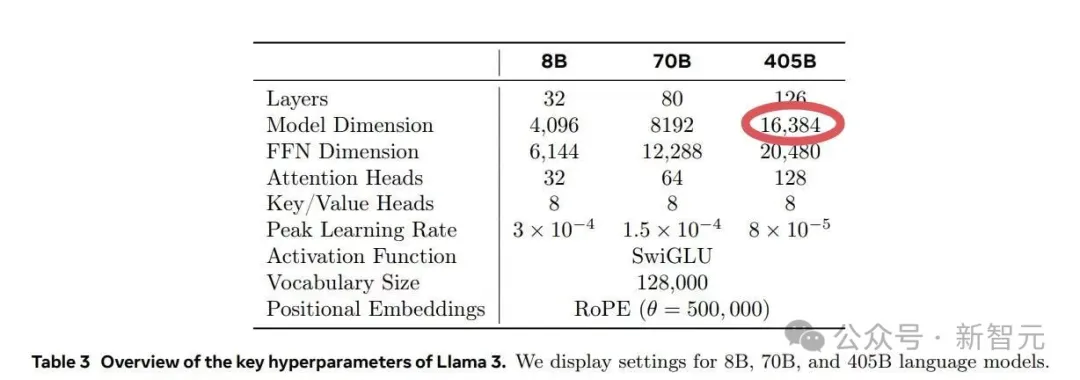

在Meta的Llama 3.1训练过程中,其运行的1.6万个GPU训练集群每3小时就会出现一次故障,意外故障中的半数都是由英伟达H100 GPU和HBM3内存故障造成的。

每3个小时1次、平均1天8次,Llama 3.1 405B预训练老出故障,H100是罪魁祸首?

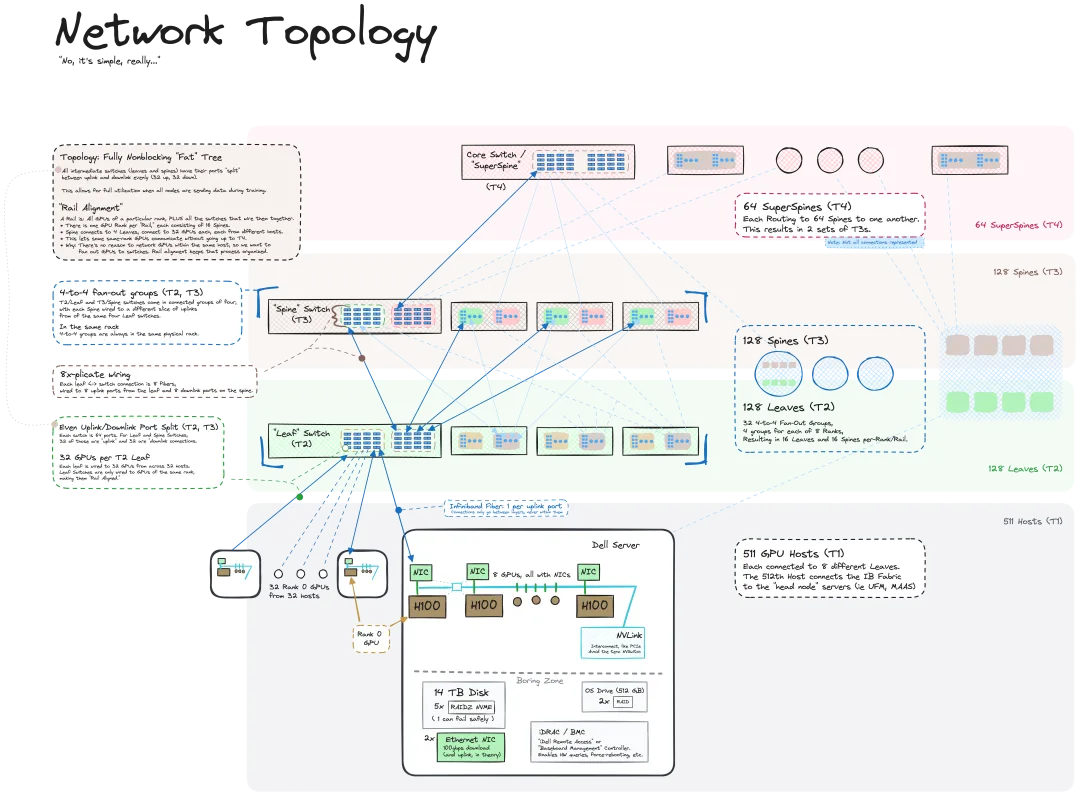

我们知道 LLM 是在大规模计算机集群上使用海量数据训练得到的,机器之心曾介绍过不少用于辅助和改进 LLM 训练流程的方法和技术。而今天,我们要分享的是一篇深入技术底层的文章,介绍如何将一堆连操作系统也没有的「裸机」变成用于训练 LLM 的计算机集群。

世界最强AI集群,马斯克建成了! 这一爆炸消息,由老马在推特上亲自官宣。

10万块液冷H100正式开工,马斯克19天建成世界最强AI训练集群。