2025年5月,谷歌在其年度开发者大会 Google I/O 期间宣布推出 MedGemma,专为医疗领域打造的开源 AI 模型。

MedGemma是谷歌 “健康人工智能开发者基础”(Health AI Developer Foundations)计划的核心项目。

基于 Gemma 3 架构, MedGemma提供多模态和纯文本两种模型变体,旨在降低医疗 AI 开发门槛。

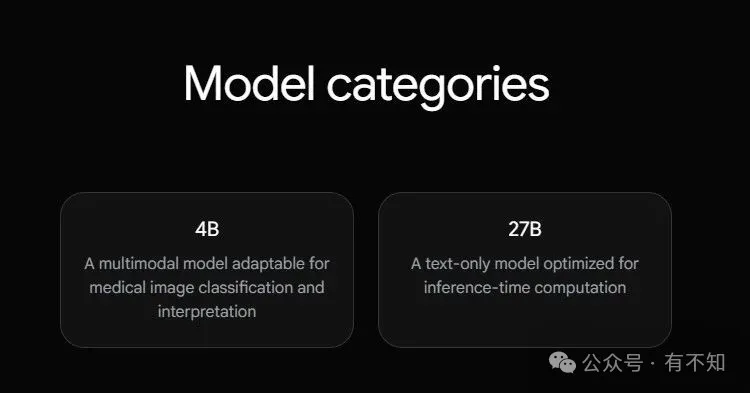

MedGemma有两个版本:40 亿参数的多模态模型和 270 亿参数的纯文本模型。

MedGemma 4B

一个包含 40 亿参数的多模态模型,能够同时处理医学图像和文本。

采用在去标识化医学数据集(包括胸部 X 光片、皮肤科图像、眼科图像和组织病理学切片)上预训练的 SigLIP 图像编码器。

语言模型组件在多样化医疗数据上进行训练,以促进全面理解。

MedGemma 27B

一个包含 270 亿参数的纯文本模型,针对需要深度医学文本理解和临床推理的任务场景。

该版本仅能通过指令调优。

1. 高效性:模型轻量化,适合在资源受限环境中运行。

2. 领域专精:针对医学领域的专业术语、上下文和复杂推理进行了优化。

3. 开源:代码和模型权重公开,鼓励社区贡献和透明性。

4. 多场景支持:适用于医疗文本生成、问答、分类和知识提取等。

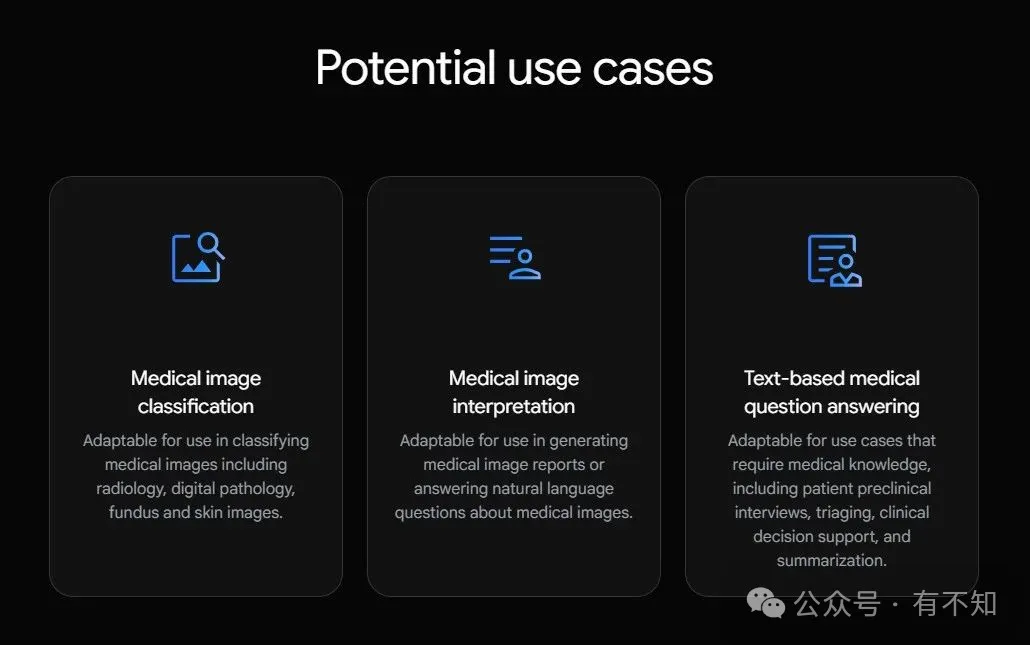

1. 医学图像分类:

使用 MedGemma 4B 对医学图像进行分类,包括放射学(如胸部 X 光片)、数字病理学、眼底和皮肤图像。

2. 医学图像解释:

使用 MedGemma 4B 生成医学图像报告或回答自然语言问题(如“这个 X 光片显示了什么?”)。

需注意,该功能尚未达到临床级别,需要进一步微调。

3. 医学文本理解和临床推理:

使用 MedGemma 27B(或 MedGemma 4B)进行文本理解和临床推理任务,包括:

患者访谈:帮助医生进行患者预临床访谈。

分诊:根据患者症状进行初步分诊。

临床决策支持:提供基于医学知识的决策建议。

总结:生成患者病历或临床报告的摘要。

谷歌称,相对于其他类似规模的模型,这两种模型都显示出强大的基线性能。

然而,这家科技巨头表示,这些模型并非临床级别的,仅用于研究和开发。

开发人员需要针对其特定应用场景验证性能,并在部署前进行相应微调。

开发人员可以使用不同的方法来调整模型,例如优化输入到系统中的提示词、进一步训练模型或将其与其他工具结合使用。

到目前为止,MedGemma 主要在单图像任务上进行了测试,尚未对分析多幅图像或处理较长时间的来回交互进行评估。

官网地址:https://deepmind.google/models/gemma/

Huggingface:https://huggingface.co/collections/google/medgemma-release-680aade845f90bec6a3f60c4

文章来自微信公众号 “ 有不知 “,作者 吴之猫

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0