比Nano Banana更擅长P细节的图像编辑模型来了,还是更懂中文的那种。

就像这样,要求AI“把中间白色衣服戴口罩女生的手势改成OK”,原图如下:

这个名为UniWorld-V2的模型能做到完美修改。

而Nano Banana则未能成功get到提示词的意图。

模型背后,是兔展智能&北京大学的UniWorld团队的最新技术成果:

他们提出了一种名为UniWorld-R1的创新型图像编辑后期训练框架,该框架首次将强化学习(RL)策略优化应用于统一架构的图像编辑模型,是第一个视觉强化学习框架。基于此,他们推出了新一代模型UniWorld-V2。

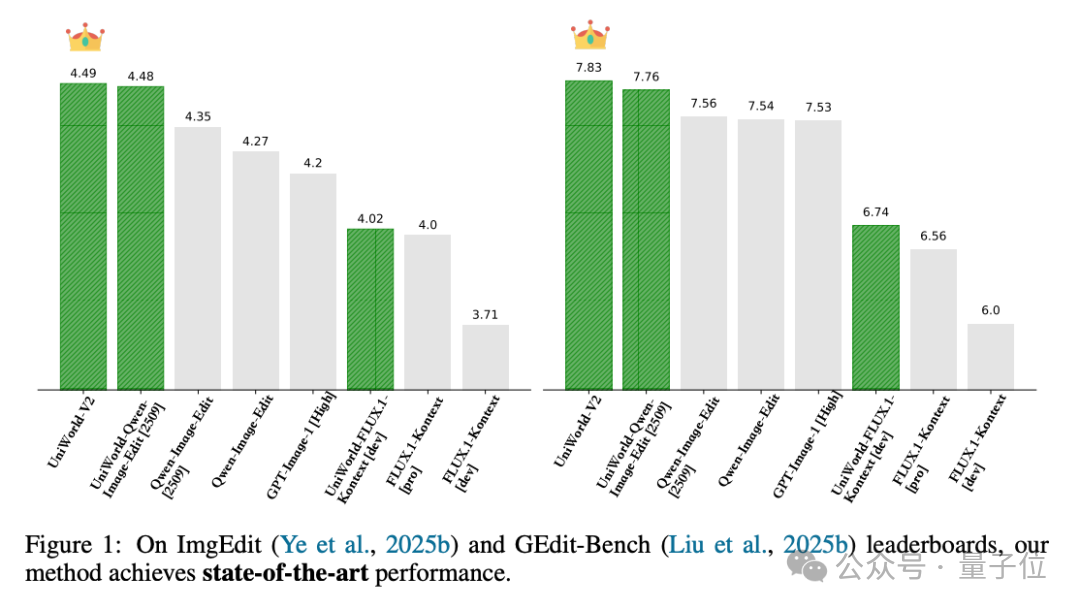

UniWorld-V2在GEdit-Bench和ImgEdit等行业权威基准测试中取得了SOTA成绩,在综合表现上超越了如OpenAI的GPT-Image-1等顶尖闭源模型。

一起来看详细技术报告。

功能上,UniWorld-V2在实际应用中展现了SFT模型难以企及的精细化控制力。

在论文的“海报编辑”示例中,模型能精准理解指令,并渲染出“月满中秋”和“月圆人圆事事圆”等笔画复杂的艺术中文字体,效果清晰、语义准确。

能做到想改啥字改啥字,只需一句Prompt。

在“红框控制”任务中,用户可以通过画框(如红色矩形框)来指定编辑区域,模型能够严格遵守该空间限制,实现“将鸟移出红框”等高难度精细操作。

模型能深刻理解“给场景重新打光”等指令,使物体自然融入场景之中,让画面变得更统一和谐,并且光影融合度极高。

实现以上功能,研究团队的核心创新是提出了UniWorld-R1框架。

传统的图像编辑模型依赖监督微调(SFT),普遍存在对训练数据过拟合、泛化能力差的问题。此外,还存在面对编辑指令和任务的多样性,缺乏通用奖励模型的瓶颈。

UniWorld-R1框架的核心优势在于:

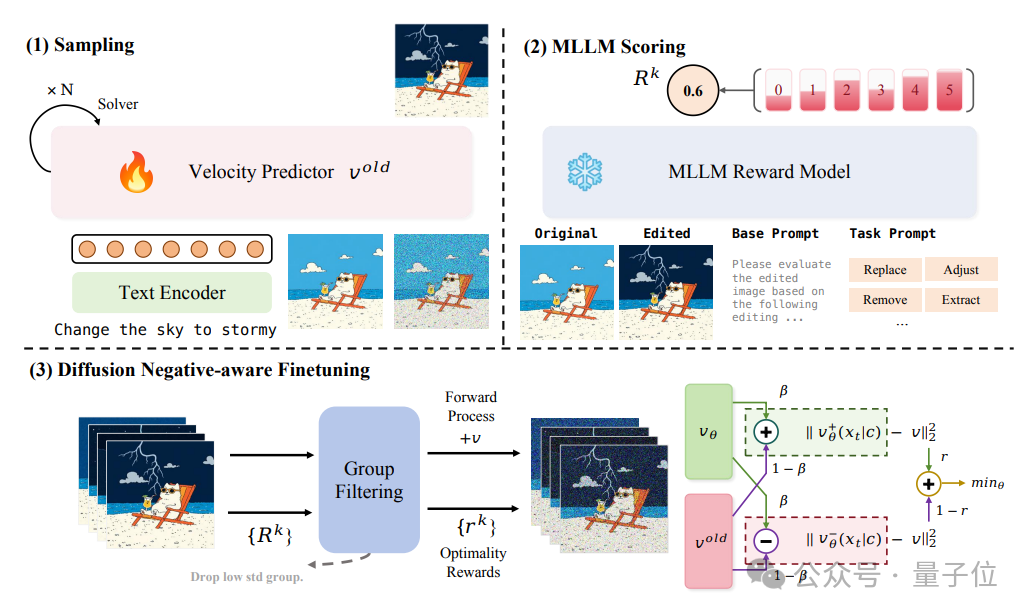

首个基于强化学习的统一架构:UniWorld-R1是业内首个基于策略优化(RL)的图像编辑后期训练框架。它采用了Diffusion Negative-aware Finetuning (扩散负向感知微调,DiffusionNFT)技术,这是一种无需似然估计的策略优化方法,训练更高效,并且允许使用高阶采样器。

MLLM作为免训练奖励模型:针对编辑任务多样性导致缺乏通用奖励模型的挑战,UniWorld-R1开创性地使用多模态大语言模型(MLLM,如GPT-4V)作为统一的、免训练的奖励模型。通过利用MLLM的输出logits(而非单一评分)来提供精细化的隐式反馈,极大地提升了模型对人类意图的对齐能力。

如下图所示,UniWorld-R1的pipeline主要包括三个部分:采样、MLLM评分和DiffusionNFT,这三个部分逐步将模型与最优策略对齐。

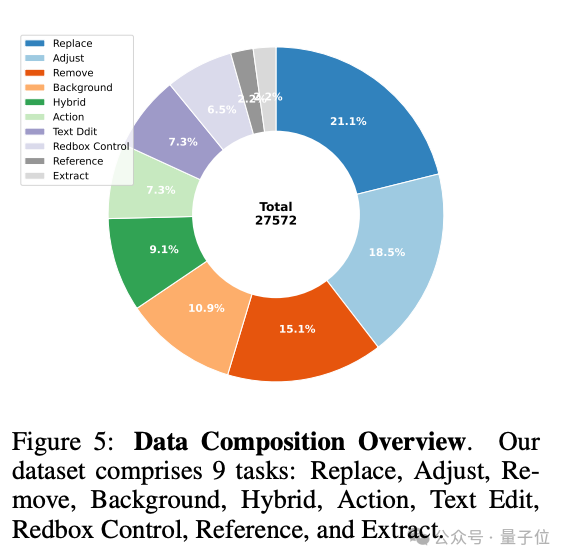

实验方面,研究团队整理了一个包含27572个基于指令的编辑样本的数据集。

这些样本来自LAION、LexArt和UniWorldV1。为了增强任务多样性,加入了额外的文本编辑和红框控制任务,共形成九种不同的任务类型。

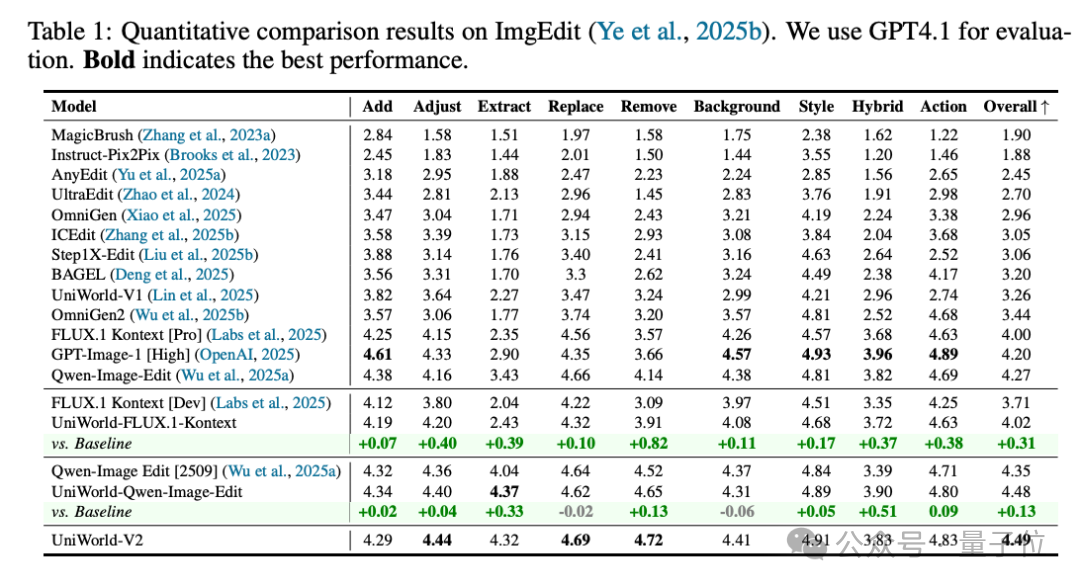

研究团队训练FLUX.1-Kontext [Dev]、Qwen-Image-Edit [2509]和UniWorld-V2作为基础模型,并采用ImgEdit和GEdit-Bench作为测试基准。前者将多种专门任务统一为一个通用框架以进行全面模型比较,后者通过丰富的自然语言指令评估通用图像编辑。

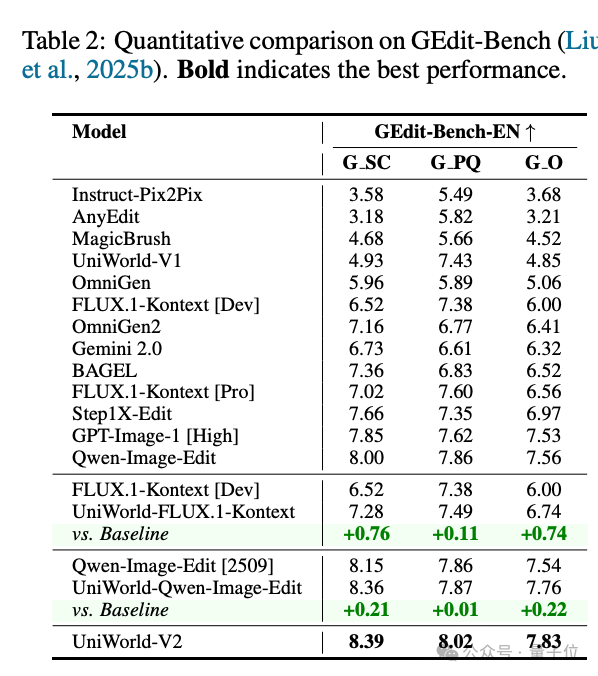

在GEdit-Bench基准测试中,UniWorld-V2(基于UniWorld-R1训练)获得了7.83的惊人高分,显著优于GPT-Image-1 [High](7.53分)和Gemini 2.0(6.32分)。在ImgEdit基准上,UniWorld-V2同样以4.49分领跑,超越了所有已知的开源和闭源模型。

更重要的是,UniWorld-R1框架具有极强的通用性。当该框架被应用于Qwen-Image-Edit和FLUX-Kontext等其他基础模型时,同样带来了显著的性能提升,充分证明了其作为通用后期训练框架的巨大价值。

该方法显著增强了所有基础模型在ImgEdit基准上的表现。对于FLUX.1-Kontext [Dev],整体分数显著提高,从3.71上升到4.02,超过了较强的Pro版本(4.00)。同样,在应用于Qwen-Image-Edit [2509]时,该方法将其分数从4.35提升到4.48,实现了开源模型中的最先进性能,并超越了顶级闭源模型如GPT-Image-1。

除了总得分的提升之外,UniWorld-FLUX.1-Kontext在“调整”、“提取”和“移除”维度上表现出显著的性能提升,而 UniWorld-Qwen-Image-Edit则在“提取”和“混合”维度上表现优异。此外,UniWorld-V2达到了最佳性能。这一现象表明,该方法能够解锁和显著提高基础模型中之前未开发的潜力。

在域外GEdit-Bench上,UniWorld-R1为三种模型展示了强大的泛化性能。它使FLUX.1-Kontext [Dev] 模型的总分从6.00提升到6.74,表现超越了Pro版本(6.56)。对于Qwen-Image模型,其得分从7.54增加到7.76。同时,UniWorld-V2在这一基准测试中建立了新的最先进水平,超越了所有列出的模型,包括Qwen-Image-Edit(7.56)和GPT-Image-1(7.53)。这一结果确认该方法有效地保留和增强了在未见数据分布上的核心编辑能力,展示了强大的泛化能力。

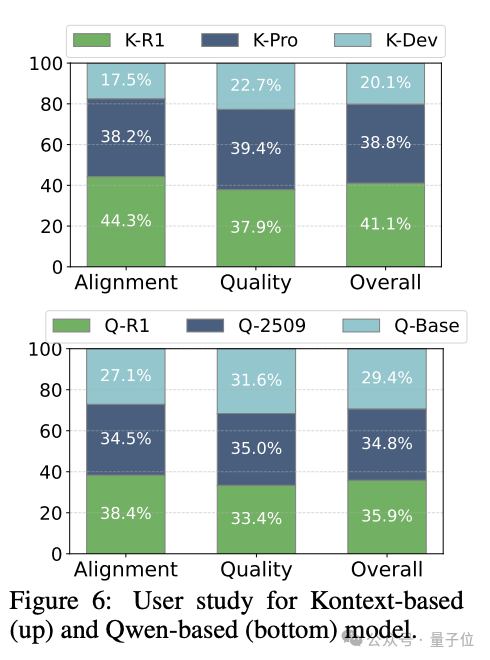

为了全面评估,研究人员还对FLUX.1和Qwen系列进行了人工偏好研究,参与者将本文的微调模型与其基础模型和更强大的版本进行比较。他们被要求在两个维度上选择最佳结果:指令对齐和图像质量。

用户在所有标准中更倾向于选择UniWorld-FLUX.1-Kontext而不是FLUX.1-Kontext [Dev]。此外,它在编辑能力上表现出较强的优势,尤其是在与更强大的官方版本FLUX.1-Kontext [Pro]的比较中。总体而言,UniWorld-FLUX.1-Kontext因其优越的指令遵循能力而获得更多的喜欢,尽管官方模型在图像质量上稍微胜出。这证实了该方法能够有效地引导模型生成更符合人类偏好的输出。

此次发布的UniWorld-V2,是基于团队早先的UniWorld-V1构建的。UniWorld-V1作为业内首个统一理解与生成的模型,其开源时间领先于谷歌Nano Banana等后续知名模型长达三个月,为多模态领域的统一架构探索奠定了重要基础。

另外,UniWorld-R1的论文、代码和模型均已在GitHub和Hugging Face平台公开发布,以支持后续研究。

论文地址:

https://arxiv.org/abs/2510.16888

GitHub链接:

https://github.com/PKU-YuanGroup/UniWorld

文章来自于“量子位”,作者 “允中”。

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0