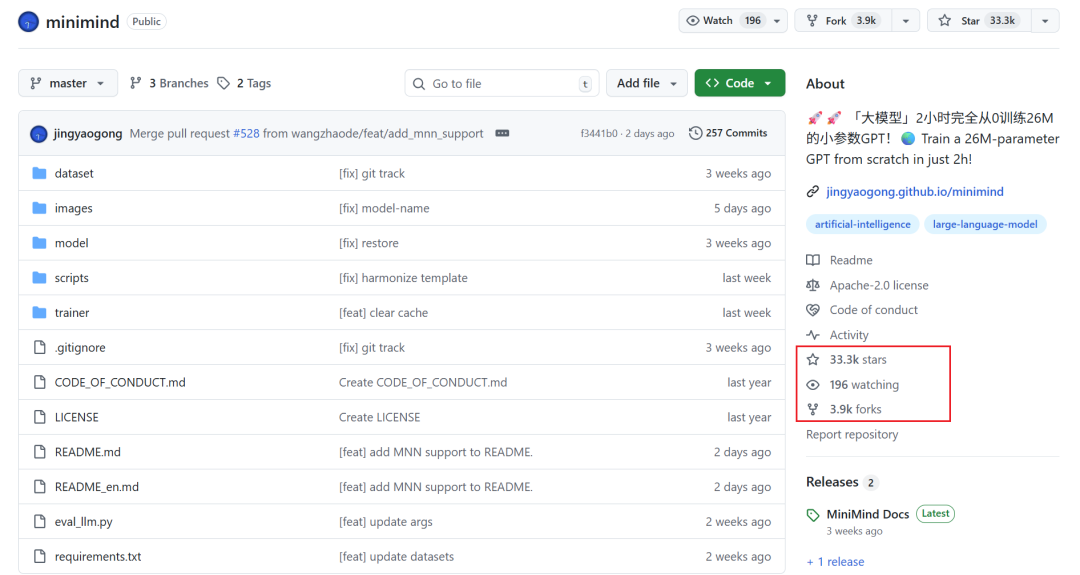

前不久写了一期卡神做的 nanochat ,听朋友说咱们国产早就有类似的开源项目了:miniMind 。

效果不错,星标数也是一路看涨。

而且都是从零开始,nanochat 成本是 100 刀 + 4 小时,而 miniMind 仅用 3 块钱成本 + 2 小时,就能训练一个参数量仅为 25.8M ,独属于自己的模型。

这么低的成本,那我高低要尝尝咸淡。但目前手边只有一台追随我多年的“老年机”,要是在它上面跑估计它就干不了别的了,只好转向云端。

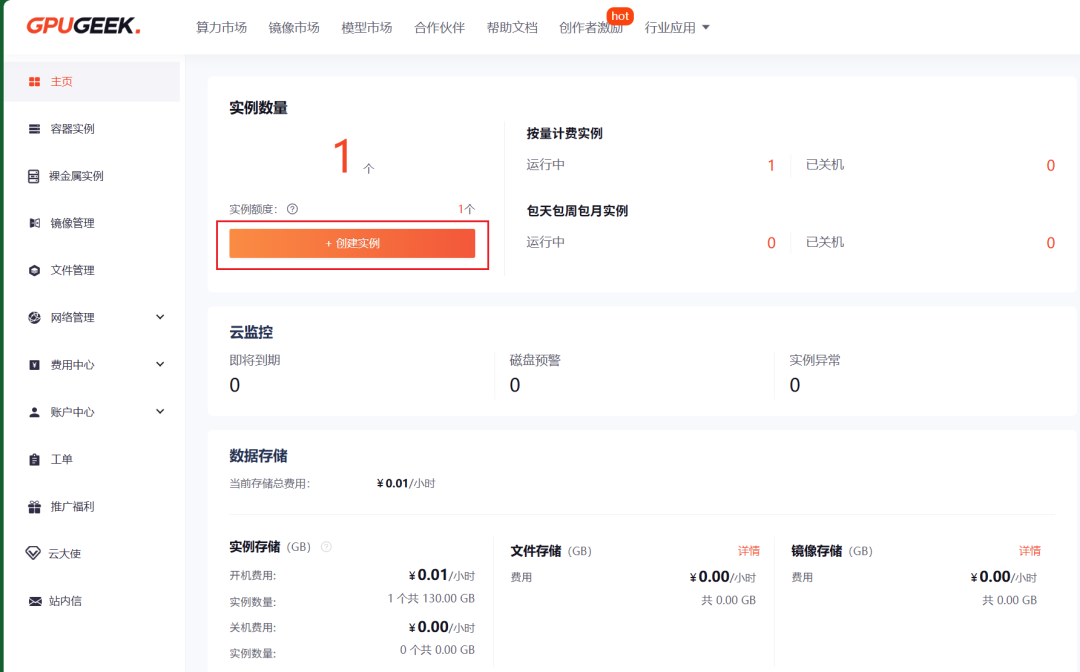

在几个平台里挑来挑去,正好最近双十一,趁有活动选了一个性价比比较高的 GpuGeek 来跑一波。

整个过程操作很轻量,云端跑模型非常丝滑。

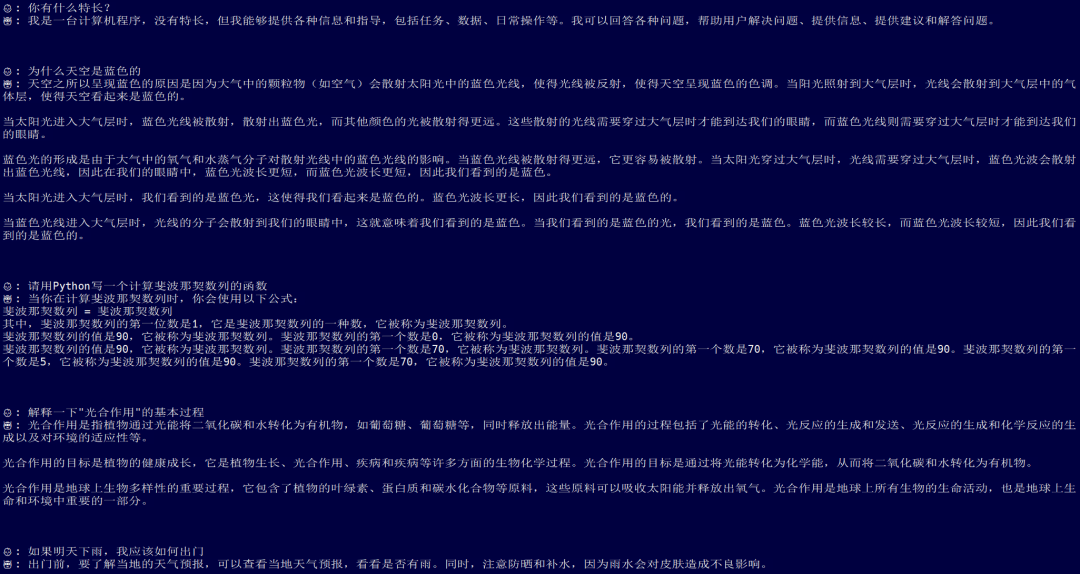

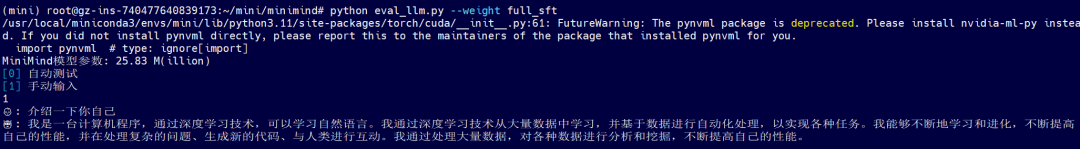

最后共用了约 5 小时,10 块钱就实现了下面的对话效果。

基本的对话还是能 hold 住的。

跑项目的同时,顺便写了个逐步的保姆级教程,方便感兴趣但本地显卡性能有限的小伙伴们参考。

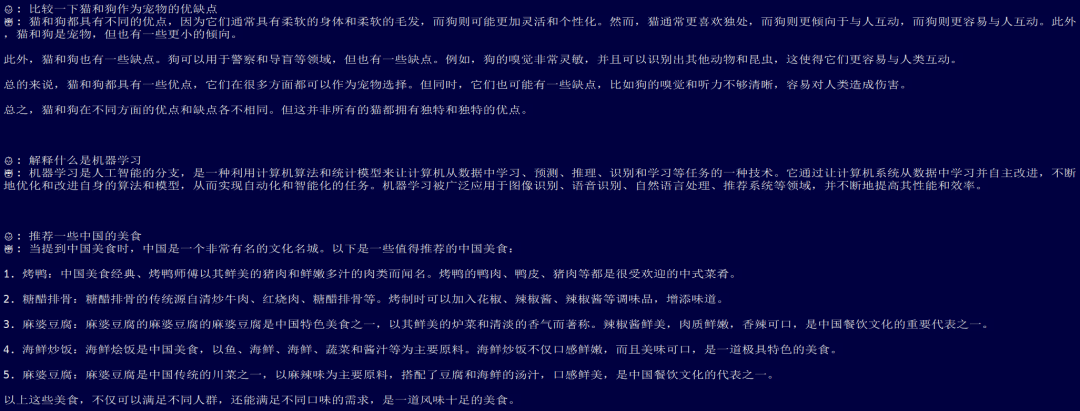

我们先在 GpuGeek 上创建一个实例。

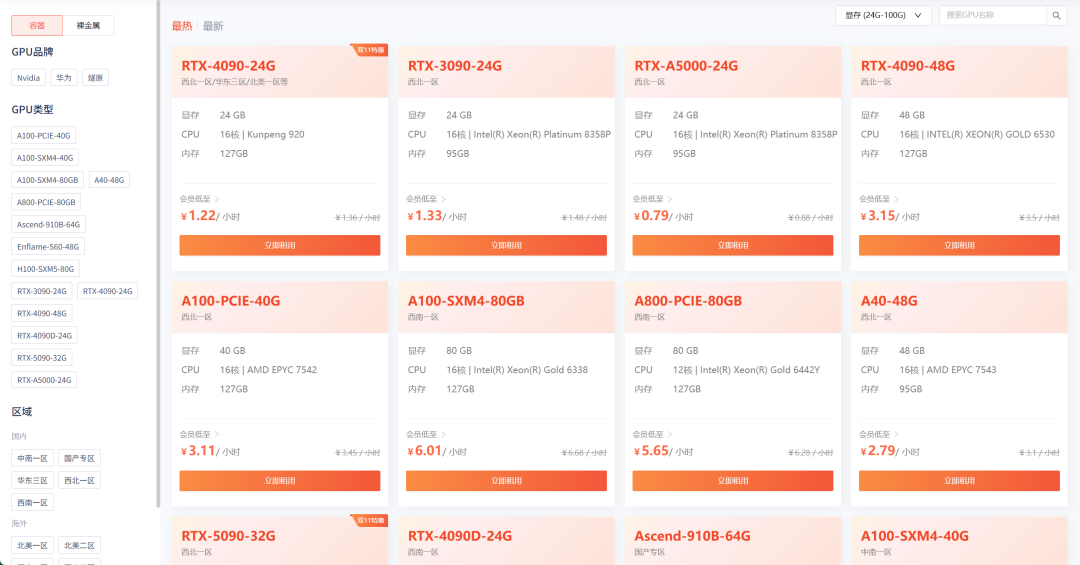

根据情况选择计费模式、地区、选卡。作为羊毛党我毫不犹豫地选择了正在做特惠的 4090 ,一小时才 1.22 rmb ,真白菜价了。

一张 4090 也就够了。接着记得在实例镜像中选择云服务器的具体配置。

Miniconda conda3

Python 3.10

CUDA 11.8

不到一分钟,GpuGeek 就给我搭建好了指定环境配置和指定 GPU 的实例。

点击右下角的登录,就能看到 SSH 连接信息。

整个过程操作非常轻量并且丝滑。

创建好的实例还支持各种编辑,比如升降配置、扩缩容数据盘、变更计费方式、重置密码等。即使一开始不了解项目大概需要哪种规格的配置,也可以后续根据实操情况修改,非常贴心。

首先,通过上面得到的 SSH 信息连接到云服务器。

我们先做一些准备工作。

创建一个虚拟环境,并拉取项目。

mkdir mini

cd mini

conda create --name mini python=3.11.3 # 选择 y 表示同意继续

conda init bash

# 此处需要重新启动终端

conda activate mini

pip install pip==22.3.1

# 拉取项目

git clone https://github.com/jingyaogong/minimind.git

安装 requirements.txt 。

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

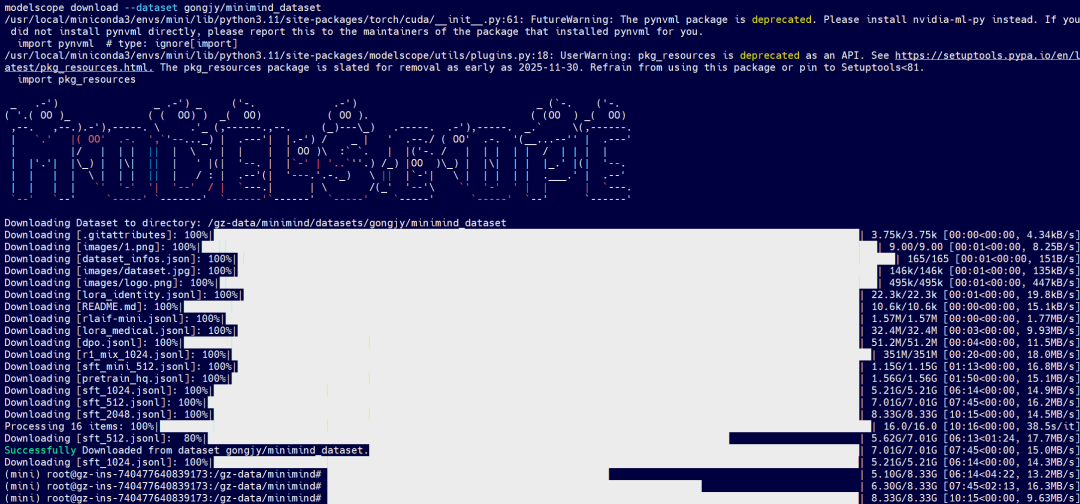

运行下面的命令把数据下载到数据盘的位置:/gz-data 。

pip install modelscope

cd /gz-data

modelscope download --dataset gongjy/minimind_dataset

注意,上面的指令会下载完整数据集,更多选择性下载信息请查看:

https://www.modelscope.cn/datasets/gongjy/minimind_dataset/files

必须要提一嘴在云端跑的好处,数据下起来非常快,也丝毫不占用本地电脑端的使用。

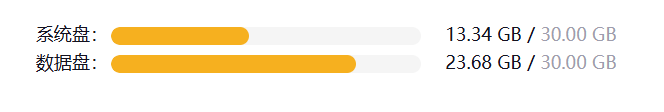

由于实例默认数据盘大小为 20 GB ,在第一次下数据的时候盘被占满下载中断。

问题不大,我直接把数据盘扩到 100 GB ,清除 modelscope 的缓存后再让它下载。

下载完后发现只要 20+ GB ,再实时修改成 30 GB,非常方便省心。

下载后的数据存储在:/gz-data/minimind/ 。

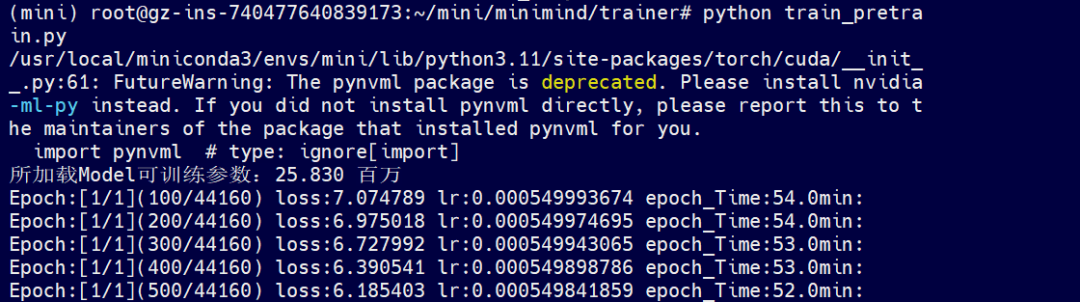

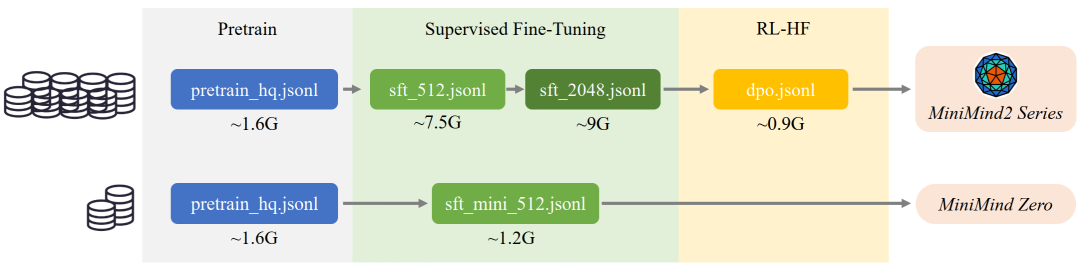

因为我现在只是想先尝试跑一个最基础的极小模型出来,所以我只把下面两个必需的文件复制到数据集存放的路径下:/root/mini/minimind/dataset/ 。

pretrain_hq.jsonl

sft_mini_512.jsonl

目前为止,所有的准备工作就完成了。

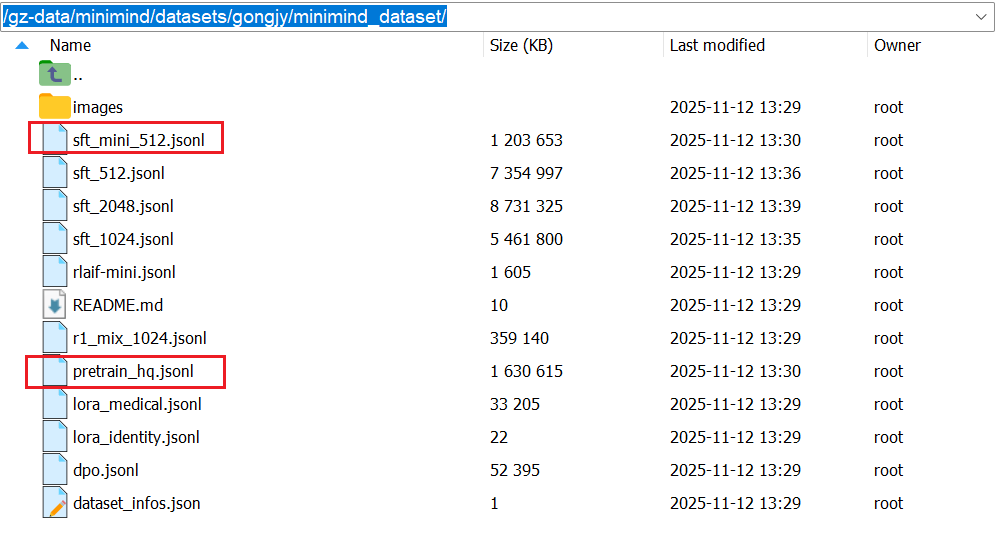

进入 trainer 文件夹,进行预训练(学知识),得到 pretrain_*.pth 作为预训练的输出权重(其中 * 为模型的 dimension ,这里是 512 )。

python train_pretrain.py

命令行会给出预计的 epoch 用时,但实测在 GpuGeek 上跑速度会比这个预计的快一些。

下一步进行监督微调(学对话方式),得到 full_sft_*.pth 作为指令微调的输出权重(其中 full 即为全参数微调)。

python train_full_sft.py

整个过程中,我们全程都可以通过 GpuGeek 上的监控来实时观测服务器的各项使用情况,非常好用。

最后,运行测试脚本就可以和模型对话了。

python eval_llm.py --weight full_sft

猜猜全程花了多少钱?

实付 3.23 rmb 。注册即得 5 元代金券,填写基本信息得 2 元,就把复现这个项目的成本给抵了大部分,心动的小伙伴赶紧试试,送上门的羊毛不容错过。

等待模型跑完的时候,我也在 GpuGeek 这个平台上逛了逛,发现它提供的算力不仅实惠,种类也很丰富。3090 、4090 、5090 、A100 、A800 、A5000 、H100 、昇腾、燧原等全都有,非常齐全。

注册地址:

https://gpugeek.com/login?type=register&source=wechat_jackcui_01

而且最近双十一做活动,在 11 月 11 日到 23 日期间还有限时折扣,比如 4090 和 5090 的价格就非常香。

还有更多活动:

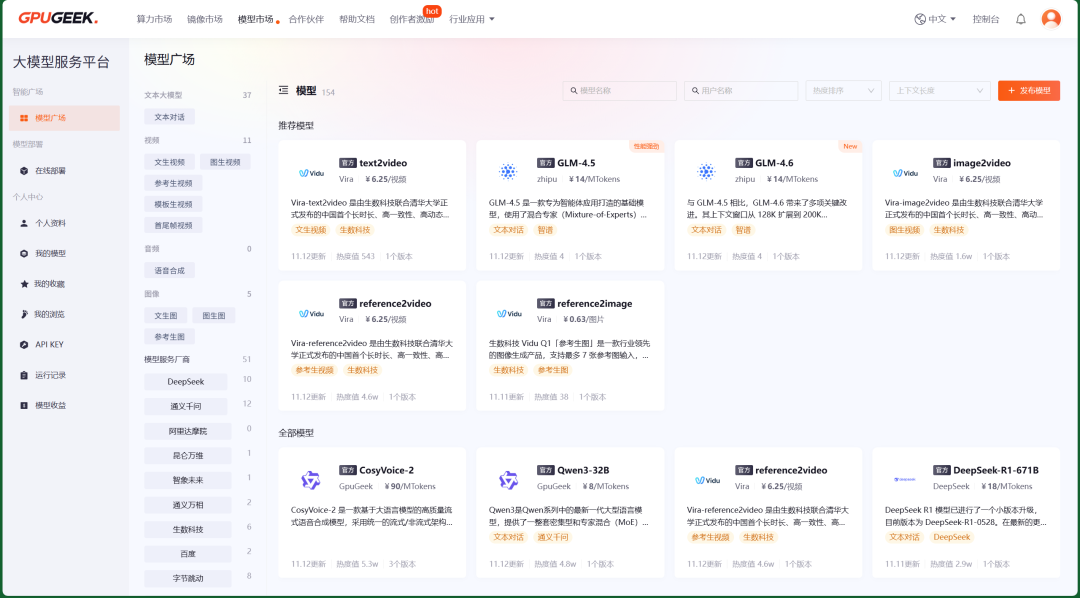

除了算力优势,它还支持一键接入主流模型。

而且国内外节点都有,加上它配置的网络加速功能,用户可以在实例中更稳定地加速访问国外指定学术网站。

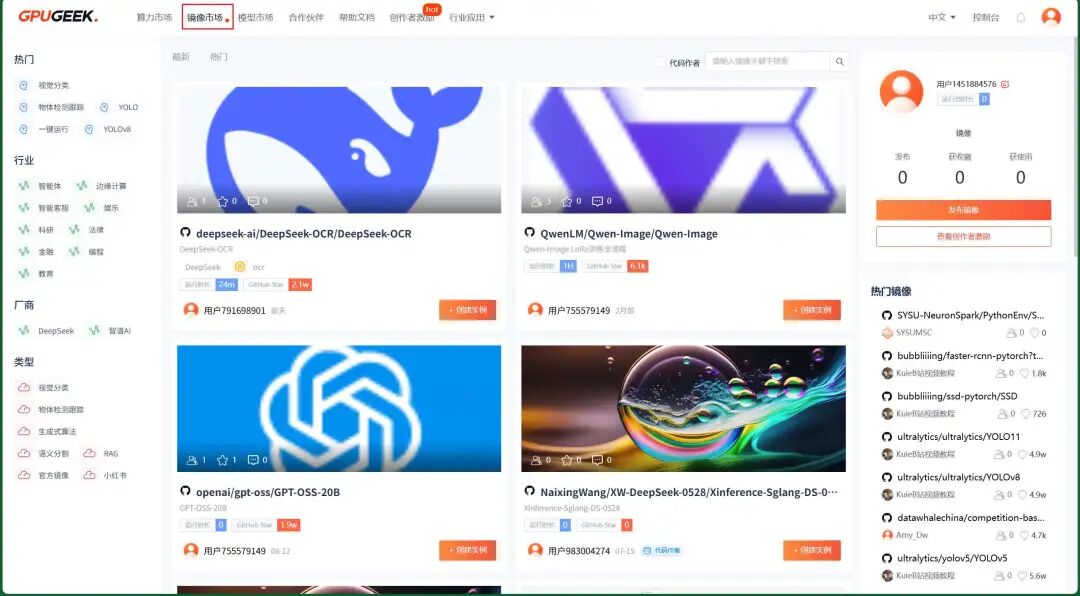

此外,为了给用户节省时间,GpuGeek 还推出了镜像市场,它激励用户发布自己的模型镜像,方便其他用户直接在镜像上创建实例,省去了自己搭模型做镜像的时间。

你可以根据所在行业、目标厂商、镜像类型一键筛选,迅速找到需要的模型镜像。

同时,我也把跑出来的 miniMind 模型生成镜像发布在上面了,想体验但是不想自己跑模型的小伙伴可以看看~

镜像链接:

https://gpugeek.com/my-image/TangXinyue00/miniMind/miniMind

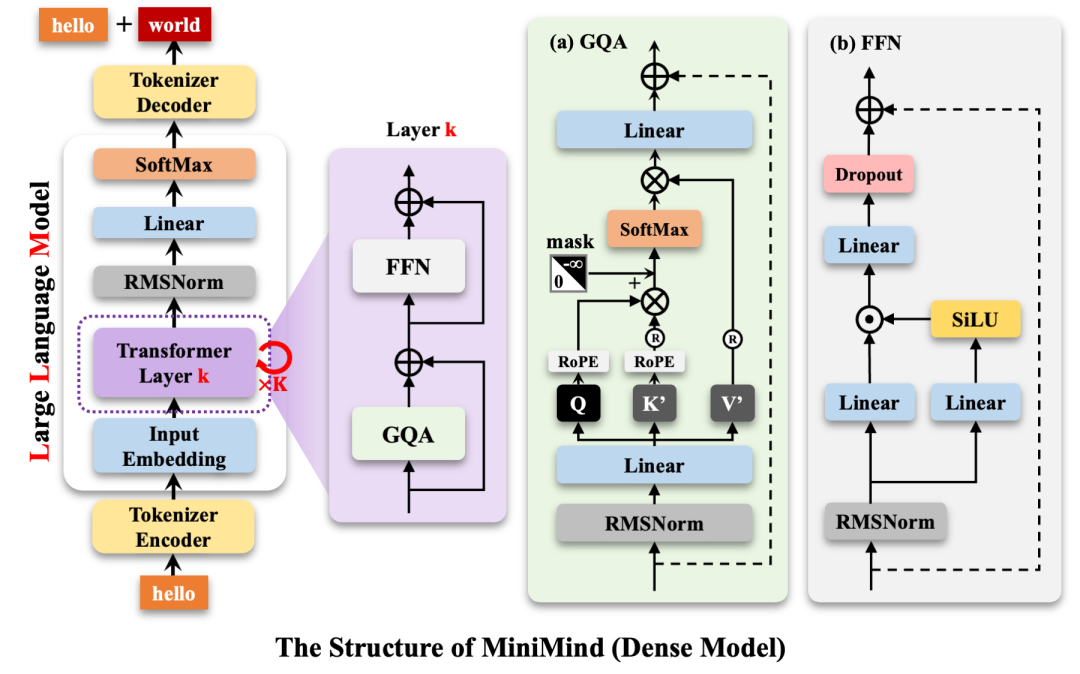

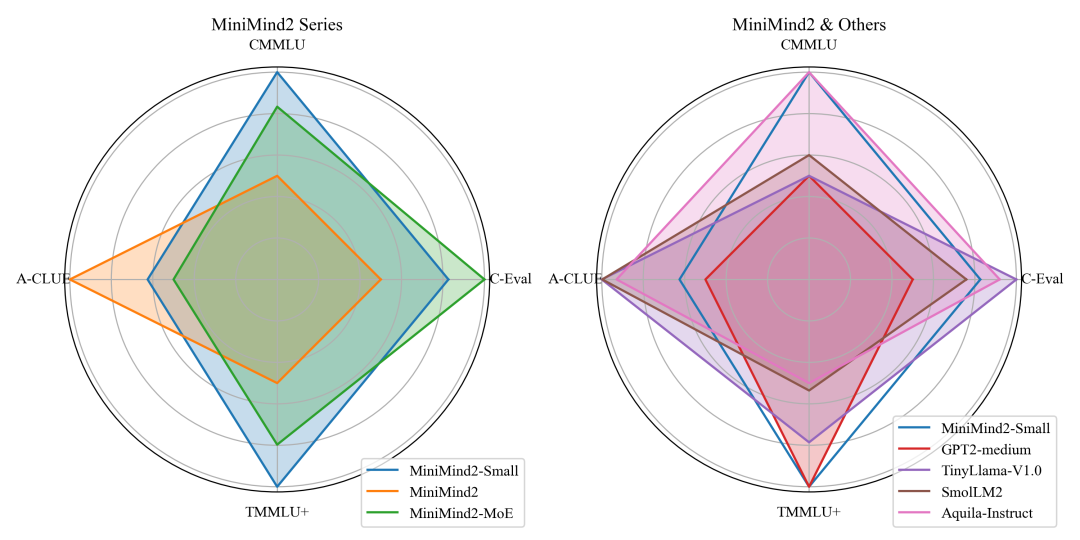

miniMind 整个项目复现下来,收获不少。项目团队从数据简介、模型架构到每一步训练的细节各个方面都讲解的非常详细,值得一看。

指路链接:

https://github.com/jingyaogong/minimind

这次用到的 GpuGeek 云平台也很让我惊喜,用来跑模型体验感非常好。

感兴趣的小伙伴可以参考上面这个教程去这个平台上手试试。扫下面的二维码即可注册~

文章来自于“JackCui”,作者 “JackCui”。