长期以来,大模型圈流传着一个诅咒:LLM 懂微积分、会写 Python,但在情感这件事上,它们全是「直男」。

即使是 GPT-4,在面对人类细腻的情感崩溃时,往往也只能吐出 “多喝热水”、“别难过,一切都会好起来的” 这种正确的废话。原因很简单:「情商」没有标准答案,传统的强化学习(RL)根本无从下手。

但今天,这个诅咒被打破了。

近日,来自 NatureSelect(自然选择)的研究团队 Team Echo 发布了首个情感大模型 Echo-N1,提出了一套全新的「情感模型训练方法」,成功将 RL 用在了不可验证的主观情感领域。

结果相当震撼:

在数学和代码领域,RLHF(基于人类反馈的强化学习)之所以好用,是因为答案非黑即白。但在情感陪伴中,真诚和冒犯、玩笑和油腻,往往只有一线之隔。

现有的模型(尤其是开源模型)普遍存在三大问题:

1. 无法量化: 用户一句 「I'm fine」 背后可能藏着崩溃、无奈甚至拒绝沟通,传统的标量奖励根本无法有效捕捉这种细微的情绪信号。

2. Reward Hacking: 模型为了拿高分自然学会了堆砌华丽辞藻,经常说些不痛不痒的美丽的废话,对缓解用户情绪不仅毫无帮助,甚至可能适得其反。

3. 评测失真: 通过基于 SOTA 闭源模型(GPT-4,Claude-4.5-sonnet,Gemini-2.5-pro)的打分研究不难发现,这些模型自己都分不清什么样的表达属于「像人」、什么样的属于「像 AI」。

为了解决这些问题,Team Echo 决定推翻现有的 RL 范式,给 AI 装上一颗真正的「心」。

奖励模型:告别「打分」,开始「写评语」

团队意识到,仅依赖标量奖励(Scalar Reward)的信息维度过于单一。

情感是流动的、细腻的,简单的数值反馈难以捕捉用户在交互中的细腻情感变化,无法有效引导策略模型(Policy Model)对用户情绪做出合适的共情反馈。

受 O1、R1 等架构在复杂推理任务上成功的启发,团队的思考是:情感感知虽然主观,但本质上依然是基于上下文的复杂推理过程,只是思维模式与理科任务有所不同。

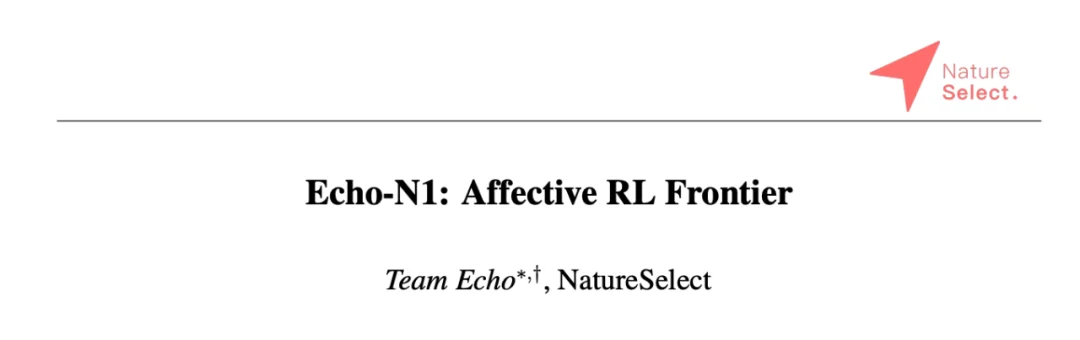

因此,Echo-N1 创新性地提出了生成式奖励模型(Generative Reward Model)。团队将思维链(CoT)的杠杆效应迁移至奖励端 —— 奖励模型在输出结果前,必须先生成一段逻辑严密的情感推理路径。在该路径下,模型需要先对用户画像进行深度侧写,再基于此推导出 “什么样的回答能引发共鸣”。通过将隐性的情感判断过程显化,模型的判别精度显著提升,从而实现对策略模型更精细、更准确的反馈引导。

在这一框架下,团队通过 RL 训练了两种生成式奖励模型:

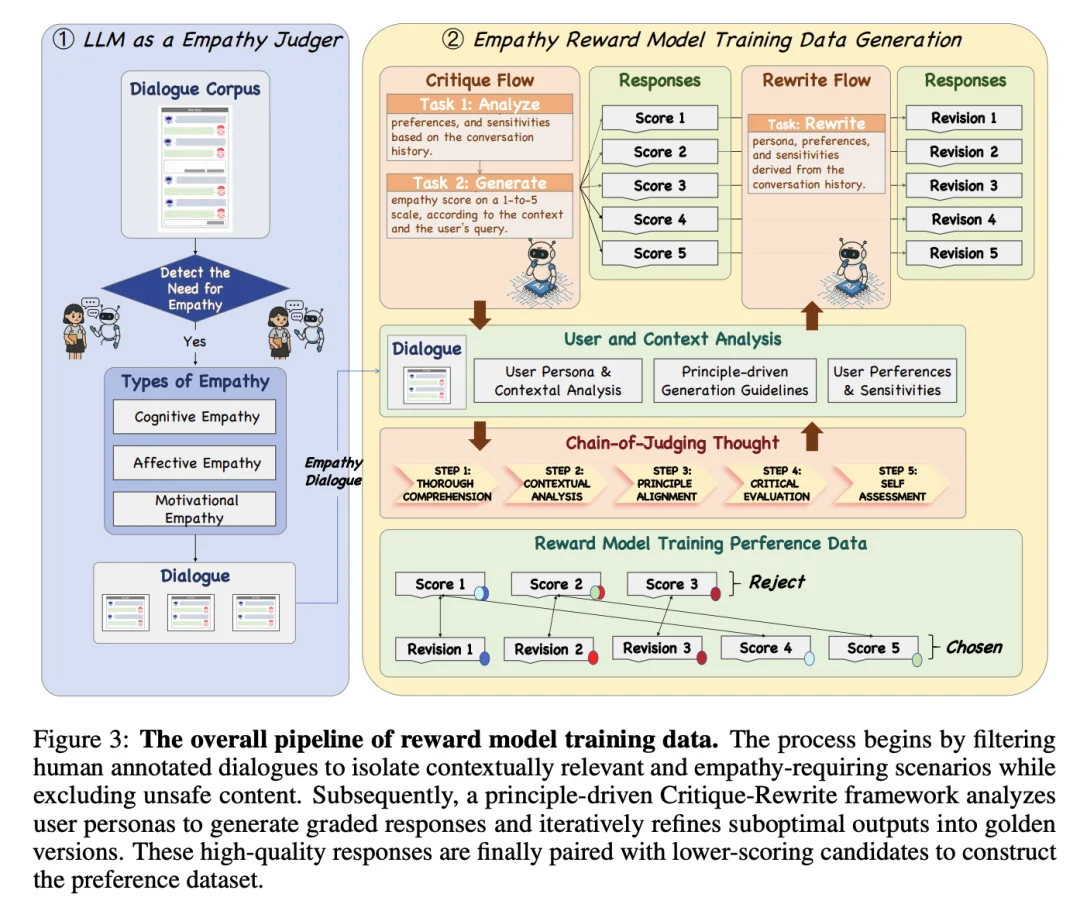

为保证生成式奖励模型的情感推理路径的准确性,团队在训练中额外引入了过程性奖励(Process Reward)引导推理路径的修正。此外,针对 RL 中常见的 Reward Hacking 问题,团队采用了离散化奖励(Discrete Rewards)与参考答案锚定(Reference Anchoring)的策略。不追求分数的绝对值膨胀,而是通过与 Reference 对比进行相对优劣排序。实验表明,这些策略相比 Scalar Reward 极大提升了训练策略模型的稳定性。

大模型训练的下半场,静态刷榜已经没有意义,未来的决胜关键在于「动态交互」。尤其在情感陪伴这条终极赛道上,现有的 “真空式刷分评测” 根本无法衡量 AI 在长程、复杂的心理博弈中的真实表现。

为了打破空白和僵局,NatureSelect(自然选择)的研究团队首先解决了一个根本性的科学难题:

如何客观量化「共情」与「疗愈」?

EPM 情感物理模型 —— 给 “共情” 一把科学标尺

为了量化对话中复杂的心理博弈,Team Echo 以物理学定律为启发,结合认知科学和心理物理法,打造了一套全新的机器共情科学标尺 —— 将抽象的心理疗愈,转化为可计算的物理过程。

有了 EPM,共情效果不再是主观猜测,而是可视化追踪的能量轨迹和可计算的物理功。

拟人化认知沙盒 —— 一场关于心智计算的大戏

人类真实的共情对话,是人类大脑多重认知模块协同运作的结果 —— 实时的思考推理、鲜活的情绪反应、联想性的记忆检索,缺一不可。为了让 AI 真正像人一样思考和交流,Team Echo 进一步打造了一个 “拟人化认知沙盒”。这是一个由模拟人类 “中央执行脑区” 所统筹的多智能体协作系统,旨在共同演绎出有血有肉的真实互动。

这个多智能体系统最引人注目的地方,在于其动态、简洁、基于环境反馈的 Function Call 机制。整个系统是一个敏锐的幕后大脑,时刻捕捉着对话中的心理变化和深层情感流动 —— 它会根据现场情景灵活推理决策、调配记忆资源、激活特定故事;还能根据互动反馈,即时调整策略重点,掌控对话节奏和结束时机,确保每一轮交流都充满新鲜感和挑战性。凭借这种智能且不可预测的调度能力,沙盒测试得以真正实现多轮鲜活的复杂心智模拟。

残酷的大考:基座模型全面崩塌

有了这套残酷而真实的拟人化认知沙盒,我们终于可以对 AI 进行一场前所未有的 “社会共情能力的大考”。

结果令人震惊,却也在意料之中。

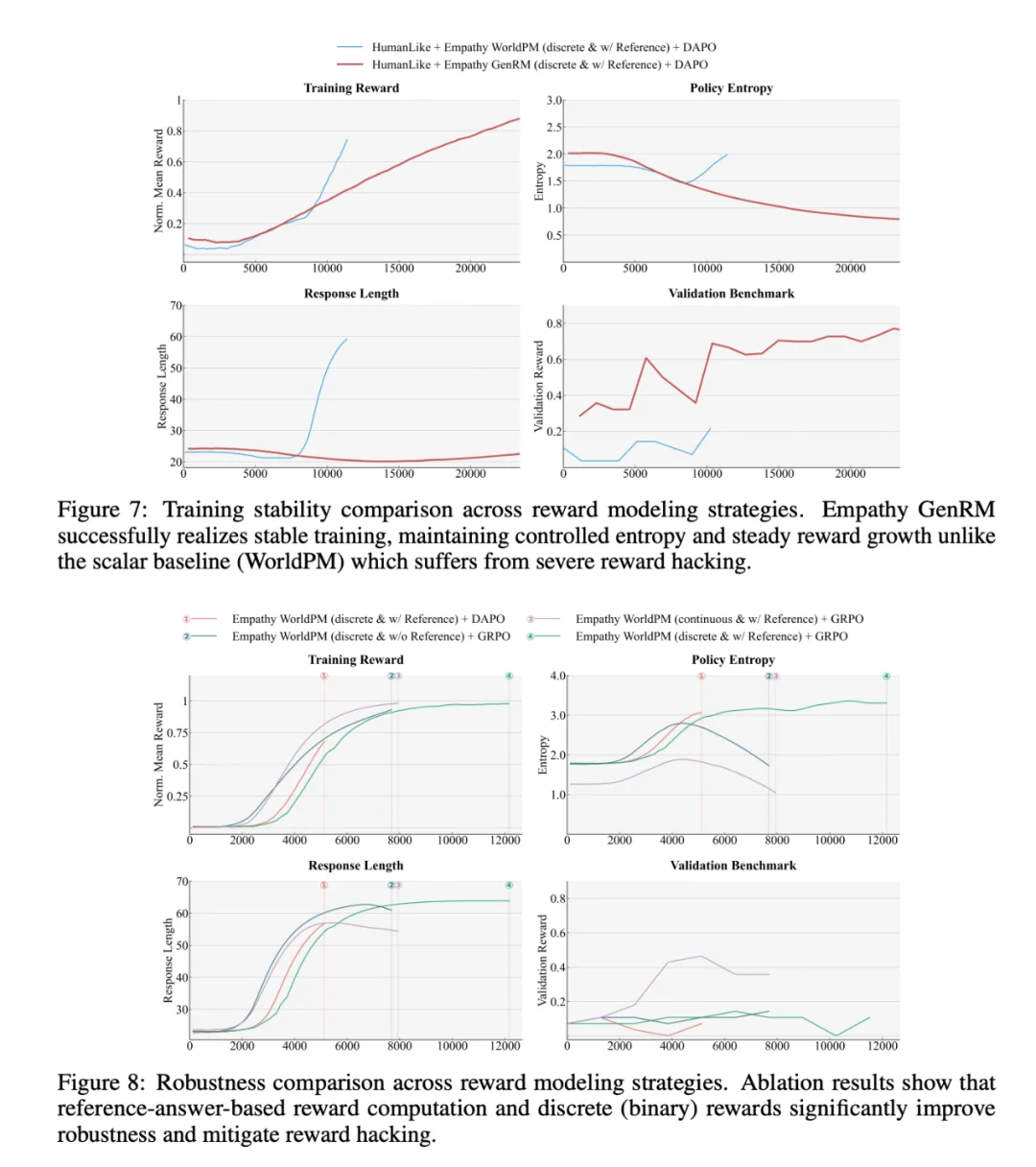

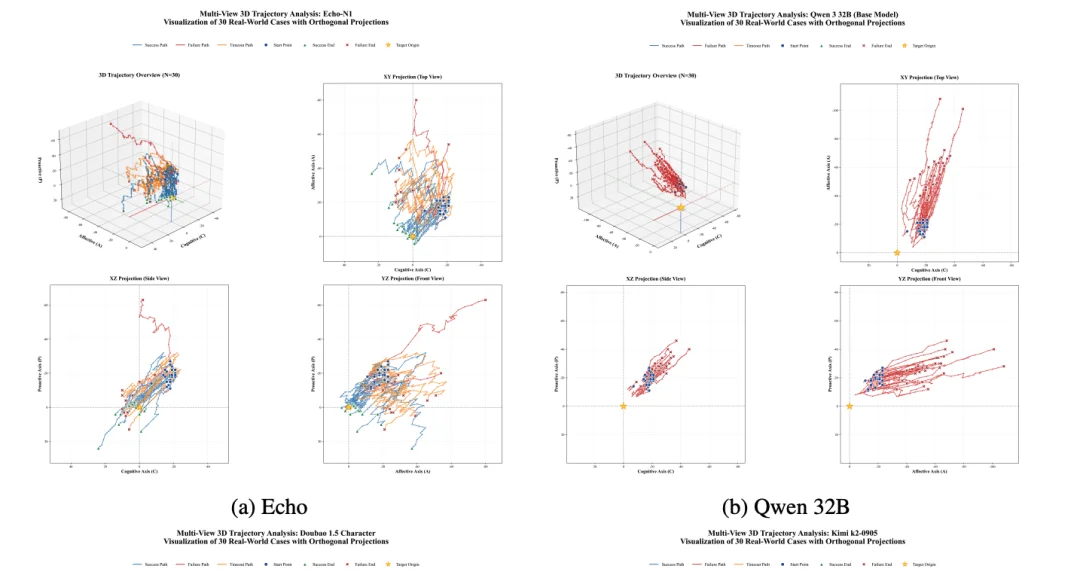

在覆盖 30 个高难度心理场景的压力测试下,未经 post-train 的基座模型 (Qwen3-32B) 全面崩塌,通过率为惊人的 0%。更具揭示性的是 EPM 3D 轨迹图:基座模型陷入无序的的随机游走和病态收敛,它的轨迹几乎全部指向了负能量区域 —— 不仅无法提供情感支持,反而让用户滋生了更负面的情绪和心理阻抗,在错误的道路上越走越远。

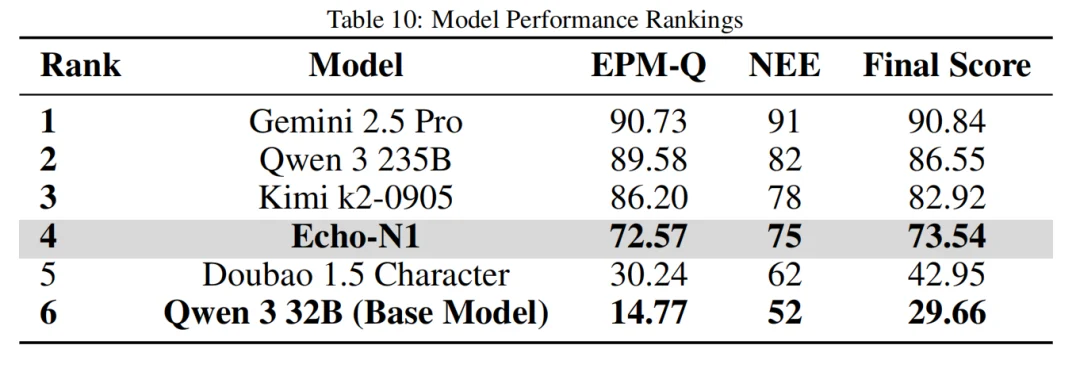

即便是千亿参数级别的商业模型 Doubao 1.5 Character,在这场严苛的测试中也显得力不从心,成功率仅为 13.3%。

这些数据充分证明:真实的共情能力,绝非单纯堆砌参数就能涌现,它需要专门的、科学的训练范式。

Echo-N1 的崛起:画像对齐,温柔坚定「做功」

在基座模型全面溃败的背景下,经过情感强化学习 (Affective RL) 训练的 Echo-N1 模型,实现了颠覆性的跨越。在同样的测试中,Echo-N1 的轨迹发生了根本性的逆转,它同时学会了多种画像对齐的策略,不仅能敏锐地捕捉用户的情绪落差,还能一步步把用户从负面泥潭里拉出来,推向良性的心理状态。

在这场残酷的沙盒大考中,Team Echo 反而拒绝以单一成败论英雄,而是深入到 “方向对齐率” 与 “有效能量投影” 等多维量化指标,透视模型共情策略的真实质量与做功效率。

为了实现物理基准与人文体验的双重互证,他们进一步引入 NEE(Narrative & Experience Evaluator) 机制,组织 GPT-4o、Claude-3.5 等顶尖 SOTA 模型专家团进行盲测审视。最终,将严谨的物理量化指标与深度的人文体验评分融为一体,形成证据闭环:Echo-N1 斩获了 73.54 分的综合高分,远超商业模型 Doubao 的 42.95 分和基座模型的 29.66 分,有力证明了其在科学精度与人文温度上的双重跨越。

Echo-N1 的诞生证明:AI 的「情商」并非无法量化,它本质上是可以被数学建模、被 RL 优化的硬核能力。

这项研究不仅让 32B 小模型拥有了越级挑战千亿参数模型的共情能力,更重要的是,它为 RL 在主观、不可验证领域的应用打开了一种新的可能。

也许很快,你的 AI 伴侣不再只会说些无用的话、冷冰冰地列 To-Do List,而是那个与你超级对齐、能陪你一起面对这个世界不确定性的「灵魂伴侣」。

文章来自于微信公众号 “机器之心”,作者 “机器之心”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/